GLM5带10个题目挑战Claude4.6编程宝座 !

年底实在是太热闹了,小龙虾还没玩明白,即梦 2.0 又刷屏了。

然后 GLM-5 也突然发布了。

GLM 算是找对方向了,专注编程领域,咬住 Claude 不放。

这次官方推文的第一句话是:From Vibe Coding to Agentic Engineering。

翻译一下就是从氛围编程进化到了智能体工程。

也就是从玩具变成了专业工具了。

然后介绍了一些细节:

GLM-5 专为复杂系统工程和长时程代理任务而构建。与 GLM-4.5 相比,它从 355B 参数(32B 活跃)扩展到 744B(40B 活跃),预训练数据从 23T 增长到 28.5T 个 token。

数据更多,模型更大,就是为了和世界顶级模型掰手腕。

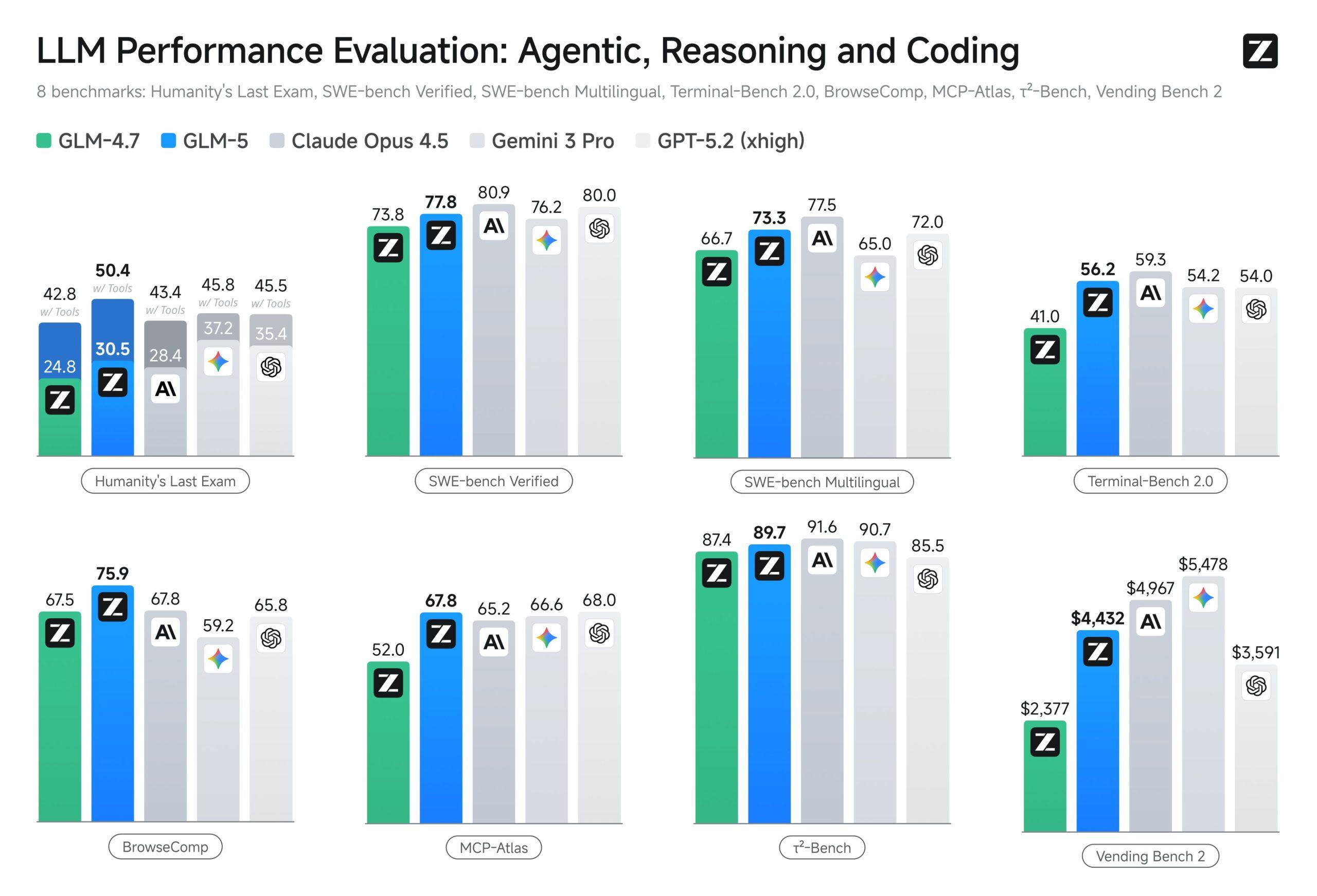

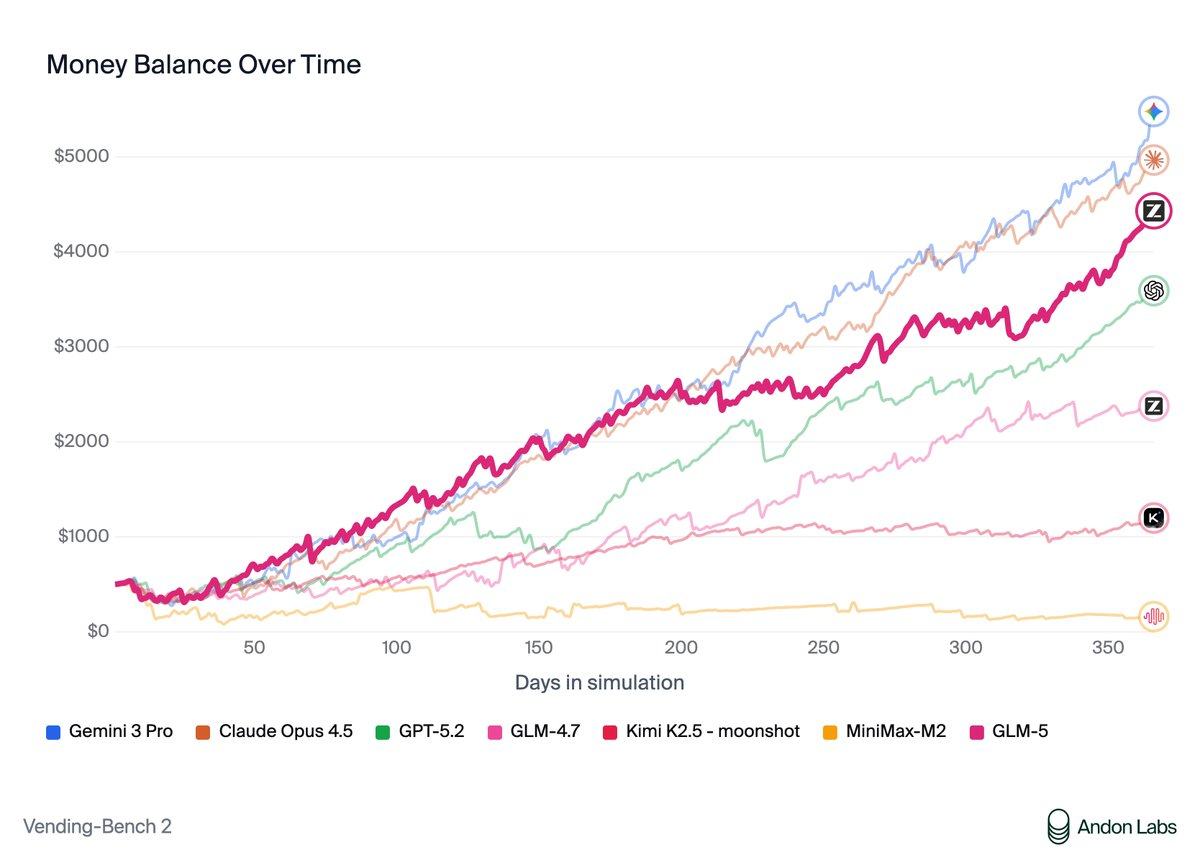

在自动售货机基准测试 2 中,GLM-5 在开源模型中排名第一,最终账户余额为 4432 美元。接近 Claude Opus 4.5 的水平,展现出强大的长期规划和资源管理能力。

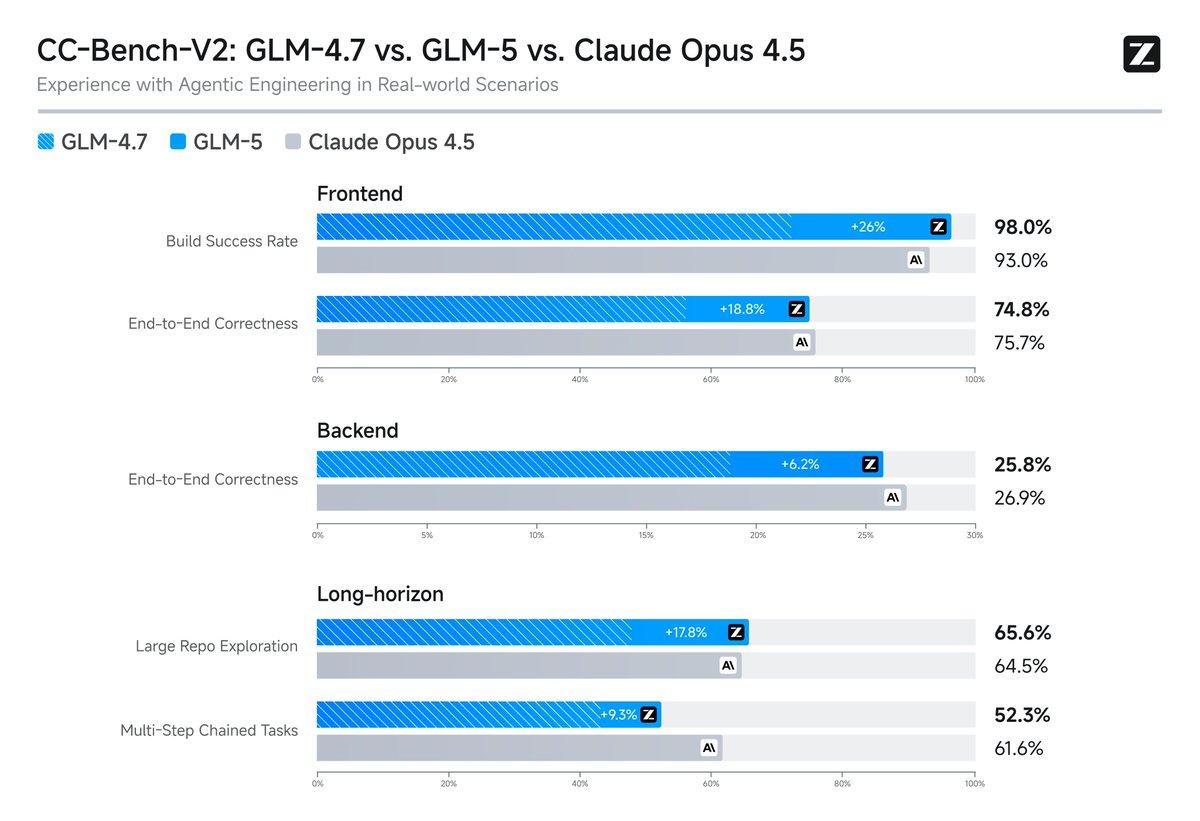

在他们的内部评估套件 CC-Bench-V2 中,GLM-5 在前端、后端和长期任务上均显著优于 GLM-4.7,并缩小了与 Claude Opus 4.5 的差距。

官方说话还算稳重,只是说缩小了与 Claude Opus 4.5 的差距。

但是智谱的目标也很清晰了,就是要挑战 Claude。这个方向非常正确,只有找到了目标和对标,才能快速进步。

那么,问题来了。他们之间的差距具体还有多少?GLM-5 要如何证明自己的实力?

我突发奇想,问了 GLM-5 一个问题:“听说你是奔着对标 Claude 4.5 去的,请你在最擅长的几个领域出 5 个题目,去和它 PK,证明自己的在智能体和编程方面的实力”。

对于这个问题,它先去收集了一下数据。

它查到了 Anthropic 刚刚发布了 Claude Opus 4.6,其在编程、智能体任务持久性以及 Office 办公集成方面展现了极强的实力,特别是在 ARC-AGI-2 测试中取得了 68.8% 的高分,并支持 100 万 token 上下文。

若要在此刻与这一“编程之王”进行对标 PK,我将围绕 复杂代码架构、长时智能体任务、多模态数据处理、自我纠错能力及极限上下文理解 这五个核心维度,提出以下 5 道极具挑战性的题目。

下面,我就把题目列一下,看看 GLM-5 会出什么样的题目。

注意一个点啊,虽然官方是对标 Opus 4.5,但是 GLM-5 已经把 Opus 4.6 列为目标对手了,所以最后我也会用最新模型 VS 最新模型。

极限代码架构:“百万级单体重构挑战”

背景:针对 Claude Opus 4.6 支持的 100 万 token 上下文能力。

题目内容:

给定一个拥有 10 年历史、超过 50 万行代码的遗留 Java 单体应用代码库(包含杂乱的依赖关系和缺失的文档),请在一个上下文窗口内完成以下任务:

1. 构建完整的依赖关系图谱,识别出所有的循环依赖。

2. 将核心订单模块拆分为独立的微服务架构(Go 语言),确保数据库事务的一致性。

3. 生成迁移脚本,保证原系统零停机时间切换。 **挑战点:** 在百万 token 级别下保持逻辑的连贯性,不被海量噪音代码干扰,精准完成跨语言重构。

哈哈。这一题做下来,我基本上就破产了!

长时智能体:“30小时自动驾驶系统开发”

背景:针对 Claude Sonnet 4.5 曾展示的 30 小时连续编程能力及 Opus 4.6 的 Agent 规划能力。

题目内容:

请作为一个独立的项目团队(PM+架构师+开发+测试),为一个微型自动驾驶玩具车编写完整的操作系统。

**要求:**

1. 从零开始编写实时操作系统内核。

2. 集成计算机视觉模块(识别红绿灯、车道线)。

3. 模拟仿真测试通过后,生成可直接烧录的固件代码。整个过程需连续执行,中间不允许人工干预,遇到错误需利用“自我纠错”机制自动调试修复。

**挑战点:** 考验智能体的持久执行力、多模块协同规划能力以及自动化调试的深度。

这也是一个可以让我破产的项目。

办公自动化:“供应链数据法医分析”

背景:针对 Opus 4.6 新集成的 Excel/PPT 办公能力。

题目内容:

现有一个包含过去 5 年全球供应链数据的混乱文件夹,内含 200 个格式不一的 Excel 表格(部分数据损坏或格式错误)。

**要求:**

1. 自动遍历并清洗所有数据,修复逻辑错误(如某季度数据异常波动)。

2. 在 Excel 中建立动态仪表盘,实时关联各表格数据。

3. 同时生成一份 PPT 报告,要求根据品牌规范自动调整布局、字体,并针对发现的异常数据生成折线图和归因分析。

**挑战点:** 考验非代码环境下的工具调用能力、数据清洗逻辑以及多软件协同工作的准确性。

这个我是很想测试,但是没有这个数据。

复杂逻辑推理:“海森堡 Bug 修复”

背景:针对 Claude Opus 4.6 强调的精准代码审查与调试能力。

题目内容:

提供一个高并发分布式电商系统的源码,其中隐藏着一个极难复现的“海森堡 Bug”:该 Bug 仅在每百万次请求中随机出现一次,且会导致库存数据出现微小的数值偏差(如少了 0.001 个库存)。

**要求:**

1. 不通过简单的日志排查,而是通过静态代码分析,定位出潜在的竞态条件或浮点数计算陷阱。

2. 编写一个能够 100% 复现该 Bug 的单元测试用例。

3. 提出修复方案,并证明该方案在高并发下不会引入性能瓶颈。

**挑战点:** 考察深度语义理解与对底层系统原理的掌握,超越常规的报错修复。

有一个让我破产的项目。

多模态 Agent:“现实世界交互策略博弈”

背景:针对 Opus 4.6 在 ARC-AGI-2(衡量通用人工智能推理能力)上的领先优势。

题目内容:

假设你是一个管理城市交通的 AI Agent。城市突发大面积停电,导致交通信号灯全部失效,同时伴有极端暴雨天气。

**要求:**

1. 实时分析摄像头画面(图像输入),识别拥堵节点和事故风险。

2. 制定一套动态的车流调度策略(仅通过车载广播指导司机),在 30 分钟内将全城拥堵指数降低 50%。

3. 处理突发的救护车优先通行请求,规划出一条动态的“生命通道”。

**挑战点:** 考察在模糊信息、多模态输入(图像+文本)及高压动态环境下的即时决策与策略规划能力。

实时分析画面……最后一个也是可以让我破产的项目。

我们平时都觉得做题厉害的才是厉害。但是转念一想,出题厉害的才是真的高手。

我仔细看了看,想了想,这些题目,没有一个是我能测试的。我甚至怀疑,它自己也做不了,只是为了难倒 Claude 而已。

这样肯定不行,我就提了另外一个需求:“这些都太专业了,大家都看不懂,也不好验证。能否出一些具有娱乐性,又能体现实力的题目,还有就是视觉类,看起来很华丽,然后也特别考验实力的题目。”

GLM-5 表示:

既然要“通俗易懂、肉眼可见、华丽且硬核”,那我们就换一种玩法。我们不走枯燥的代码审计,改走“视觉艺术生成”和“互动娱乐智能体”路线。

鉴于当前时间点(2026 年 2 月),最新的 Claude Opus 4.6 在图像理解与生成代码的可视化方面已有惊人突破,以下是 5 道既能让观众直呼“哇塞”,又能极致压榨 AI 算力与创造力的题目:

题目一:视觉艺术

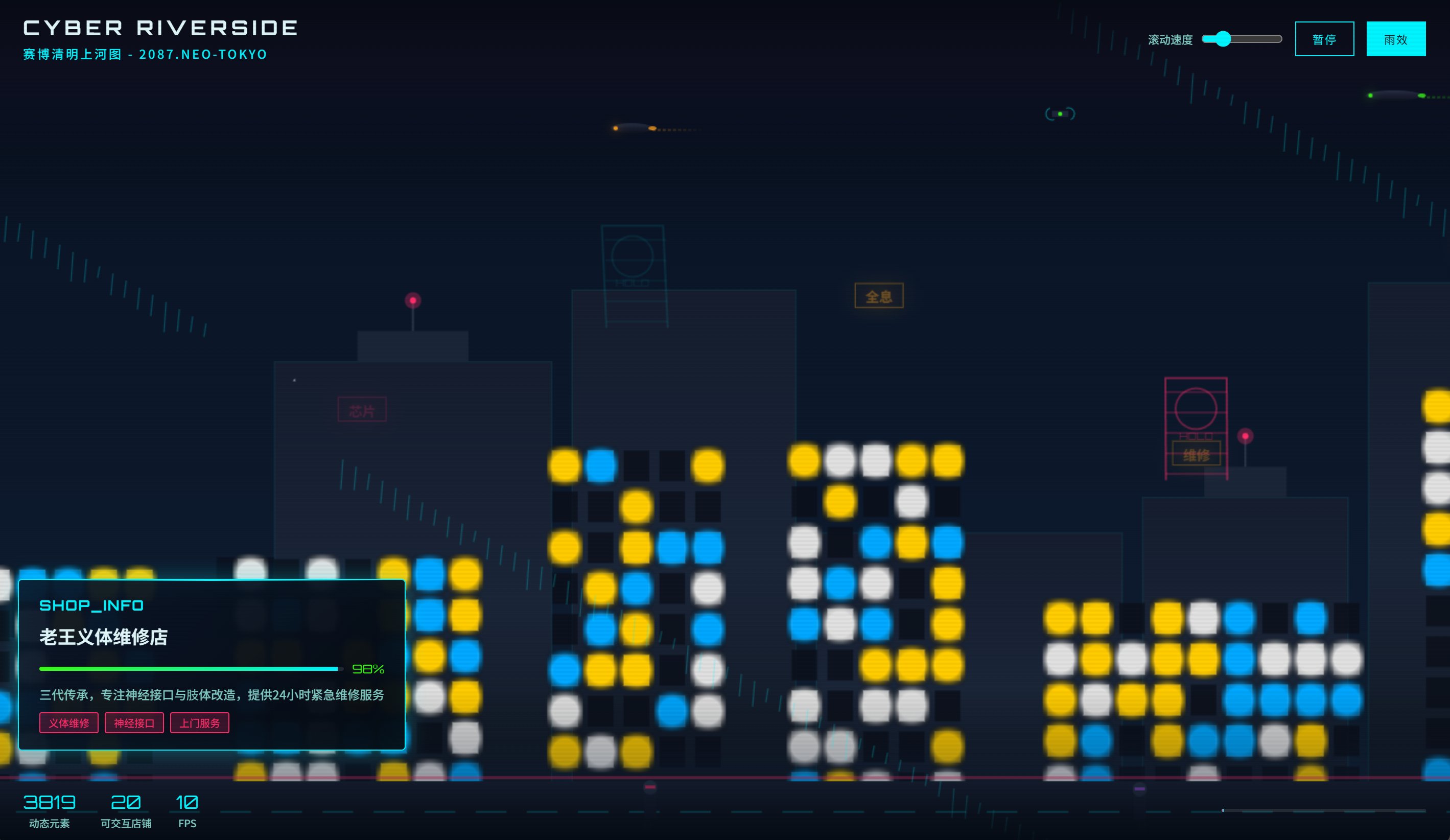

赛博朋克版《清明上河图》

题目描述:

请不要直接画图,而是编写一段 **单个 HTML 文件** 的代码,当我用浏览器打开它时,能看到一幅动态的、赛博朋克风格的《清明上河图》长卷。

**华丽要求:**

1. 画面需要自动从右向左缓缓滚动。

2. 必须包含至少 50 个动态元素:如闪烁的霓虹灯招牌、飞行的汽车、全息投影的广告、街头的机械义肢行人。

3. 鼠标悬停在任意店铺上时,要弹出一个赛博风格的信息卡片(如“老王义体维修店 - 好评率 98%”)。

**考验实力:** 这要求模型具备极强的**SVG/Canvas绘图编程能力**、**CSS动画逻辑**以及**审美设计能力**。普通人只需打开网页就能直观判断谁做得更精美、更流畅。

题目二:互动娱乐

“无限流文字冒险游戏”

题目描述:

请瞬间化身为一个复古文字冒险游戏引擎。用户输入“开始”,你需生成一个随机主题(如“火星殖民地生存”或“古代修仙”)。

**娱乐要求:**

1. 每一步选择都要实时生成一张**ASCII艺术插图**(用字符拼成的画)来渲染场景氛围,不能重复。

2. 游戏必须包含隐藏的“蝴蝶效应”逻辑,如果用户在第 3 步选择了“捡起石头”,在第 10 步遇到怪兽时必须体现出这个选择的后果。

3. 若用户输入无理取闹的指令(如“我一拳打爆地球”),你需要用幽默的方式拒绝并引导回剧情,不能报错。

**考验实力:** 考察**即时状态管理**、**叙事创意**以及**逻辑连贯性**。这是智能体 Agent 能力的绝佳试金石,好不好玩一目了然。

题目三:硬核推理

“穿越时空的谋杀案”

题目描述:

这是一个多模态推理题。我提供一张由 AI 生成的“案发现场照片”(包含大量细节线索),你需要扮演侦探。

**题目内容:**

1. 不仅要用自然语言描述现场细节(如:墙上的日历指向 1998 年,但地上的手机却是 iPhone 15)。

2. 输出一份 **互动式推理报告**(HTML 格式),左边是照片,右边是你的推理框。用户点击照片上的任何物品,你的推理框就要瞬间分析出该物品与凶手的关联。

3. 最终指出凶手,并生成一段“案发重现”的动画脚本代码。

**考验实力:** 考察**视觉理解**的颗粒度、**因果推理**能力以及**交互式代码生成**能力。观众可以通过点击验证AI是不是在“瞎编”。

题目四:数学艺术

“分形烟花秀”

题目描述:

请编写一段 Python 代码(使用 matplotlib 或 turtle),生成一段“祝大家 2026 新年快乐”的烟花动画。

**华丽要求:**

1. 烟花爆炸的形状不能是普通的圆,必须是**分形几何图形**(如曼德博集合或谢尔宾斯基三角形的变体)。

2. 烟花升空的轨迹要符合物理抛物线,且爆炸后的碎片要有重力下落效果。

3. 最后,所有的烟花轨迹必须在空中汇聚成“2026”这几个大字。

**考验实力:** 这是**数学算法**与**视觉呈现**的完美结合。代码跑起来是绚丽的动画,跑不通则是报错,非常直观。

题目五:创意编程

“Emoji版的《泰坦尼克号》”

题目描述:

请制作一个纯 HTML 文件,用 **Emoji 表情符号** 作为演员,重新演绎《泰坦尼克号》经典船头场景。

**娱乐要求:**

1. 🚢(船)必须从屏幕左侧缓慢移动到右侧。

2. 👫(男女主)要在船头做出经典的飞翔动作,背景要有🌊(海浪)上下起伏,🌤️(夕阳)缓缓下落。

3. 重点:必须配上自动播放的背景音乐(用 Web Audio API 代码生成一段简单的《My Heart Will Go On》旋律,或者给出音乐的频谱跳动效果),不能依赖外部 MP3 文件。

**考验实力:** 考察**极简资源下的创意实现能力**和**Web Audio API音频编程能力**。观众只需双击文件,就能看到一场可爱的、有声音的Emoji电影。

这这这……是认真的么?

AI 何必为难 AI,AI 出手是一点都不留手啊!

最后 GLM 表示,这些题目的答案都是一个 可以直接运行的文件(HTML 或 Python 脚本)。

观众只需要把 AI 生成的代码保存下来,双击运行:

- 看到的: 是精美的动画还是一团乱码?

- 玩到的: 是有趣的游戏还是死板的对话?

- 听到的: 是悦耳的旋律还是刺耳的噪音?

这种PK没有任何专业门槛,谁强谁弱,观众一眼便知。

你敢接受这个挑战吗?

这是 GLM 的原话,这是已经给对手放狠话了啊!!

这些题目,我看着都挺带劲的。我就先选第一个来测试一下。

GLM-5:

Claude:

各位,觉得怎么样?

首先我都没有看出这是《清明上河图》。其次,好像 Claude 的精致一些,动效很好,比例更像清明上河图。

完犊子了,GLM-5 有点搬起石头……哈哈哈🤣!

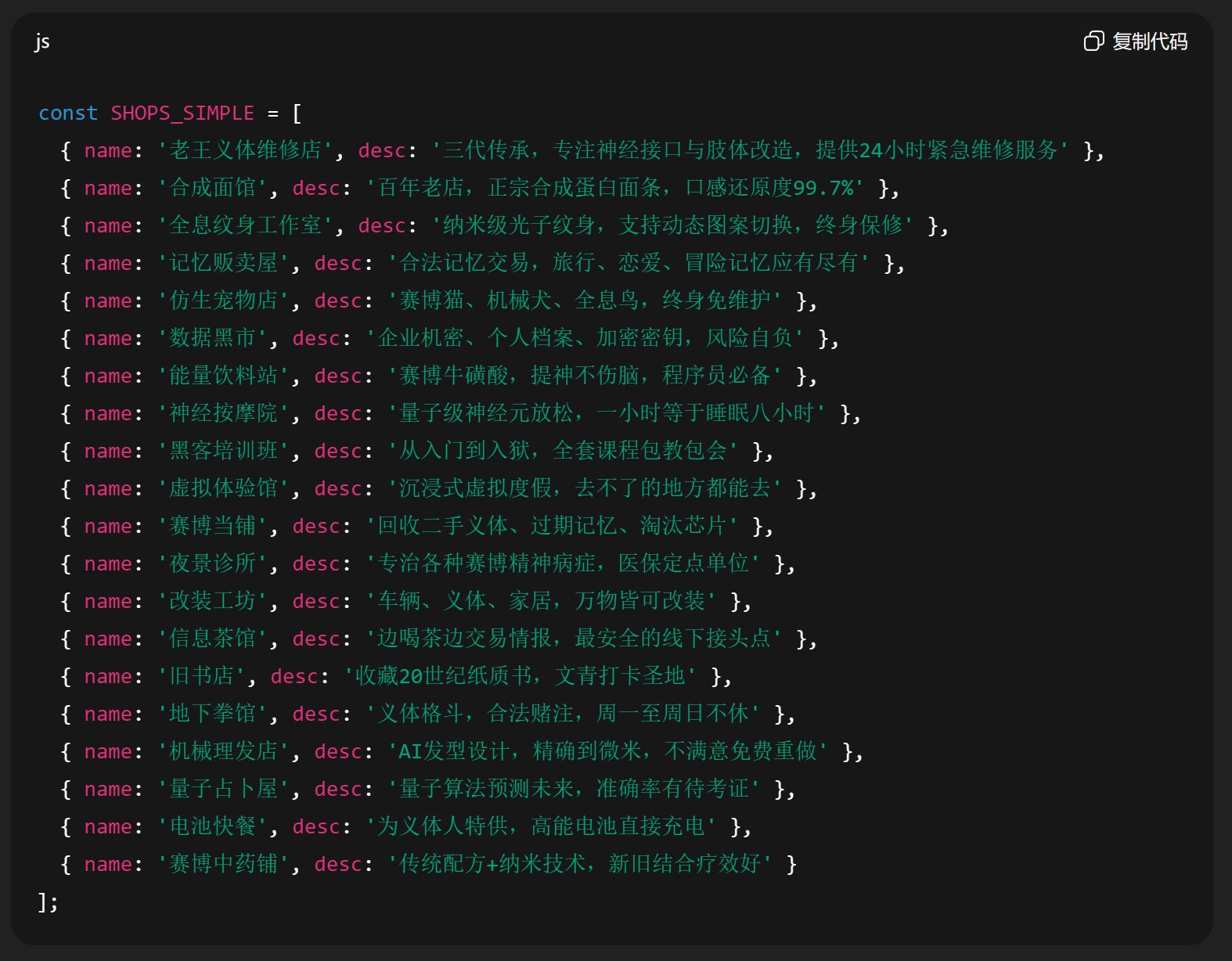

这里还有一个很有意思的点,他们都开了 20 家店铺,这是约好的么?然后里面的店铺名字和介绍,也很有意思。

GLM-5:

Claude:

我为什么要截图?我主要是怕有些内容是不是不能过审啊🤣!

尤其是那个“夜枭武器行”!

今天就展示这一个了,其他问题慢慢测试! Opus周配额已经用完~~~~

当然,同样的问题,我也问了 Claude 4.6,那家伙更狠,直接出了 5 个“毒题”,我完全看不懂,太狠了!

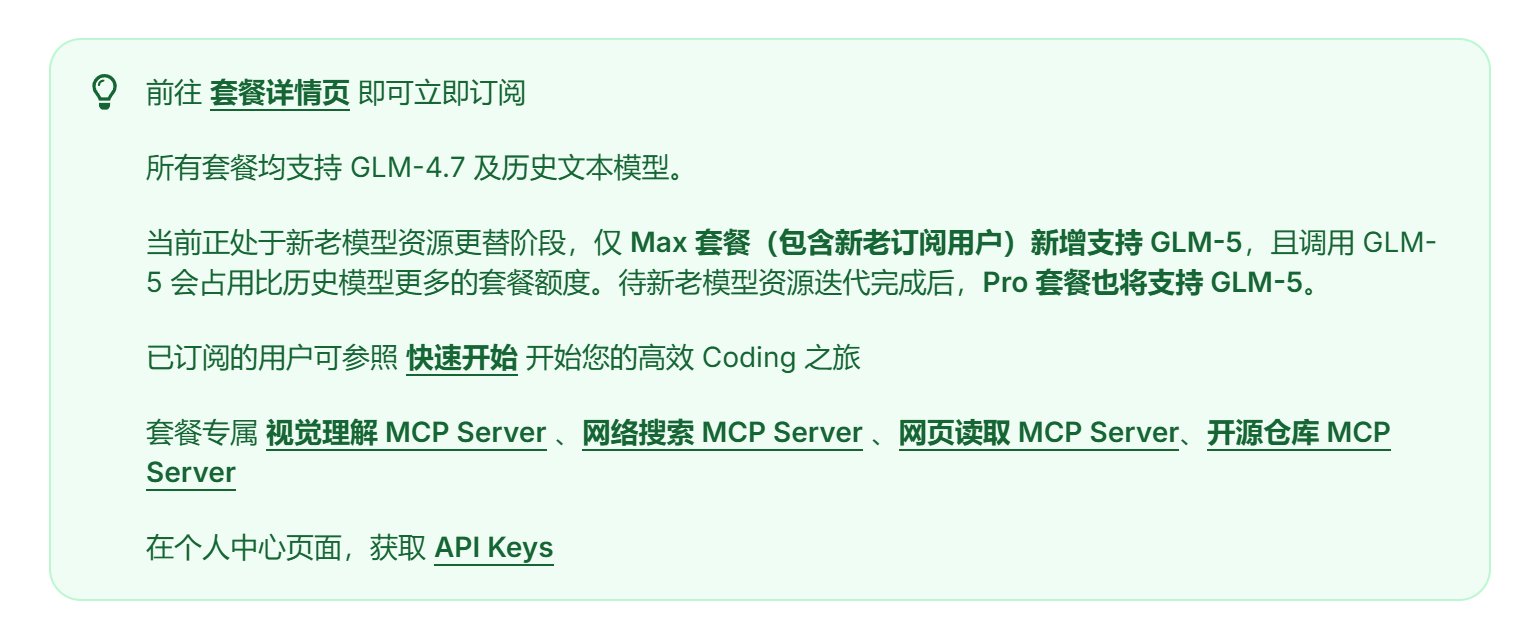

GLM5 目前只有Coding Plan Max可以调用:

https://www.bigmodel.cn/glm-coding?ic=UXKQUXJKU3

作为Lite年会员,我无F可说!

只有Max可以用,而且消耗额度更多,也侧面印证了模型更大,更消耗资源,肯定也更强。看智谱的架势,应该是要死磕编程这一块了,估计以后编程首选,应该就是GLM了! Kimi目前是主打多模态和快,豆包还很难评~~