打开 OpenClaw云端控制台,切换Kimi提速!

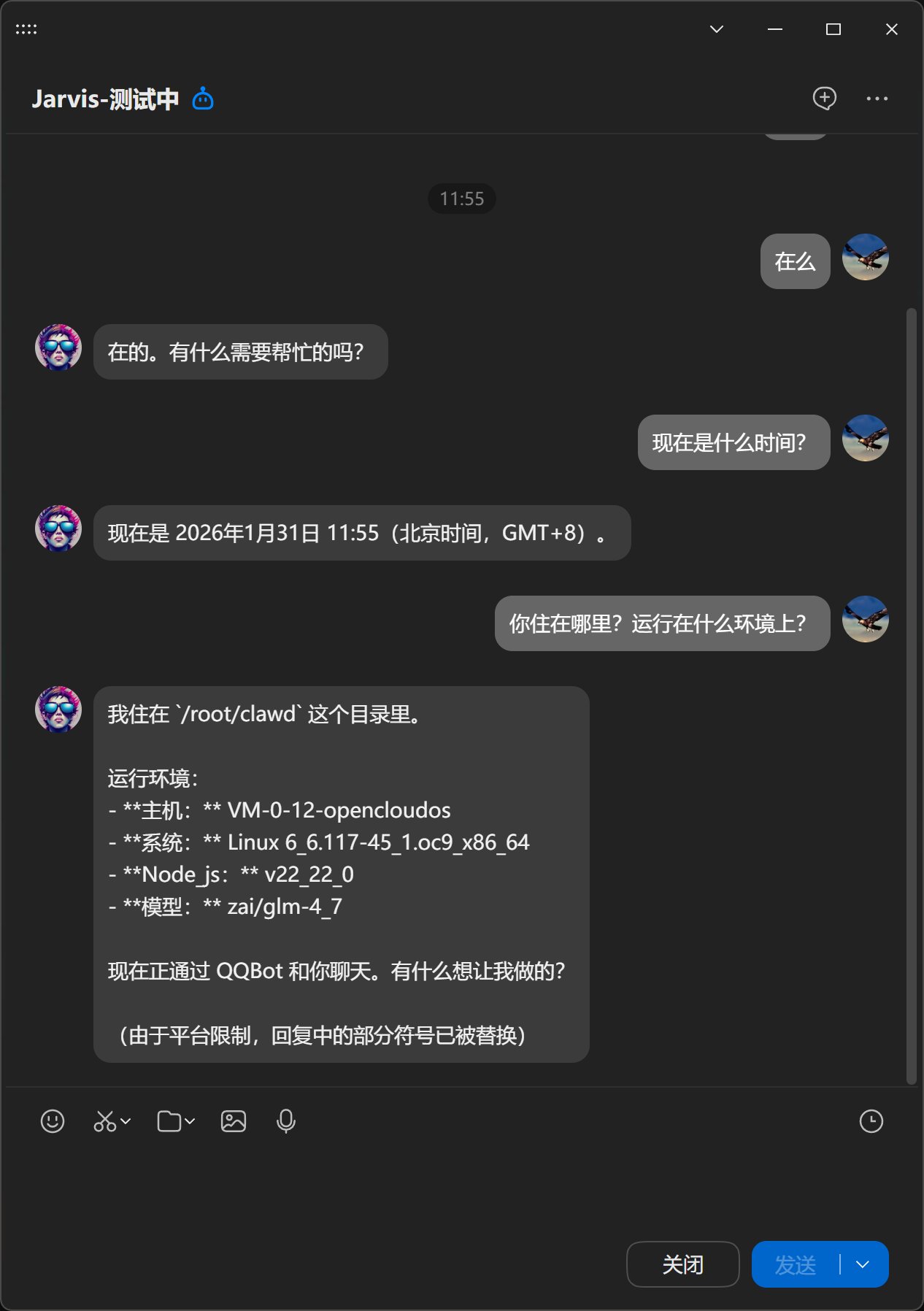

上次把 OpenClaw 部署在腾讯云,并且接入 QQ 的配置非常成功。

但是遇到了两个问题!

一个问题是:如何控制我的机器人

另一个问题是:怎么这么慢啊,动不动死了一样!

今天就来解决一下这两个问题!

还不知道如何配置的可以参考《OpenClaw 上云接入 QQ,“甲维斯”24 小时在线!》

这里主要是用到了腾讯云:

https://curl.qcloud.com/pa61o6Ze

用腾讯主要是因为它内置了 QQ、钉钉、飞书、企业微信等接入通道。而且可以云端 24 小时运行机器人,不影响本机的使用。如果要接入 QQ 这类腾讯生态,肯定是腾讯云最合适。

下面我们直接操作了,快跟上!

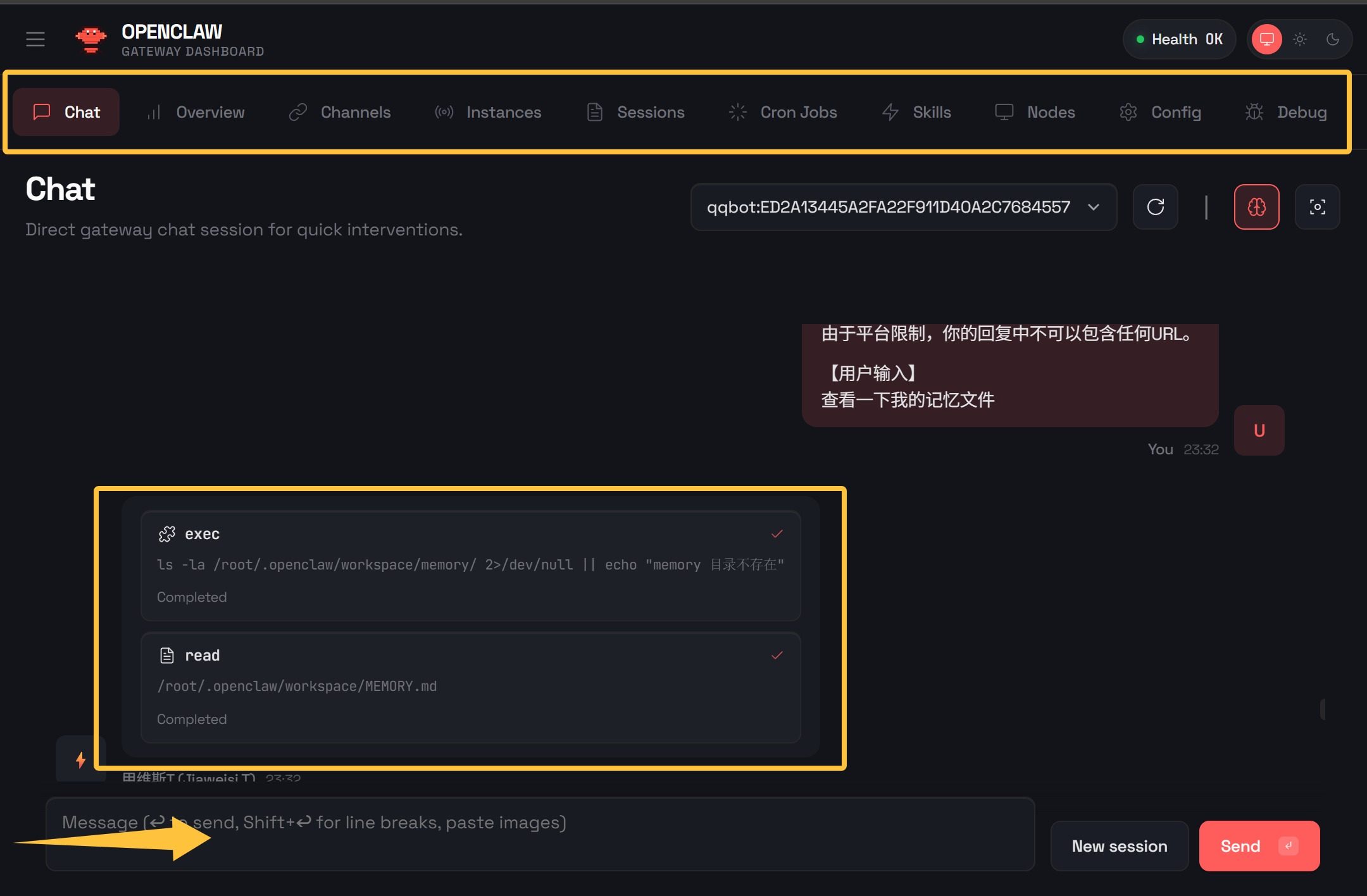

打开控制台

第一个问题,腾讯云后台只提供命令配置,对于大佬来说可能记住了命令还方便一点,但是对大部分人来说,大部分情况下,都非常不方便。如果你在本地配置过 OpenClaw,你就会发现它其实有一个控制台。里面包含了预览、频道、会话、定时任务、技能、配置、调试、日志等功能,非常全面。

本地配置完直接通过 http://localhost:18789/ 可以轻而易举地打开。

但是云服务器上却不行。

因为默认只绑定了 localhost,而服务只有通过公网 IP 才能访问。OpenClaw 根本不监听公网 IP,所以这是一个死局。但是官方也提供了一种推荐的解决方案,通过 SSH 实现。

为了解决这个问题,我们需要做一个简单的配置。

首先来到腾讯云控制台中找到我们开通的轻量应用服务器。

在上面可以看到 IPv4 的地址和登录的入口。

直接点击登录,登录到服务器上。

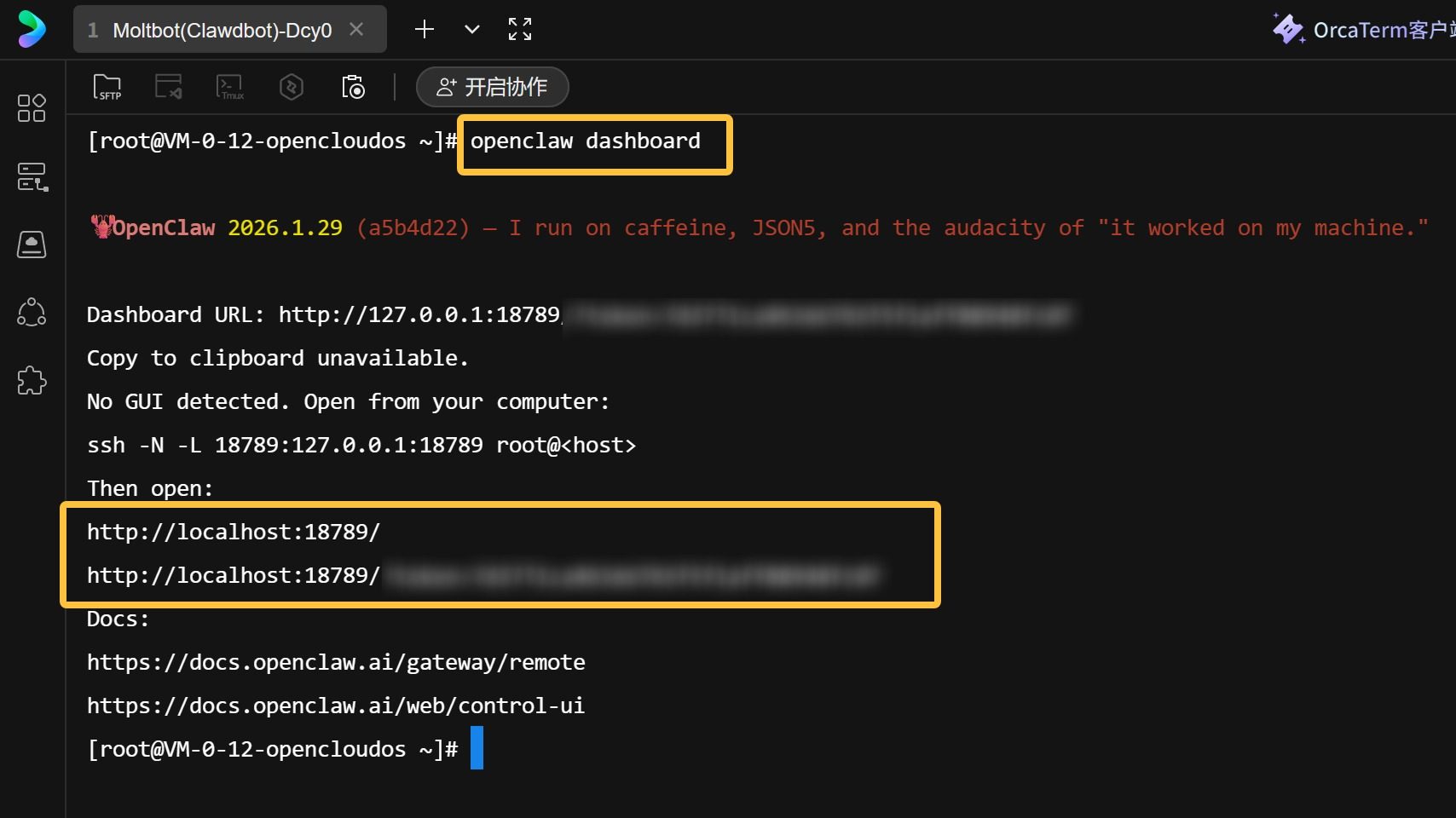

然后输入命令:

openclaw dashboard

输入这个命令之后,会输出后台控制面板相关的信息:

这些信息包含了它的访问地址,使用文档。

其中还有一个命令:

ssh -N -L 18789:127.0.0.1:18789 root@<host>

这是一个 SSH 命令,通过这个命令,可以让你通过本地地址访问服务器上的网页。

一旦这个命令生效之后,你就可以直接用上面的 localhost 地址打开控制台了。

道理清楚了,就可以执行了。

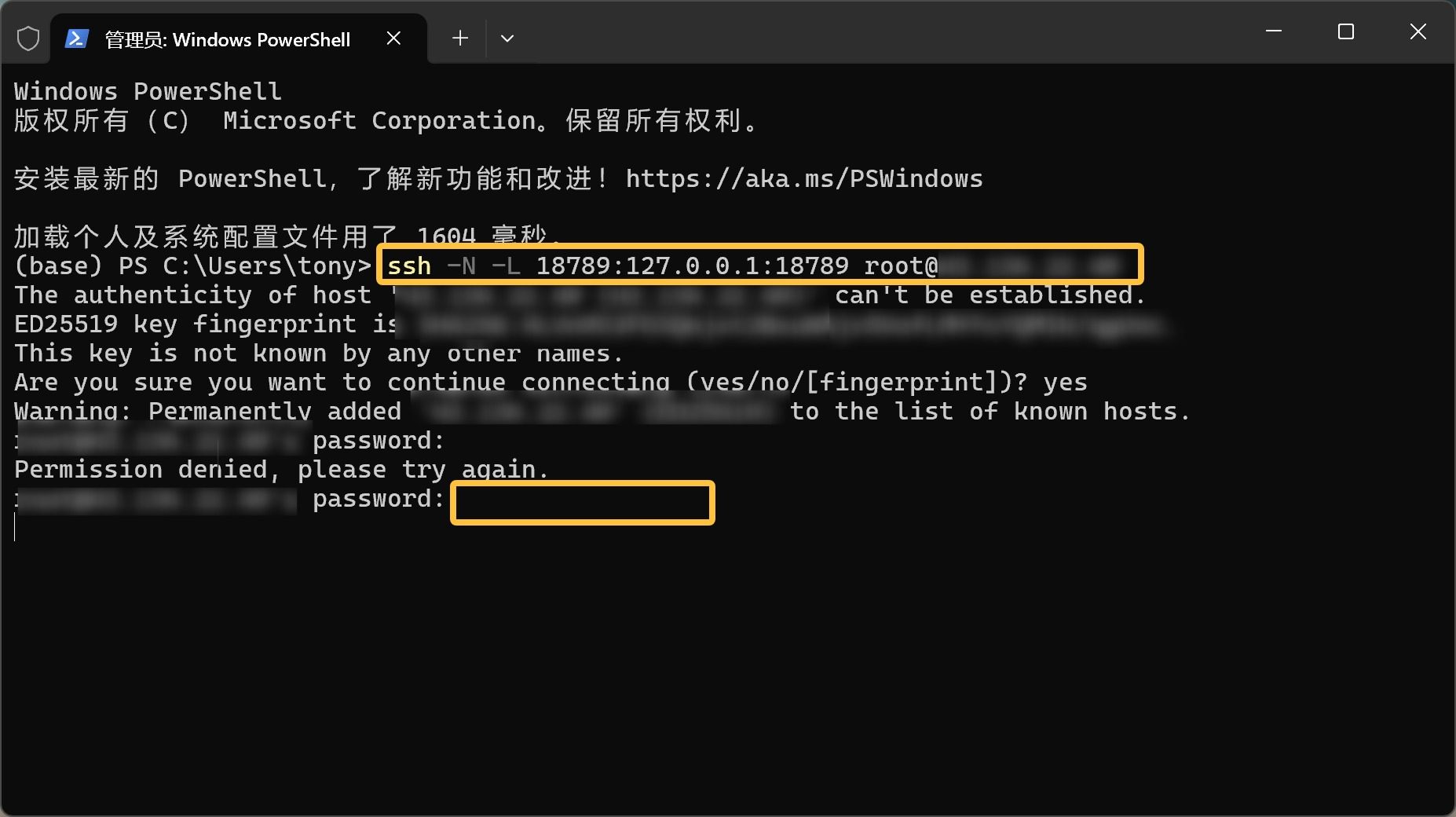

打开 Windows 自带的 PowerShell。

输入上面的命令:

注意 <host> 要换成你服务器的 IPv4 地址。输入完整命令之后回车,然后输入 yes 确认,然后输入服务器的密码。

搞定之后,就可以在本地电脑上打开网址浏览了。

只要这个黑色的窗口不关,SSH 通道不断,就一直可以使用。关了也没关系,重新打开,输入命令就可以了。

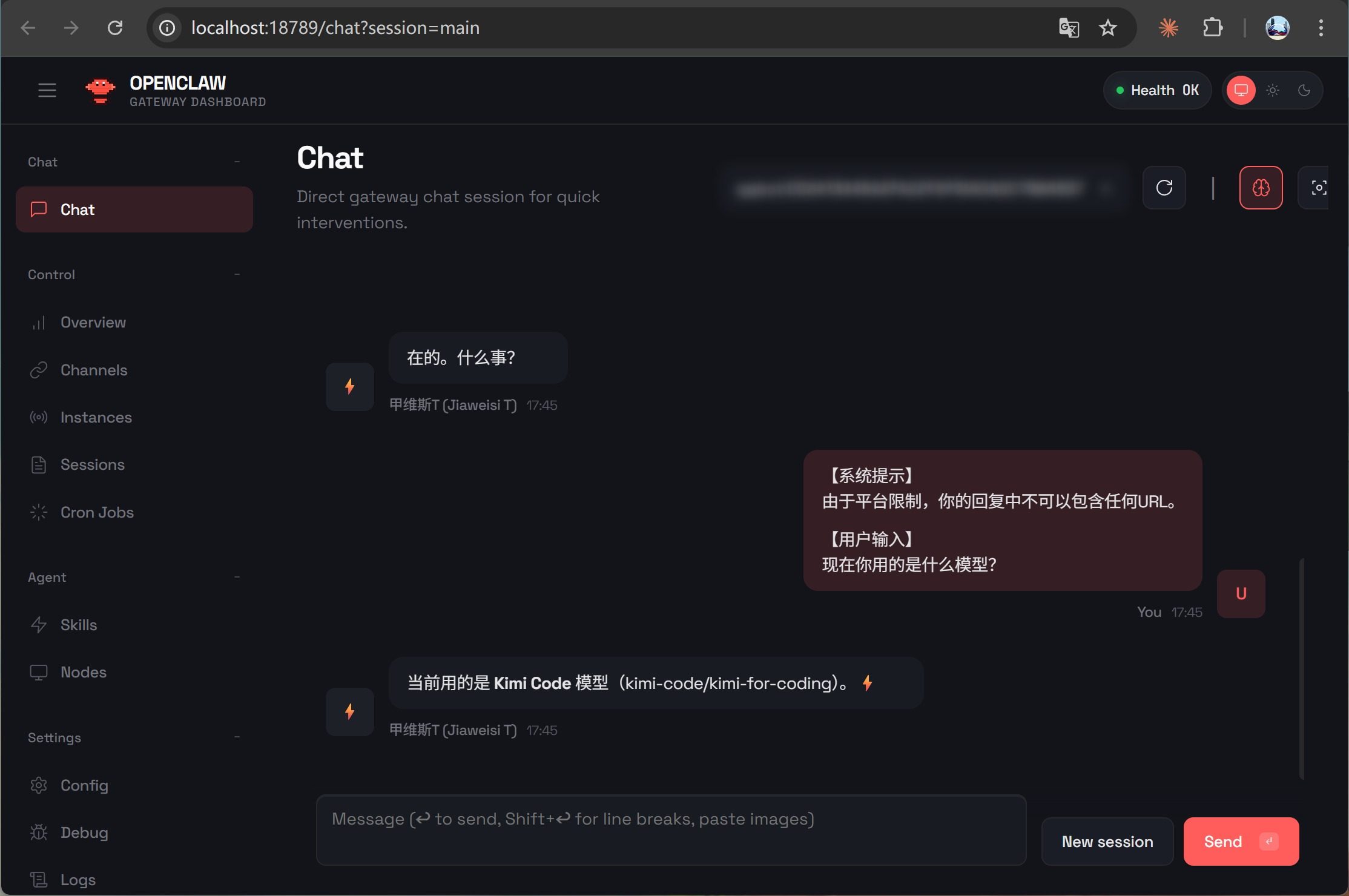

一旦配置成功,就可以和本地配置一样,直接访问控制台。

这个控制台的信息非常全面:

还可以直接进行聊天和下达指令。

更重要的是,可以查看工具的调用情况。这样就能全面地配置和观察你的机器人了。

换模型

第一个问题解决了,来解决第二个问题。

我们在之前的文章中使用的都是智谱的 GLM4.7,因为它工具调用能力和思考能力比较强。但是整体感觉就是比较慢,它更适合拿来编程。所以我们要换一个更快的模型。

这个更快的模型就是最近比较火的 Kimi K2.5,龙虾官方也在推荐,目前已经是龙虾上使用最多的模型了。

官网地址:https://www.kimi.com/code

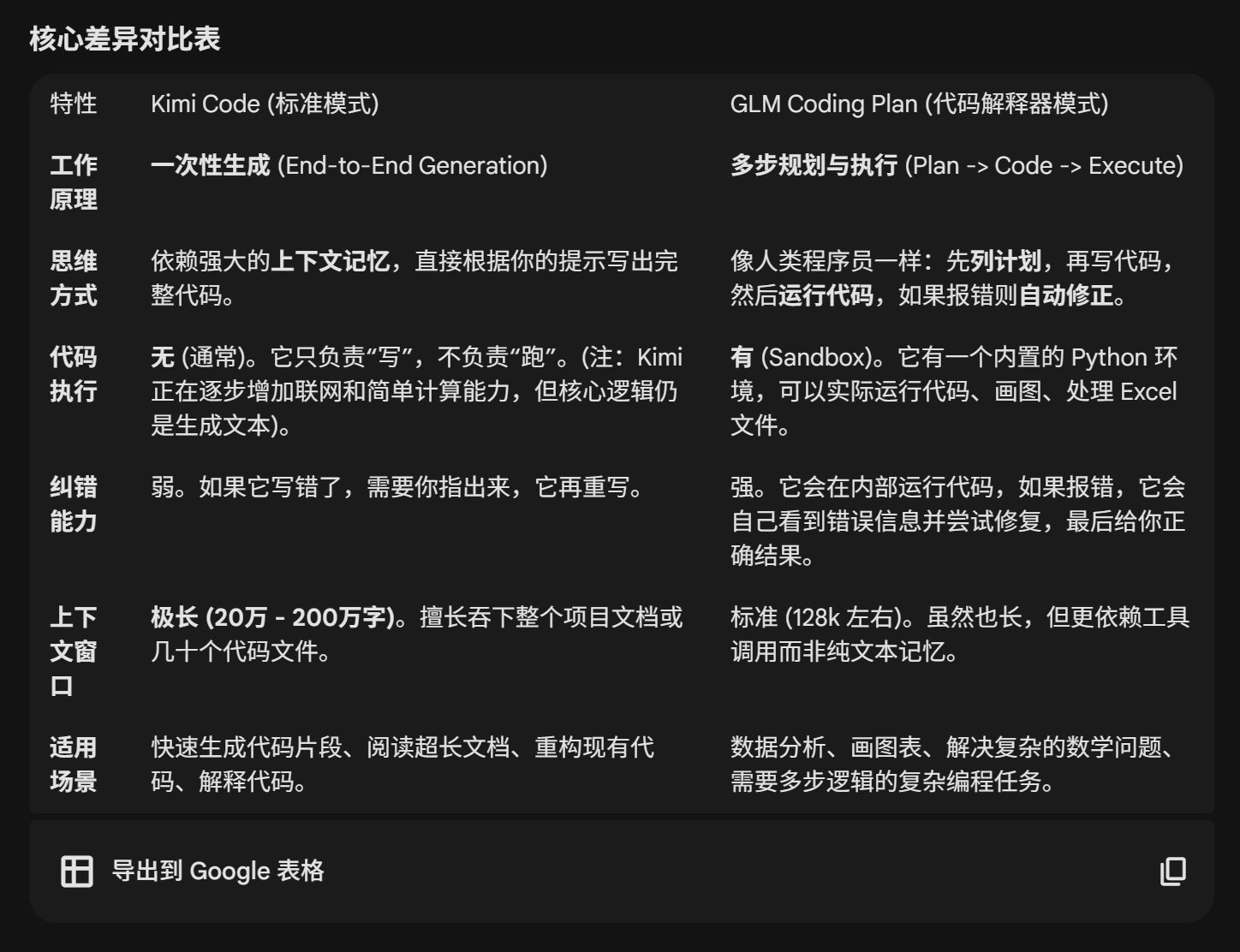

下面是 Kimi Code 和 GLM Coding Plan 的对比。

从这个表中可以看到,Kimi 的特点是比较快,上下文很长,记得多。

而且我看了他默认的思考等级是 low,推理模式为 off。这些配置在编程中可能是缺点,但是用在机器人上可以让处理速度加快很多,而能力并不会减弱,因为完全够用。

另外一点就是这个模型本身吐 tokens 的速度也比较快,所以配置完之后整体上会快很多的感觉。简单问题几秒都能回答。

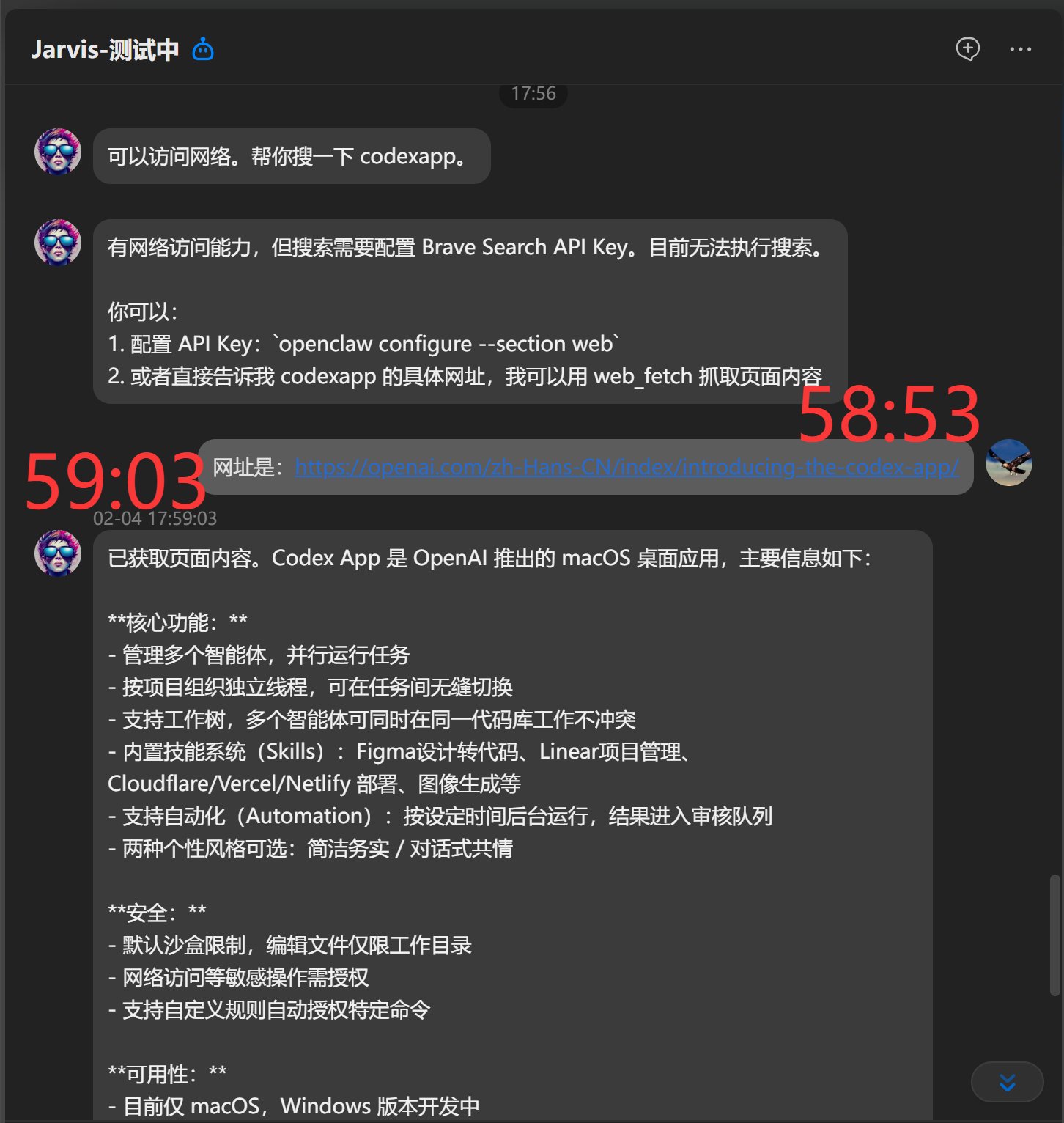

即便是带了网络访问和总结的任务,也只用了 10 秒钟。只要不是耗时的任务,都是正常答复。

另外一点就是它的工具调用能力也是不错。

这些特点很适合作为 OpenClaw 的驱动模型。

下面开始操作。

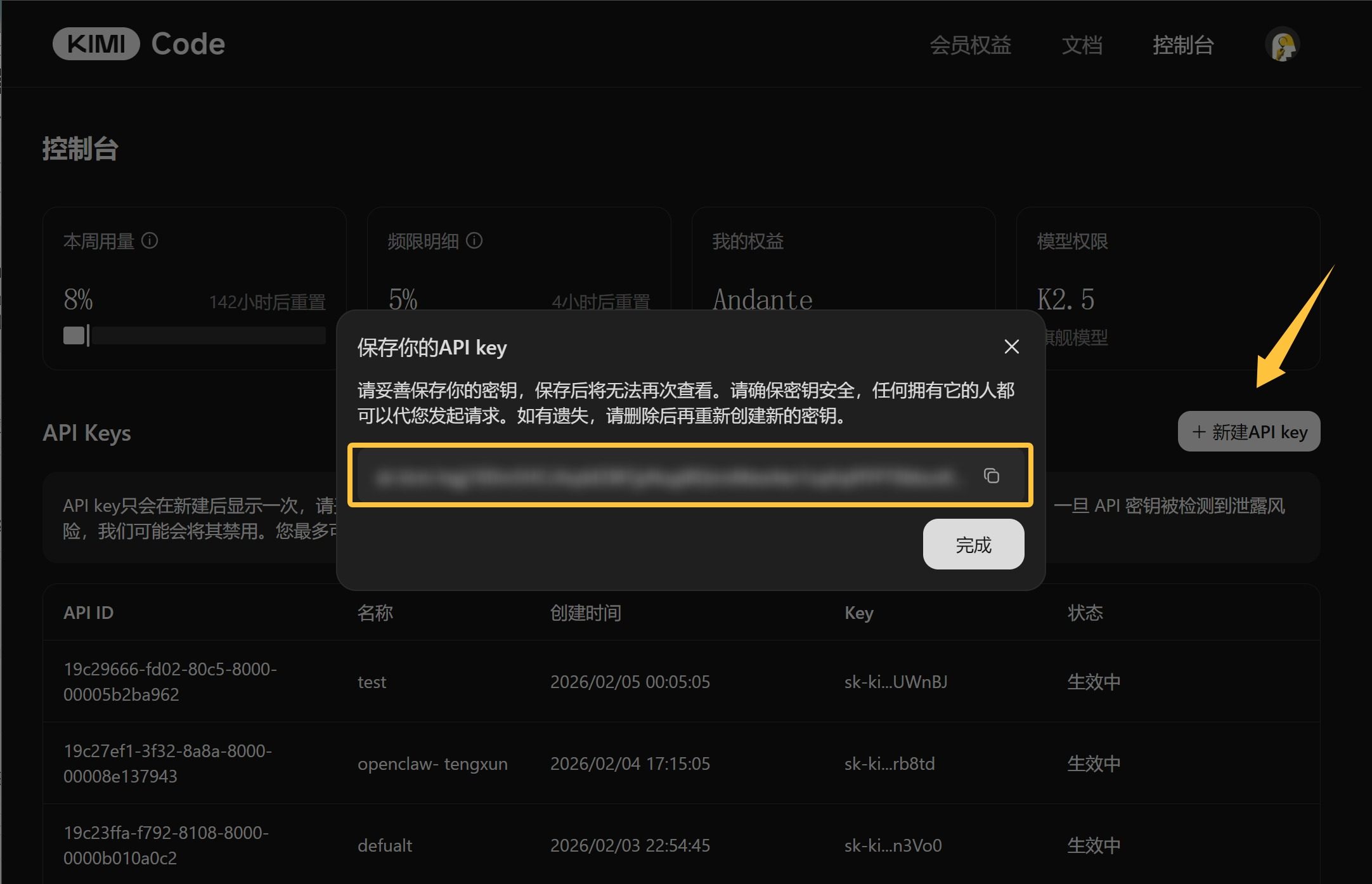

获取 Kimi 的 API:

登录 Kimi Code 后台,新建 API key。输入名字,然后复制黄色框中的内容。(这个不免费,但是几块钱就能上车。)

接下来就可以去修改服务器上的大龙虾的了。

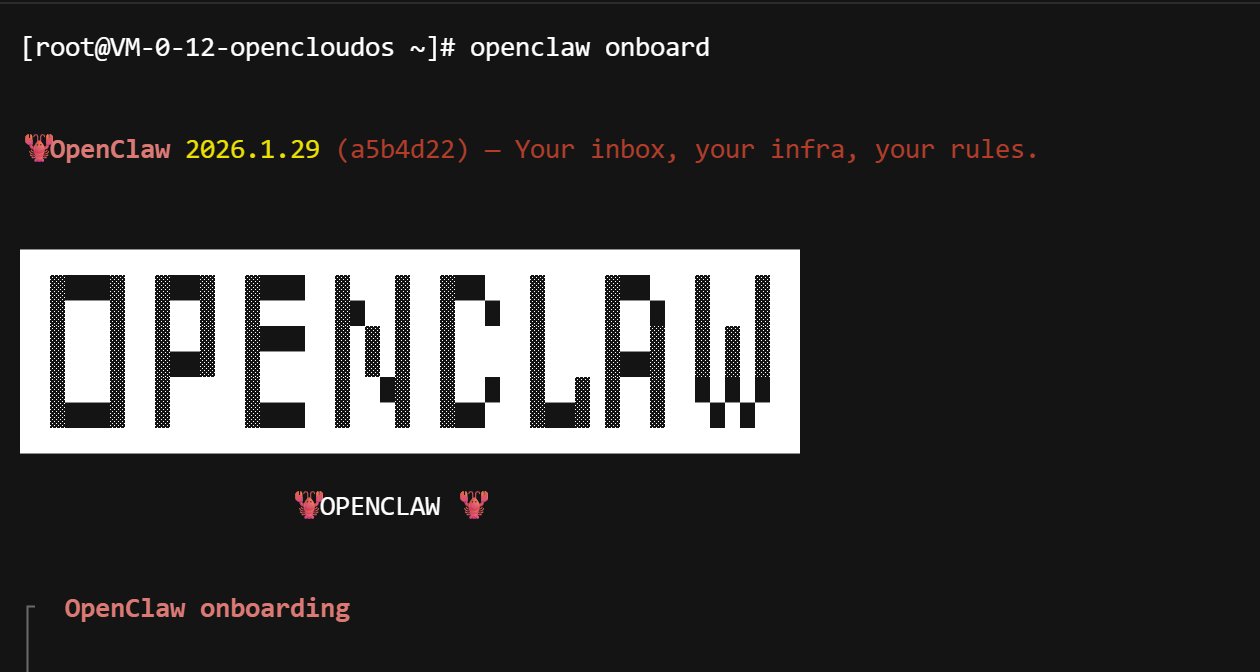

直接使用熟悉的命令 openclaw onboard:

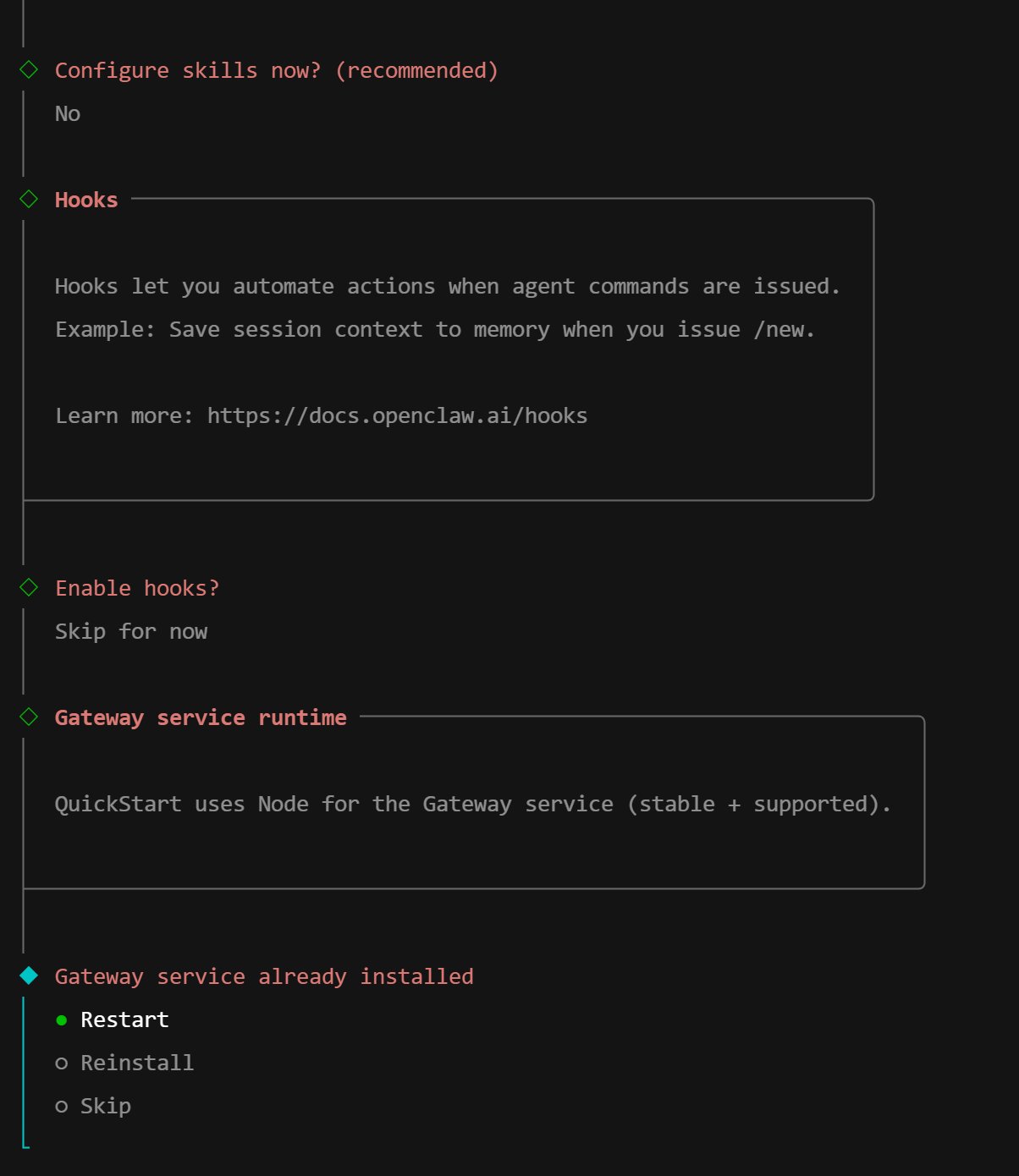

然后快速选择一下:

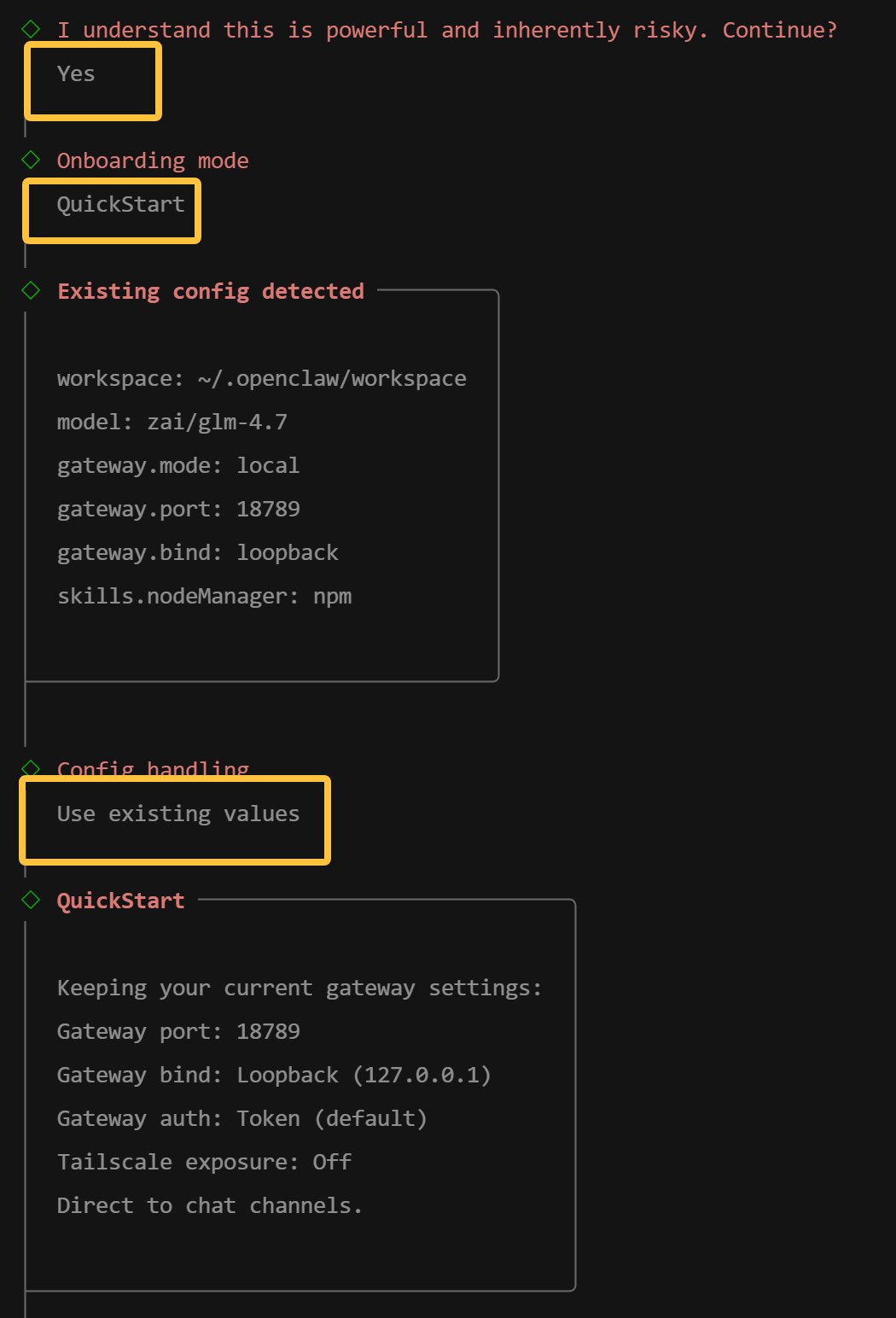

进入模型配置:

选择 Moonshot AI:

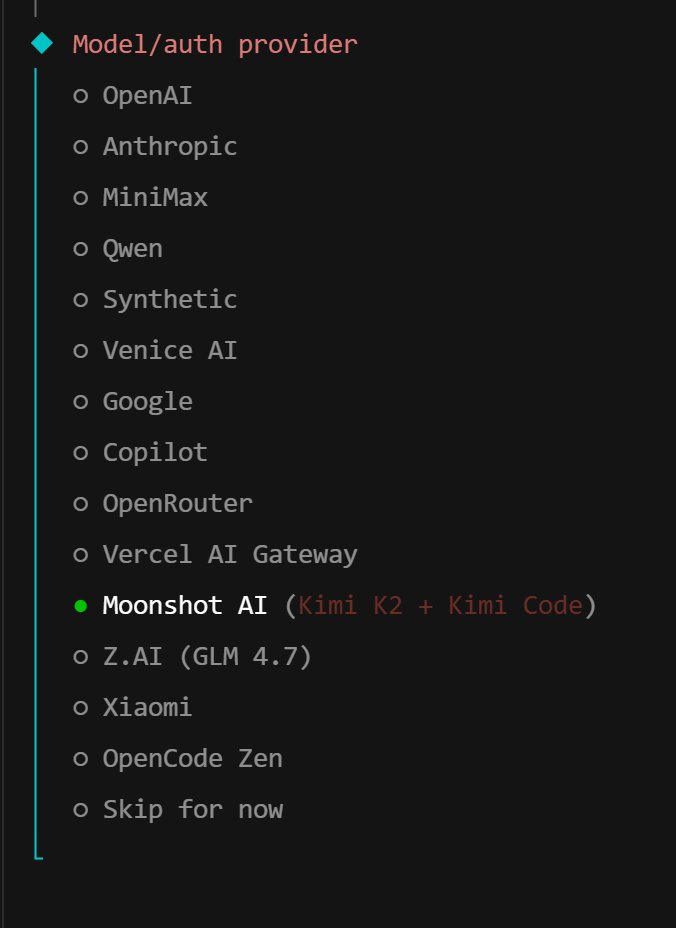

然后根据提示选择 Kimi Code API Key,然后输入具体 API key,最后选择默认的模型。

注意 Kimi 的 API 分了两种,一种是 Kimi Code,另外一种就是普通 Kimi K2。Kimi Code 是按月收费的,长期使用,这个比较合适。如果只是偶尔体验一下,可以开普通按量付费的接口。

接下来会让你配置聊天工具,我们直接选之前配置好的 QQbot。然后 skip 就好了。

最后选择 Restart 一下,重启一下网关。

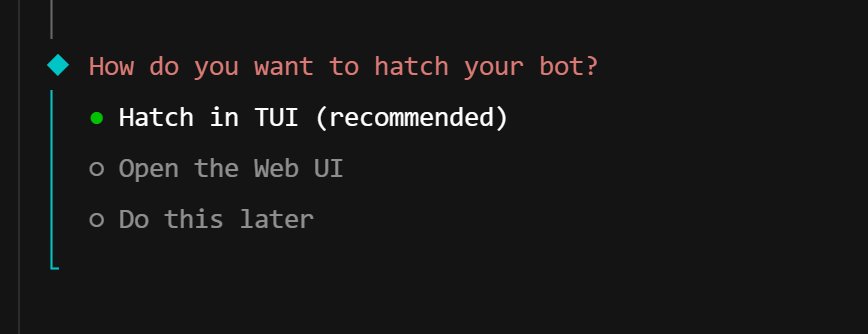

选择 Hatch in TUI:

然后就可以开始终端对话了,也可以直接给你的QQ机器人发送消息测试一下效果,应该会有很明显的提速。

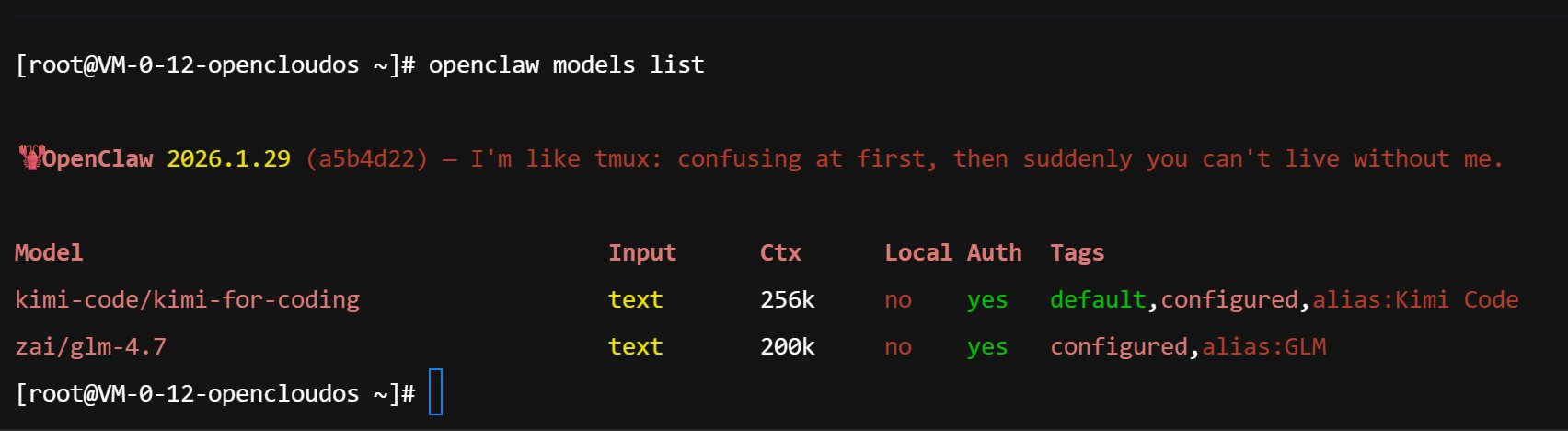

如果需要 100% 确认已经使用上新模型了,可以用命令查看一下。

命令:

openclaw models list

执行结果:

从结果中可以看到,Kimi 的模型为 default!就是说 Kimi 已经是默认模型了。

我们现在可以使用控制面板来管理机器人,查看工具和技能的调用情况,也可以直接下指令。然后匹配了一个更加合适的模型,增强上下文记忆和提升反馈速度。这样大龙虾的使用体验就会好很多了。

最近 OpenClaw 推出了新的更新,支持优化记忆,减少上下文的功能,以及官方集成了飞书!我准备去试试看,然后和大家分享。如果对这方面有兴趣,记得点关注哦!