“通义千问”和”百川2″一键运行包!

坚持更新很难,躺平很简单,哈哈!

本来打算假期前更新,有一些事情打乱了节奏。放完假,半天想不起自己修改到哪里了…

三合一的包(千问,百川,书生)已经做好了,但是还需要完善一下。我先把千问和百川2的两个单独的包发一下。

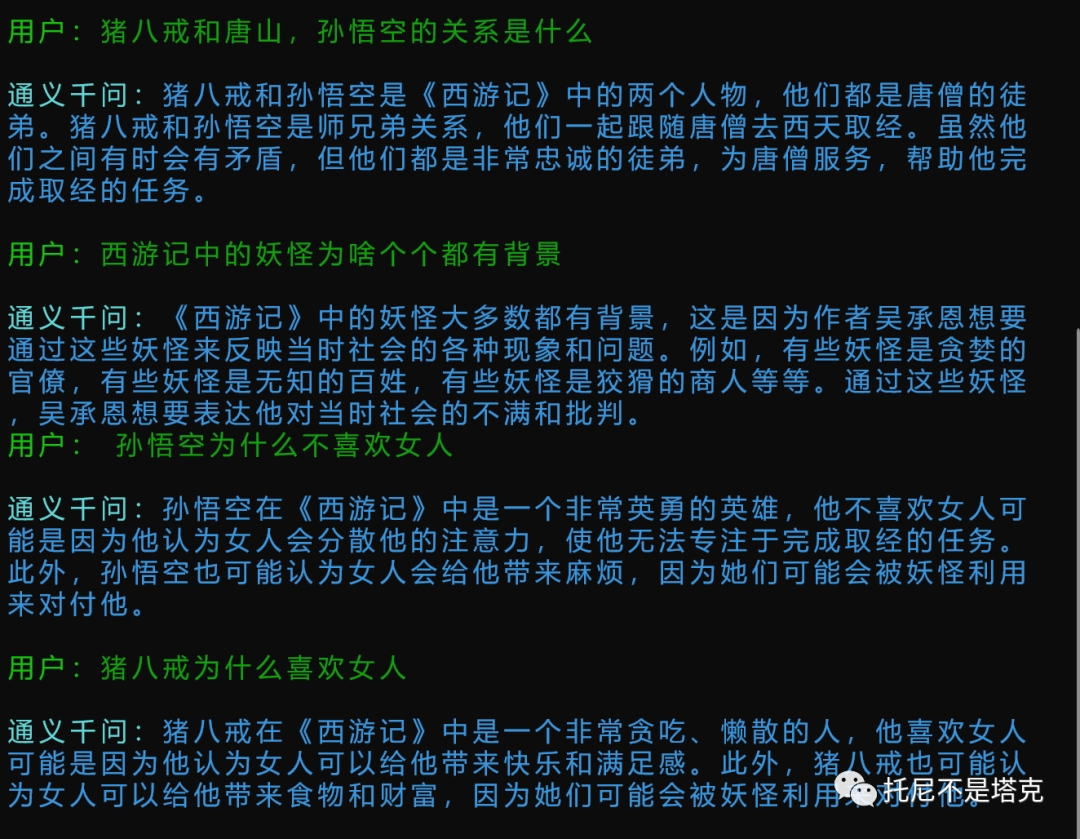

关于这两个大语言模型的介绍参考之前的两篇文章《玩一玩“baichuan2”》和《阿里千问玩起来》。

简单概括,这两个模型应该是目前最强的开源中文大语言模型。

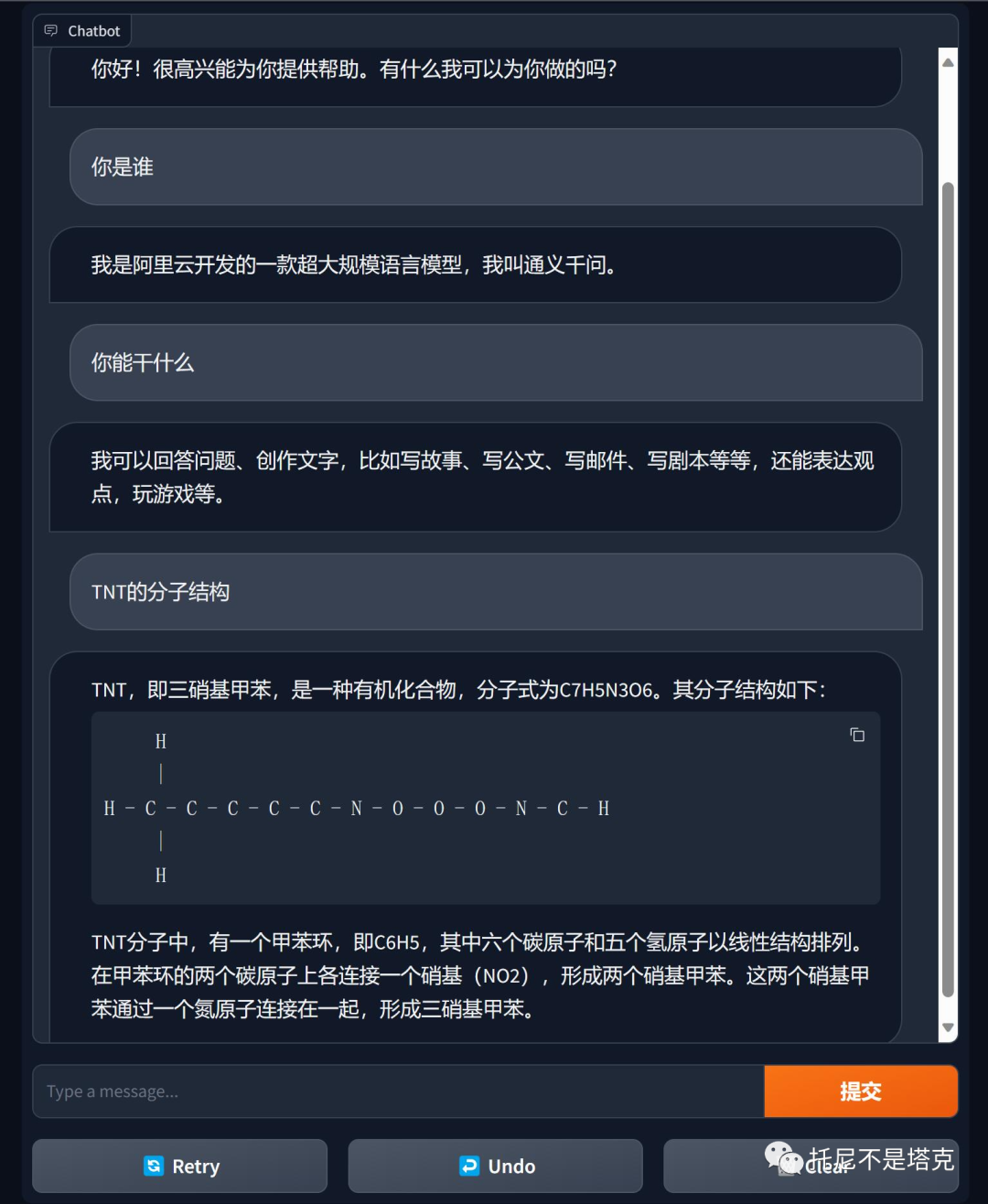

大语言模型就是类似ChatGPT的AI模型,可以进行AI聊天,回答各类问题,可以关联上下文,做一定的推理。

这两个模型都有如下特征:

- 免费

- 可商用

- 可以在常用显卡上流畅运行。

- 对话能力达到了一定的水平。

下面就简单介绍一下这两个一键运行包的使用方法。

1.硬件准备

需要一张显存8G+的英伟达显卡。比如1070+,2060s+,3060+, 4060+等等

2. 软件环境

操作系统Win11/Win10

其他基本不需要自己准备。

3. 使用方法

首先,获取软件包并解压。最好是解压在某个盘的根路径下面。如果是子路径,注意不要用中文和空格。

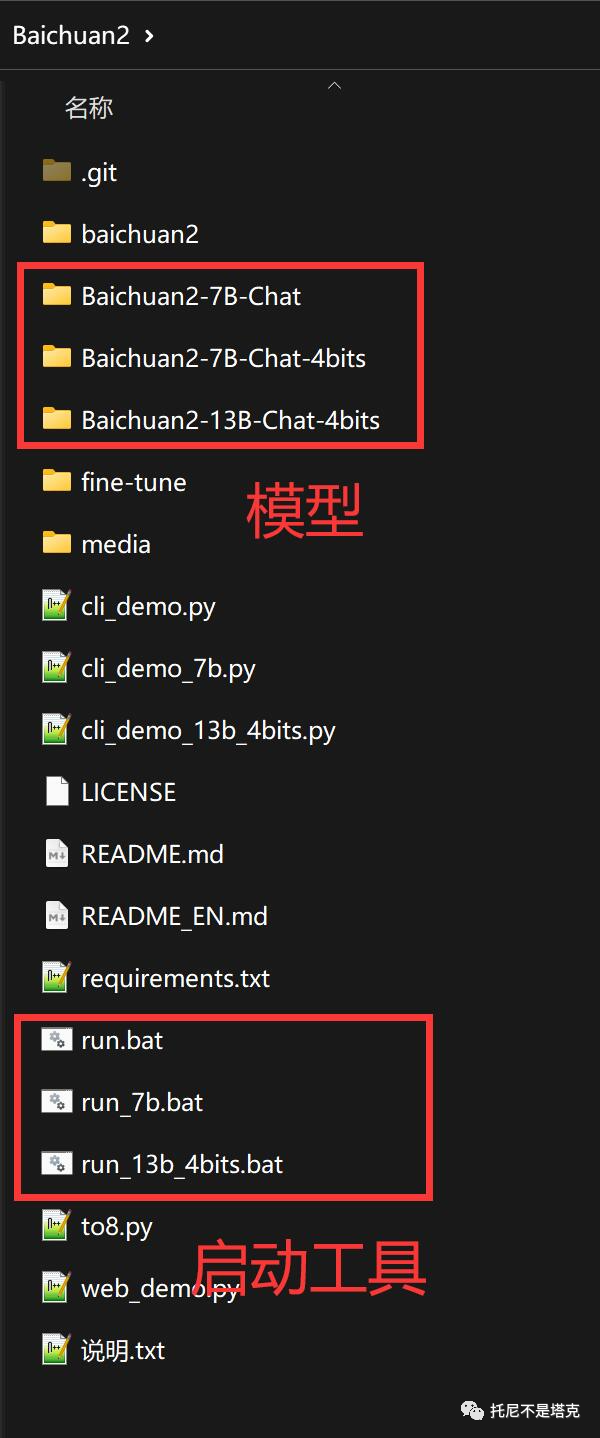

百川2的用法

正常情况下只要双击run.bat即可启动,等待,提问即可。考虑到一键包的尺寸问题,默认只配置了baichuan2-7b-chat-4bits这个模型。

另外还准备了7b和13b_4bits启动脚本,要使用这两个脚本,需要先下载对应的模型,同时需要消耗的显存也更高。

模型发在网盘链接中的”模型-models” 文件夹里。

也可以通过项目官方下载,但是随着时间的推移,软件和模型可能都会变化。所以直接使用网盘中固定的版本会比较好,不容易出问题。

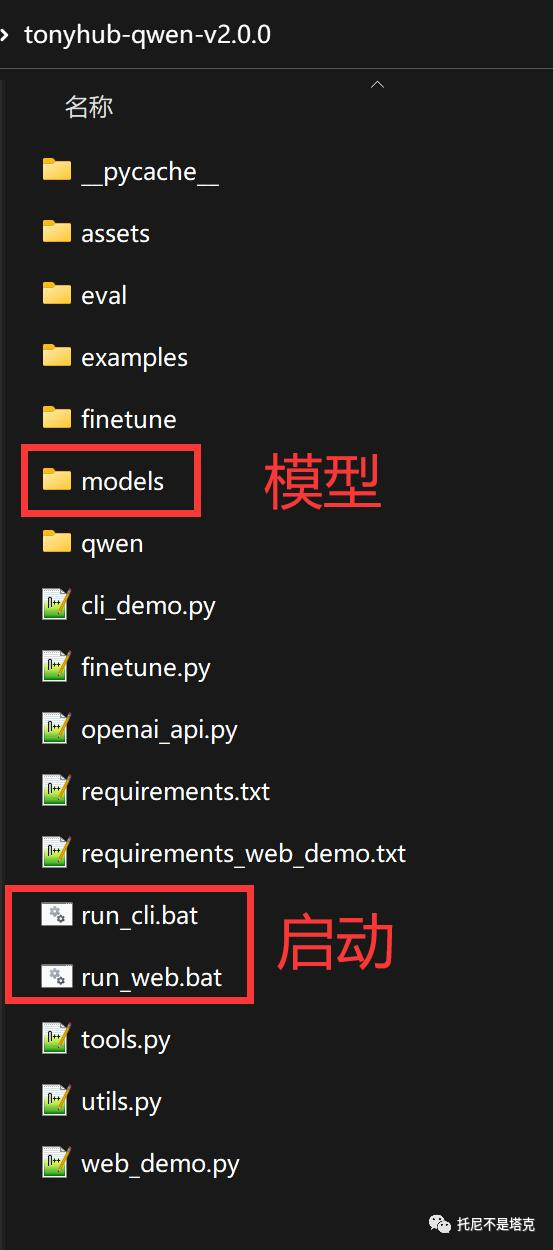

通义千问的用法

通义千问开源版包含了两个启动脚本,一个是命令行,一个是网页。都已经测试过,并且默认配置了硬件需求最低的模型Qwen-7B-Chat-Int4。

如果想要尝试其他模型,比如Qwen-14B-Chat-Int4,可以通过网盘获取模型文件。

然后将整个文件夹放到models下面。

用文本编辑器打开web_demo.py或者cli_demo.py。

修改DEFAULT_CKPT_PATH 这个变量

DEFAULT_CKPT_PATH = 'models/Qwen-14B-Chat-Int4'修改保存之后,双击启动脚本运行就可以了。

根据我的测试,140亿参数模型,12G的3060显卡也能跑起来。

两个软件包里的代码全部为源代码,有能力的可以改。

这几天计划把多个大语言模型打包在一起。

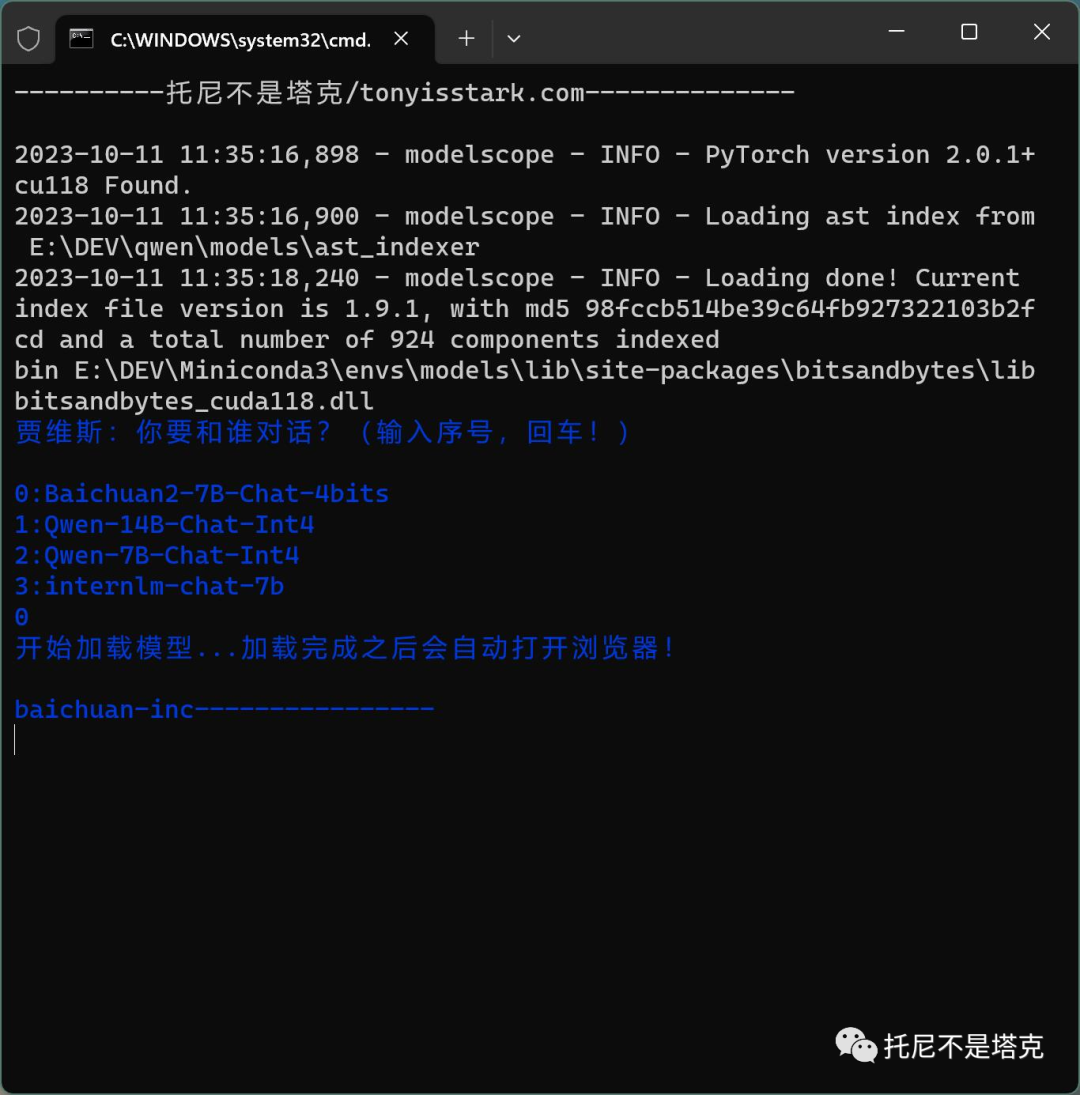

目前已经把千问系列,百川系列,书生系列合并在一起。

我准备把这个包叫做:Jarvis (哈哈~)

做了一个网页版和命令行的版本。

我看看,还能不能加入更多牛逼的模型,比如最强的数学模型,代码模型等…我觉得差不多了,就发出来。

另外也有朋友问这个能不能连知识库,微调,接入微信等。答案都是肯定的。但是限于设备,软件,能力,时间等问题,可能不会那么快更新这类文章。

最后,软件包的获取方式:

关注公众“托尼不是塔克” ,然后发送“baichuan” 和“qwen” 就可以直接获取相应的软件。

收工了。

请大家多点赞,多转发,多到我不好意思拖更为止!

点赞不花钱哦,当然也欢迎花钱支持,加入知识星球。