自从上次分享了macOS下安装Zimage的教程之后,我成功杀入mac体系了啊!

每次发文章,都有人问,mac OS可以跑么? 必须可以啊!

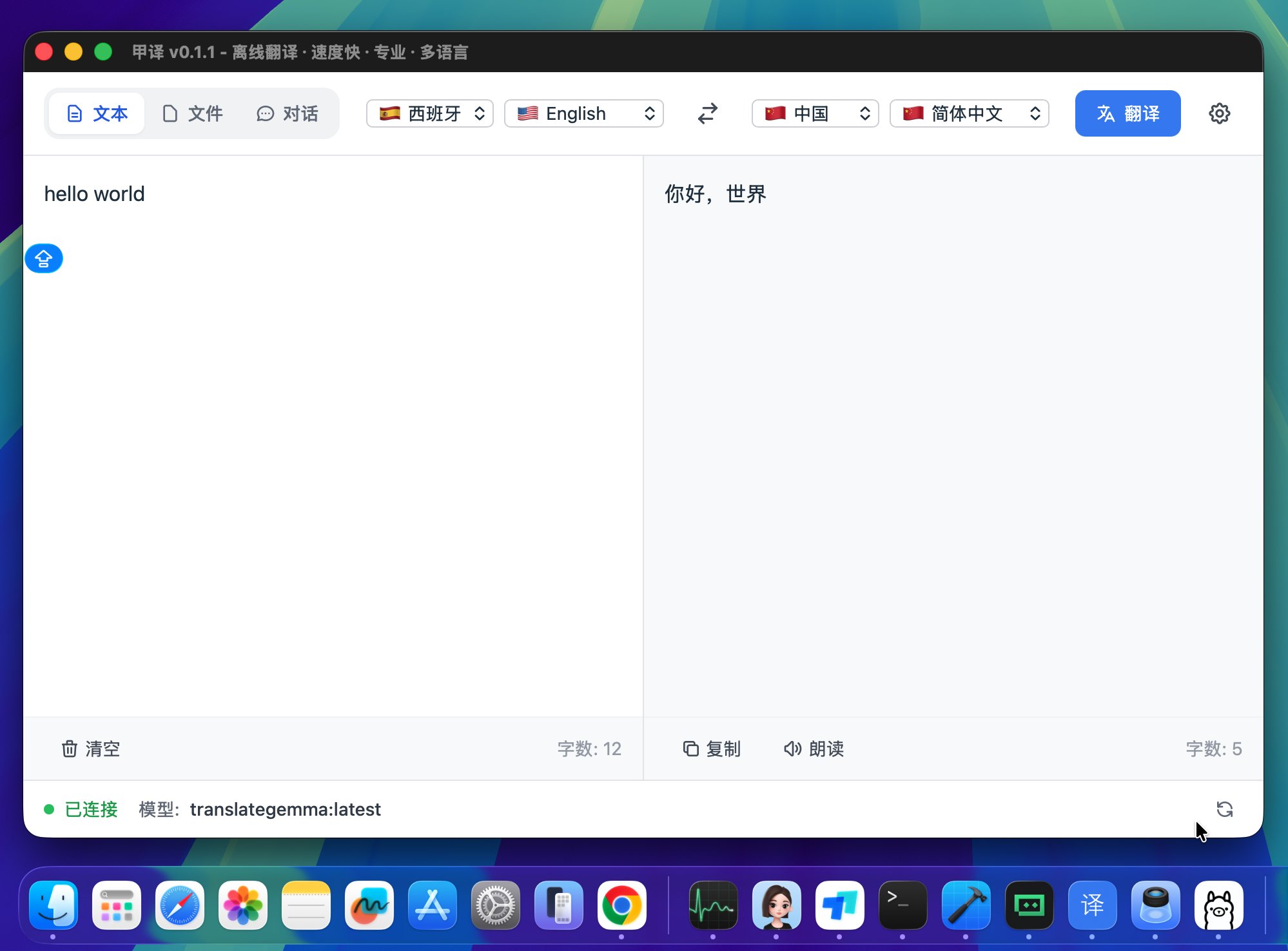

昨天发布了一个基于谷歌开源模型translategemma开发的本地离线翻译软件“甲·译” ,这是基于Windows开发的,苹果的朋友看了也想要。

问我有没有… 没有哦,但是我可以快速写一个。

其实开发之初,就考了到了跨平台的问题。

所以今天就来介绍一下,macOS用户如何搭建一个完全离线的本地翻译软件。

我已经在mac mini m4上测试过了,速度也非常快,相当丝滑。丐板mini应该也很轻松,好多年前的macbook m1 air也轻松。

下面我就分步骤来讲解一下完整的安装配置过程。

因为现在软件都已经比较成熟了,所以配置起来并不难。下面我就一步一步来。

安装和更新Ollama

为了实现我们的最终目标,首先需要安装的是一只小羊驼,名字叫Ollama。

Ollama 是一个在本地统一管理、下载并运行各类大语言模型的轻量化运行环境和服务层。

简单来说,就是它负责管理开源模型,我们通过ollama来下载,管理需要用的翻译模型。

直接打开ollama官网点击下载。

然后正常安装就可以了。

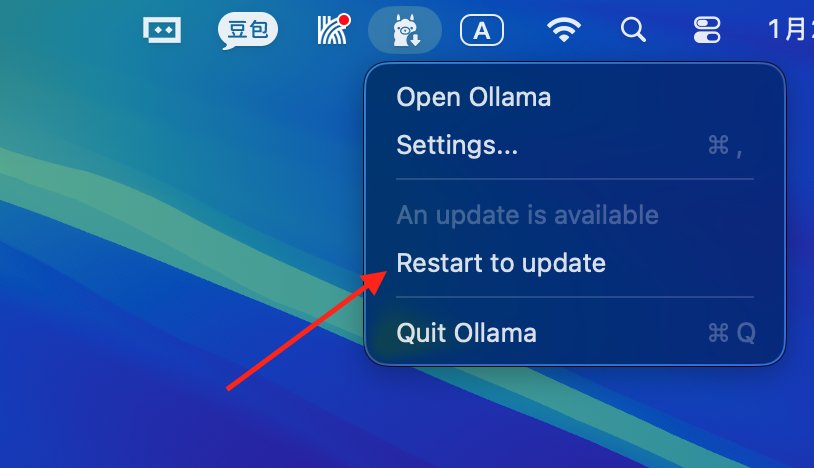

如果本地已经装过了,记得更新一下。

确保已经到了0.15及以上版本。

想要知道版本号,可以打开终端,输入:ollama -v 然后回车。

下载翻译模型

有了Ollama之后,就可以通过它来下载模型了。 我们今天用到的模型叫做translategemma。这个模型分了三个版本,分别是4b,12b,27b。数字越大越强。

4b其实已经很不错了,所以我们用最小的4b来演示。

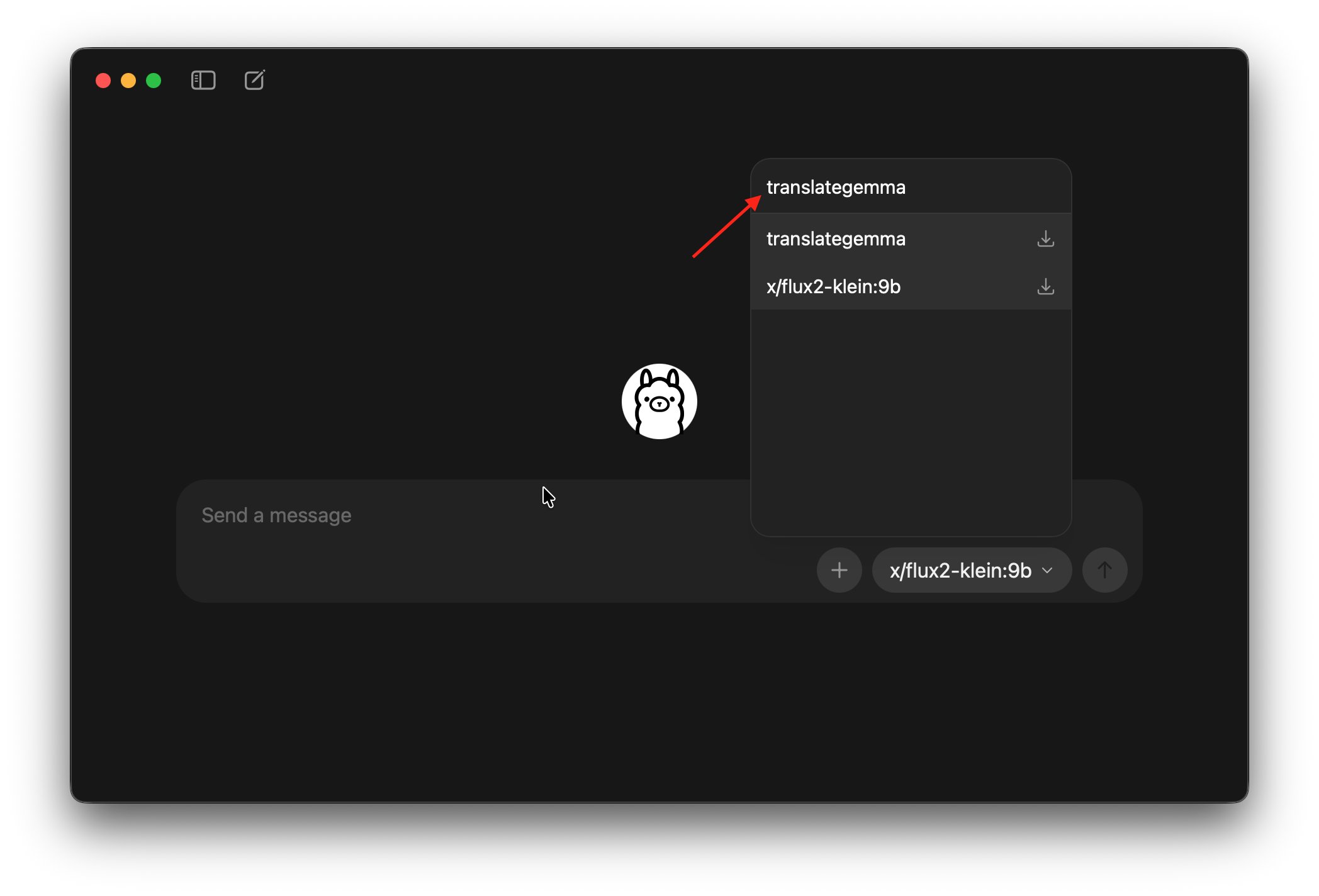

下载方式有两种。一种是通过界面下载:

打开Ollama的主界面,点击右下角的模型选择,输入模型名称,然后就会有个下载图标了。点一下选中,然后发送任意内容,比如666。

软件就会开始自动下载模型了。

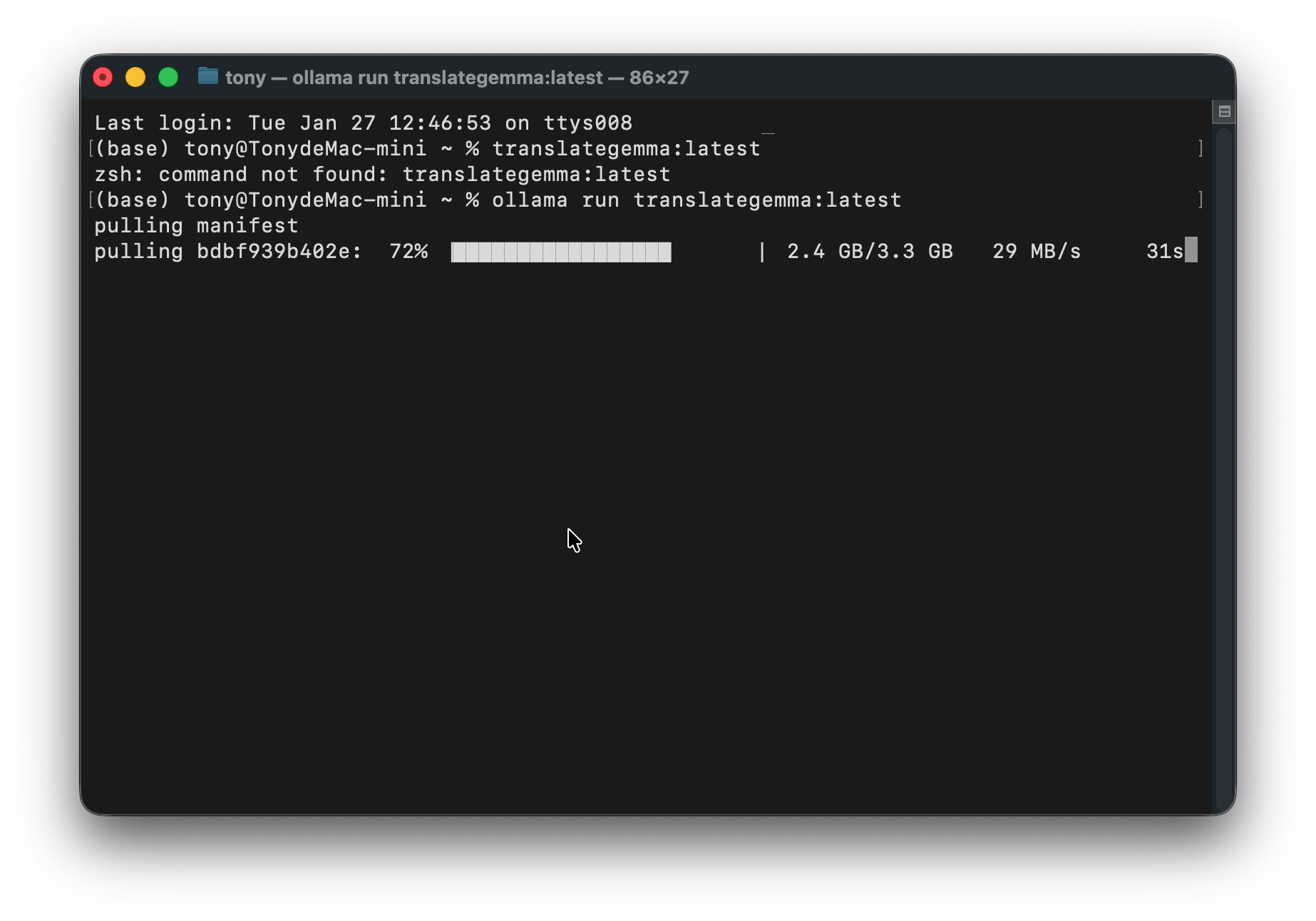

还有一种方式是使用命令下载,打开终端,输入命令回车:

ollama run translategemma:latest

下载过程如下:

命令下载有一个好处,不容易被墙。

我测试过,如果在界面里下载,有时候模型读取不出来。但是终端里面直接下载某个模型,却没有任何问题。国内下载速度也极快,几乎能把带宽拉满了。

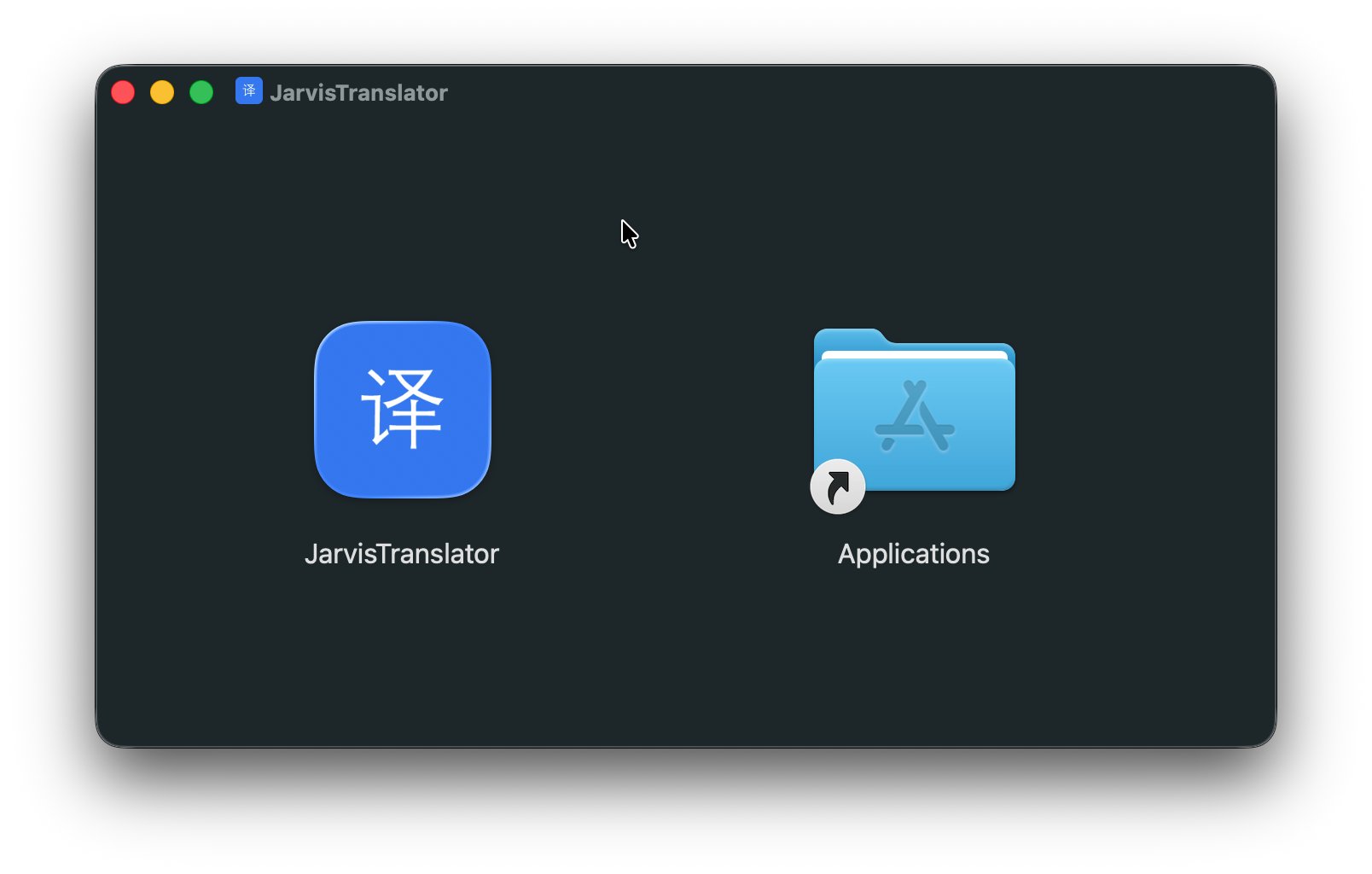

安装“甲译”

第三步,就可以安装我写的翻译软件了。 这个安装就实在没什么好讲了。直接双击软件,打开之后拖到应用里面就可以了。

然后打开软件就可以了

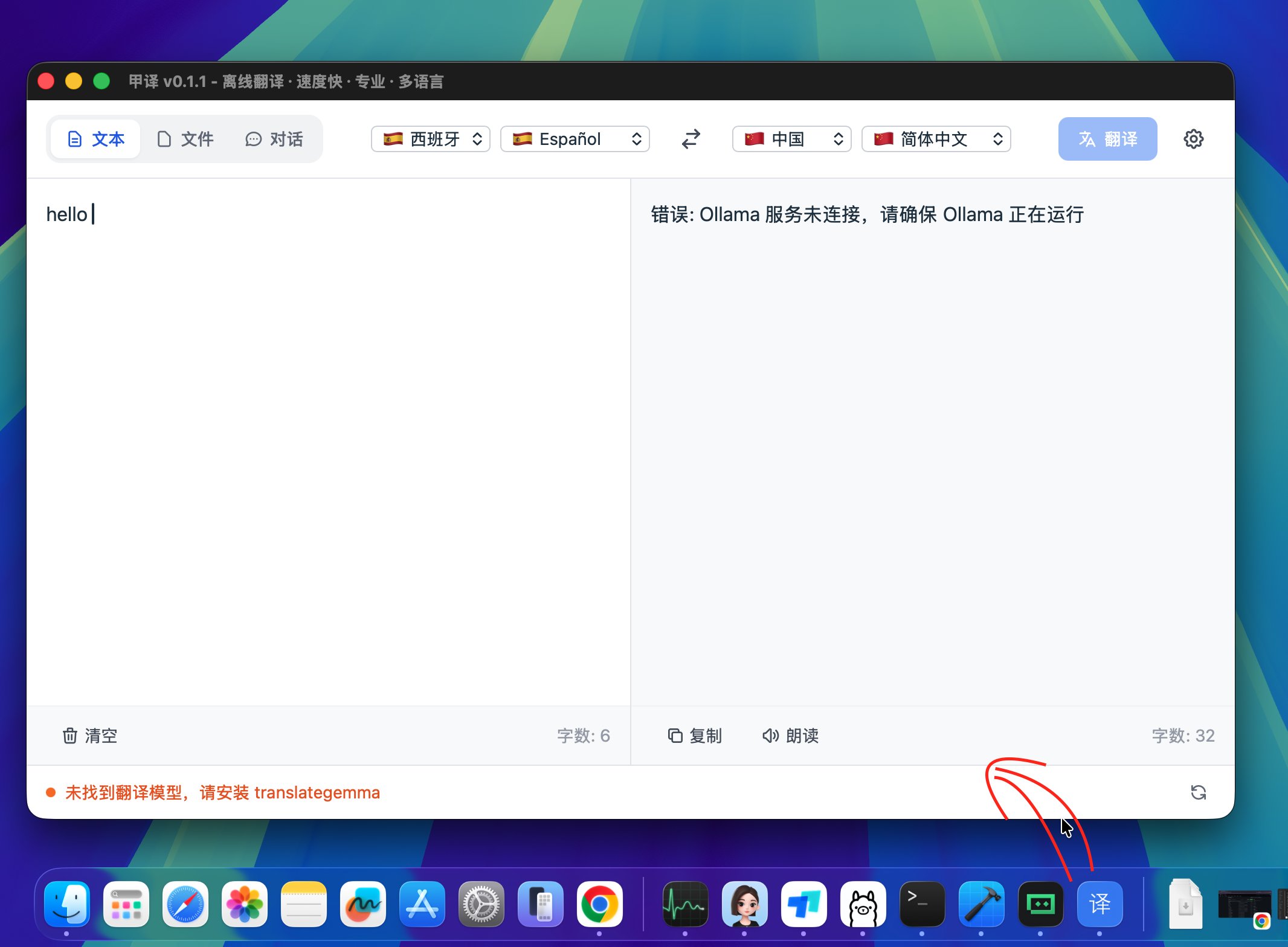

确保上面Ollama已经安装,模型已经下载。

如果没有前置步骤就会这样:

左下角会提示,未找到翻译模型,请安装。

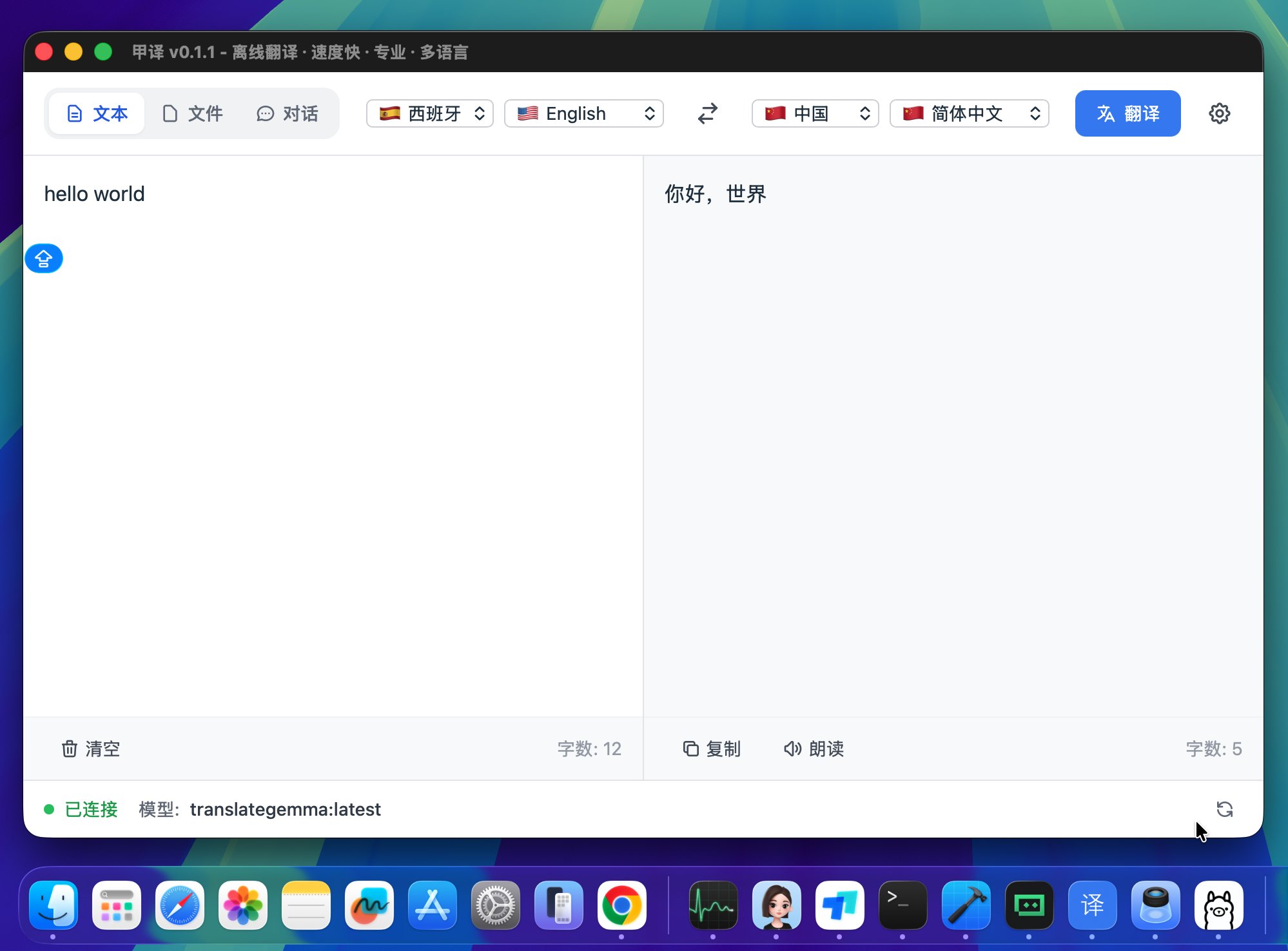

如果前面的步骤都做好了,打开之后就是这样:

左下角显示已经连接。

然后直接在左边输入框中输入需要翻译的内容就可以了。

不得不说,macOS下面的开发、安装、使用体验,确实要比windows好一点。

当时写这个代码的时候,claude就告诉过我,帮我把国旗也设置好了,我一直没理解。

直到在macOS打开,我终于懂了。同样的代码,Windows里面不显示国旗。

这里还要注意一点:

因为我还没有给库克交99💲的“保护费”,

所以安装软件的时候会被“保安”拦住。

但是,我不是坏人,你可以让保安放行。

具体操作如下:

当安装完成打开软件之后,它会提醒你“未打开Javis Translator”。

这个时候有两个选项:

- 完成

- 移到废纸篓

先选择“完成”。

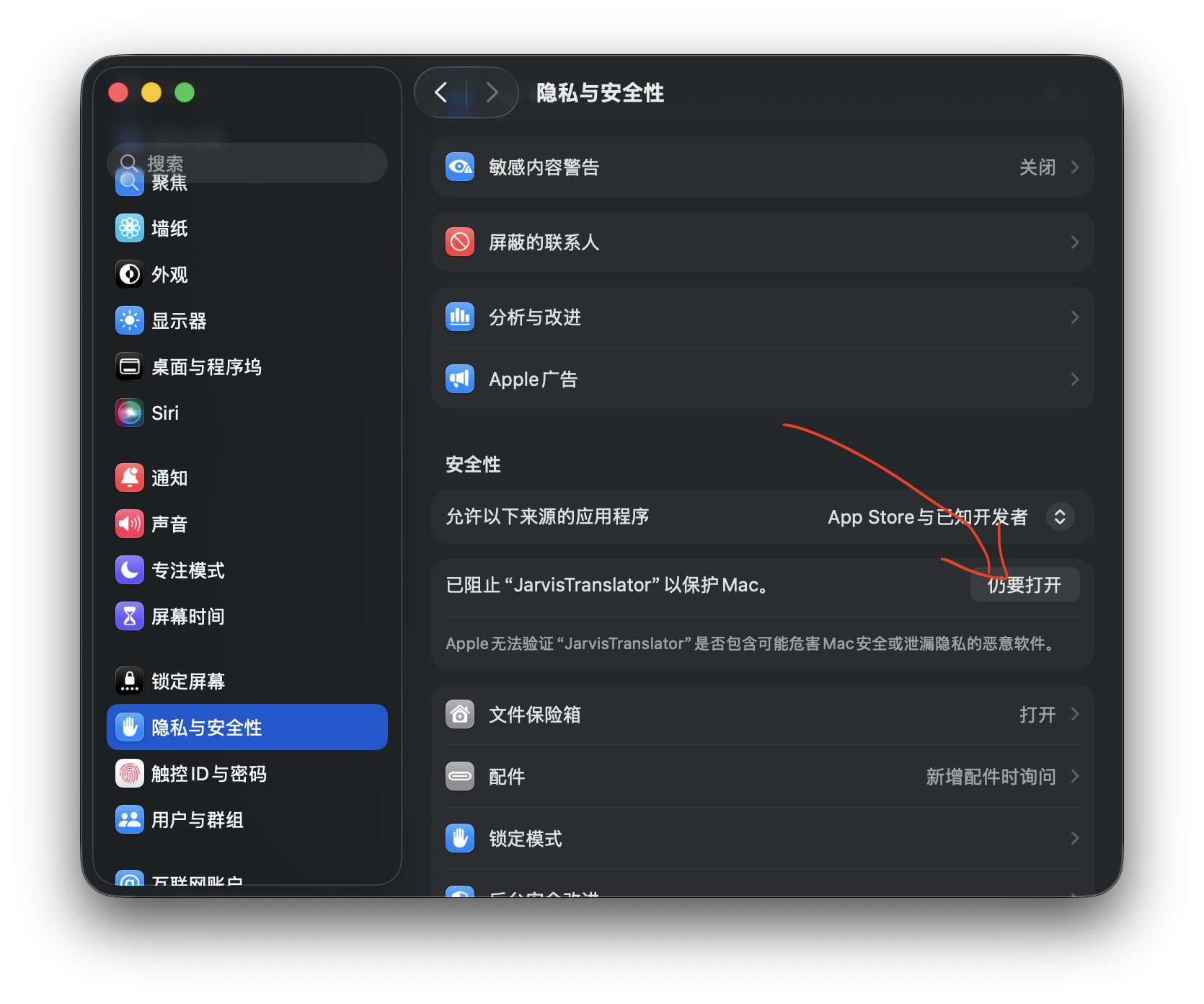

然后,打开设置,找到“隐私与安全性”,向下滚动找到“安全性”。

这个地方应该会显示:已经阻止 Jarvis Translator 以保护 Mac。点一下后面的“仍要打开”按钮。

然后他再次想要把甲译移到废纸篓里面,我们必须坚决的选择“仍要打开”。

坚持两个“仍要打开”之后,就可以正常使用了。 虽然他一直在提醒可能危害mac,但是它也说了除非来源可靠,我这来源绝对可靠💪。

不得不说,现在有了Claude Code确实方便,一天一个版本,只是脑力跟不上算力… 我拖后腿了!

如果有人对这个开发过程感兴趣,也可以关注“甲维斯C” 。

我会在哪里详细说明,我是如何花了几分钟搞定macos版本的。

大概就是这些吧!玩起来!

哦对了,获取方式 还是一样的。给公众号发私信“Ollama” 。