Wan2.2 升级版动作同步工作流配置记录

ComfyUI 官方提供的工作流简单清晰,依赖也比较少,作为学习素材是非常好的。但是它的工作流也充满局限。为了搞出更好的效果,我翻遍 RH,下载、配置、运行,搞了好几天,终于跑通了两个不错的工作流。

今天分享一下其中一个工作流的安装配置记录。 这次配置中可以学到不少知识点。

1.启动软件

在之前的文章中我已经详细介绍过 ComfyUI 便携版的安装,以及 ComfyUI 节点管理器的安装。下面就在这个基础上进行配置。

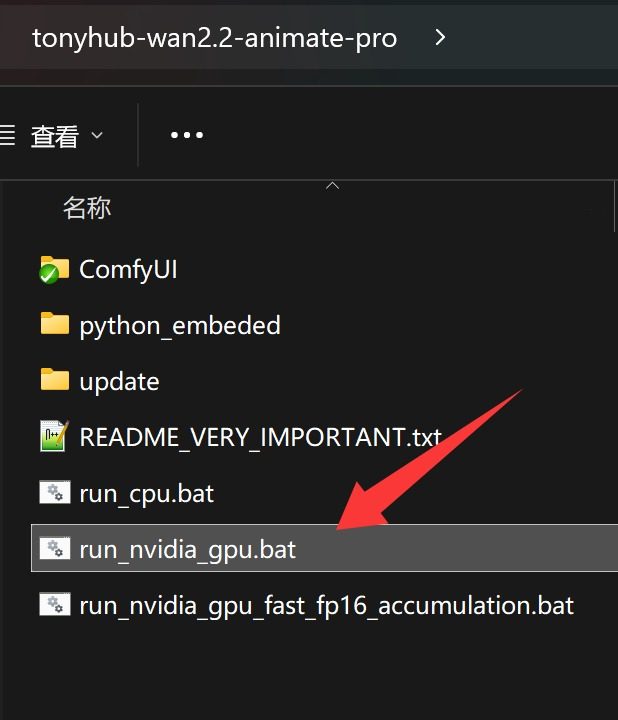

第一步是启动软件,直接点击 run_nvidia_gpu 启动。

启动之后会自动加载插件,自动打开浏览器,并跳转到 ComfyUI 主界面。

2.加载工作流

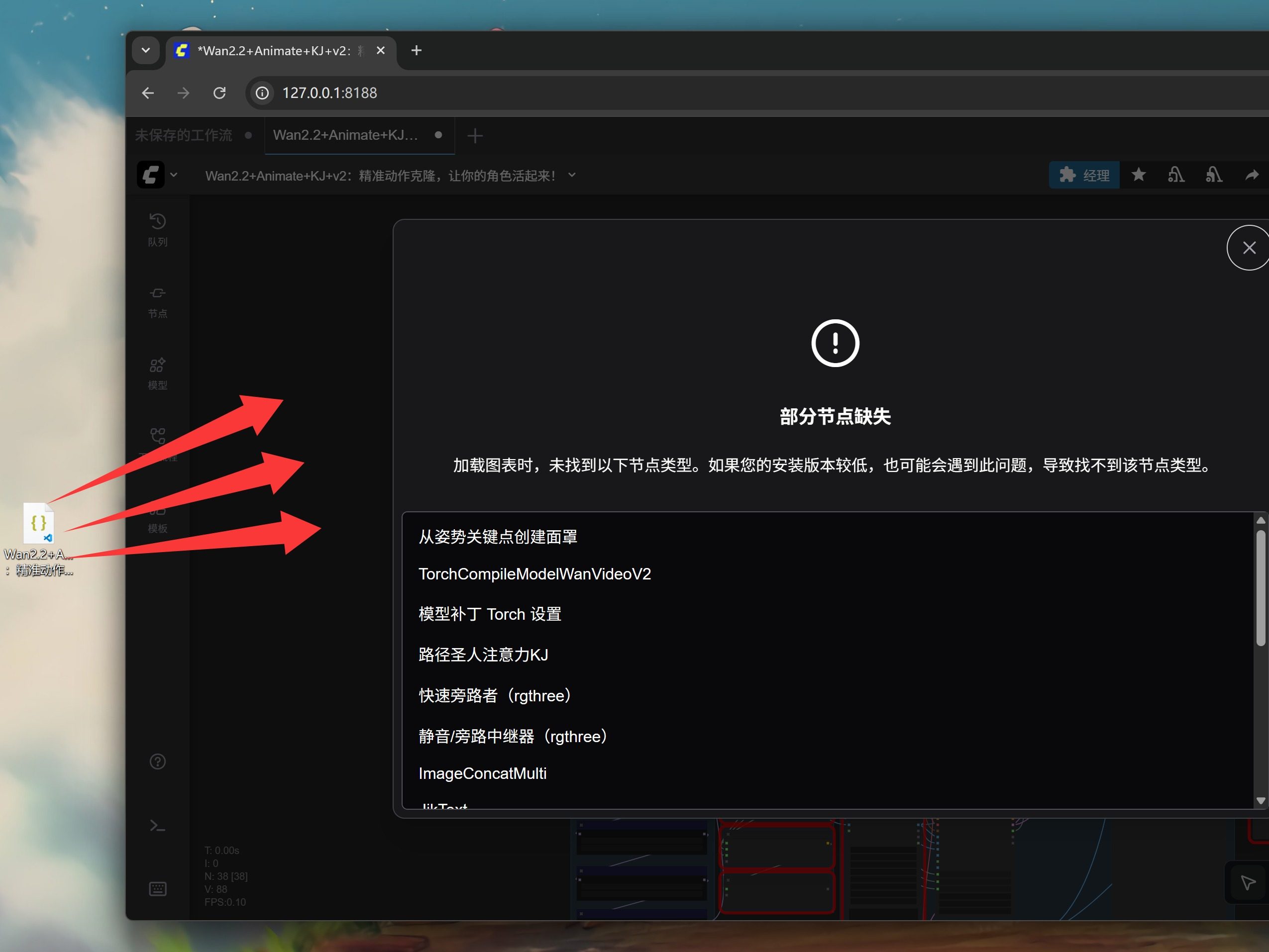

软件打开之后就可以加载工作流了,只要找到工作流的 .json 文件,直接拖动到界面中即可。

由于这个工作流涉及到了很多第三方节点,所以拖进去之后会弹出提示窗口,告诉你缺了什么节点。可以先把这个弹窗关掉。

然后就会看到完整的工作流了。

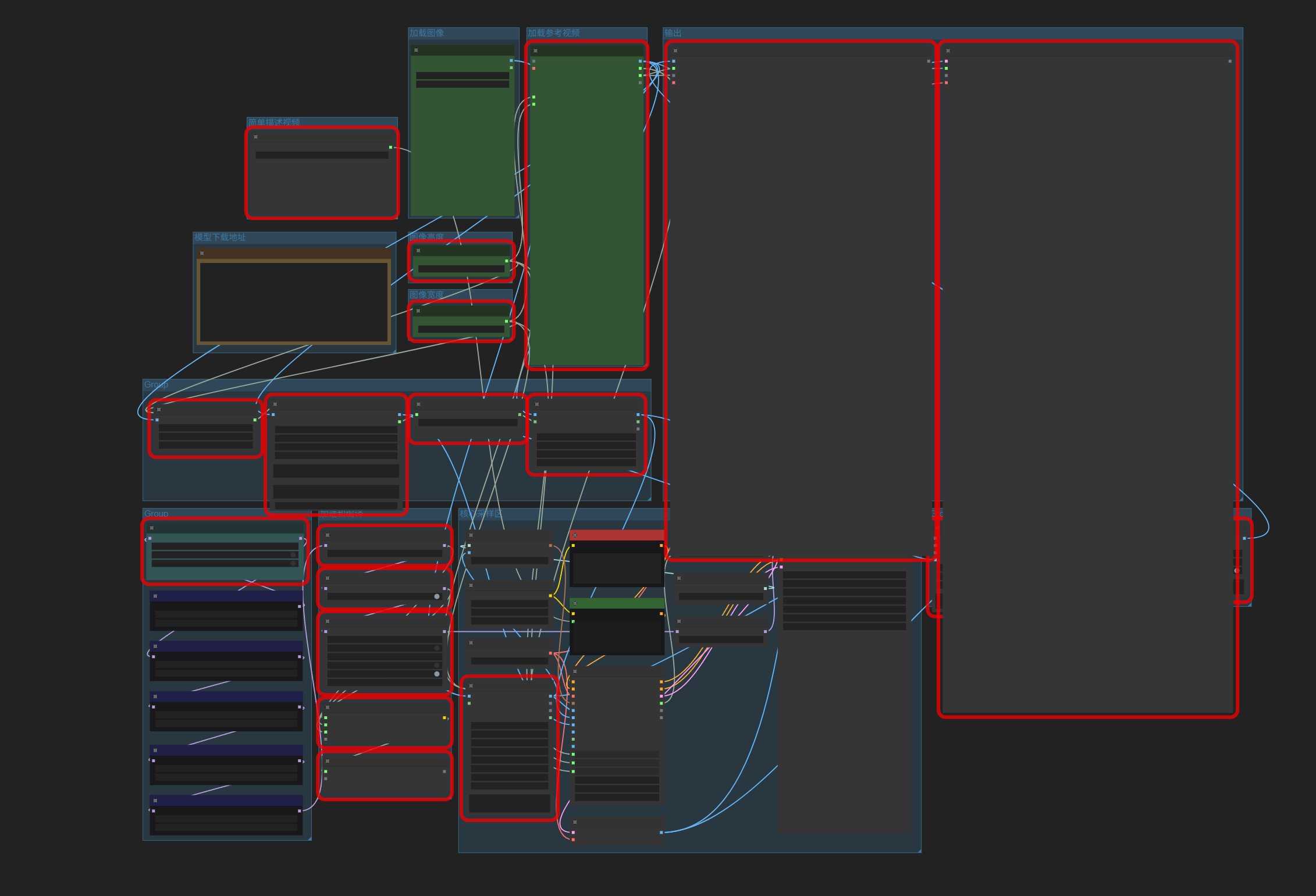

由于缺少节点,会有很多红色框。不用担心,下面就说解决方法。

3.安装插件

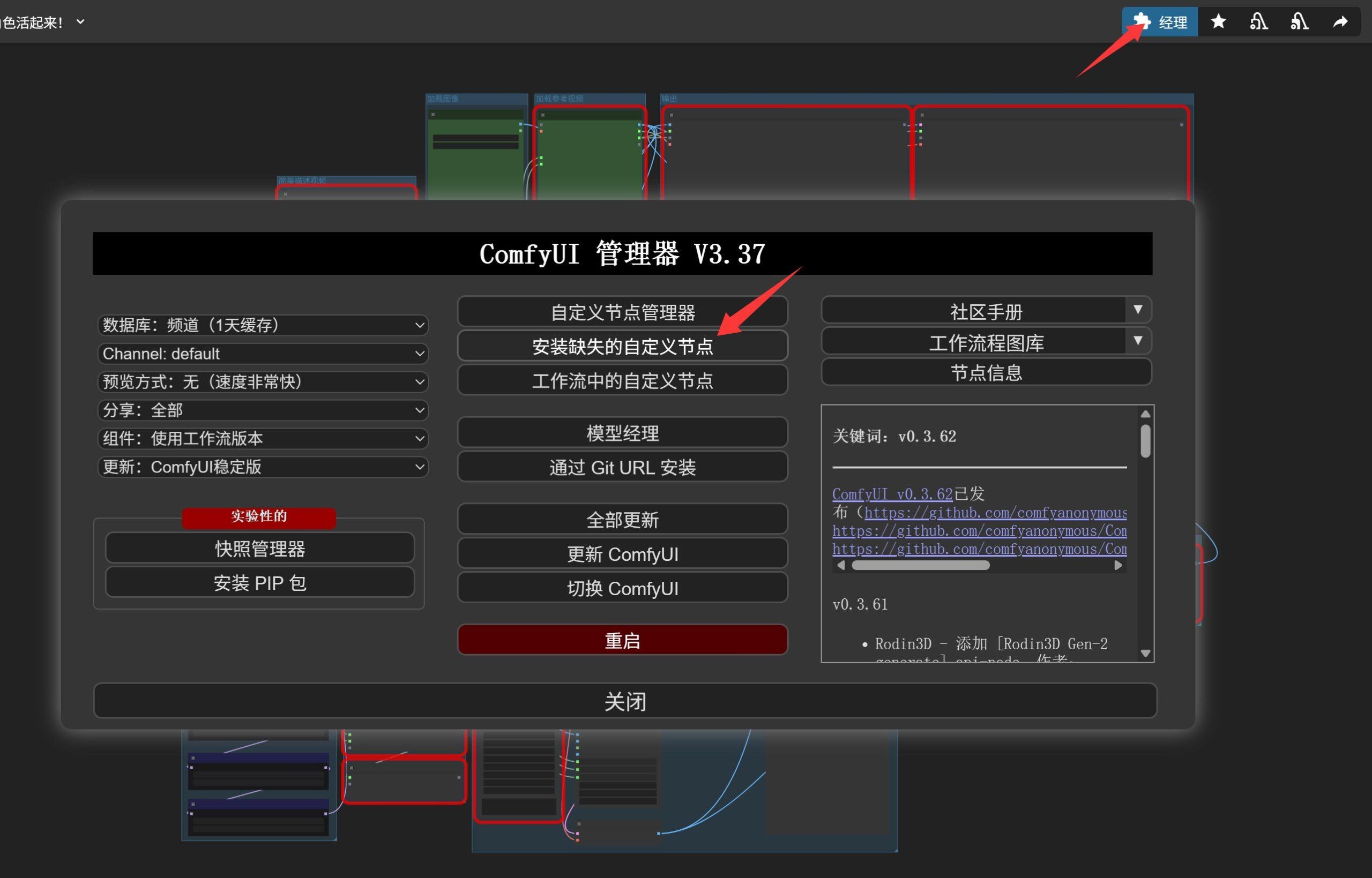

点击右上角的“Manager”按钮,打开节点管理器,准备一键安装所有插件。

点击之后就会看到“自定义节点管理器”和“安装缺失的自定义节点”。这两个功能都可以快速安装节点,最方便的是第二个按钮,可以一次性列出所有缺失节点插件。

点击之后显示如下:

勾选所有插件,然后点击安装。

安装完成之后点击重启。

重启完成之后,会提醒你是否刷新。点击确认。

一般来说,重启完成节点就都正常了。

也有可能还有节点不正常。可以用上面方法重新搞一次,然后手动重启一下。

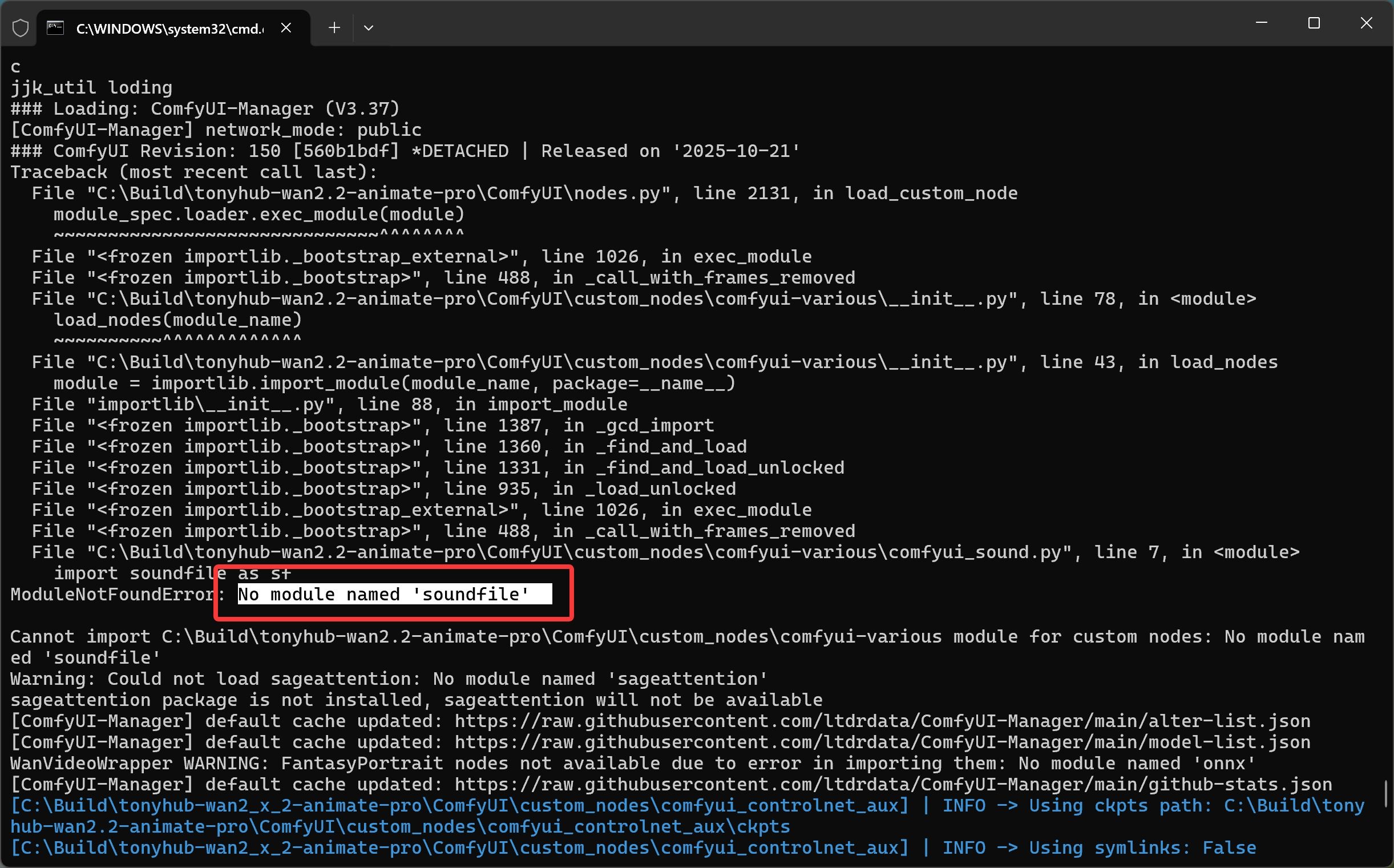

如果还是有错误,比如我遇到了下面的情况:

黑色窗口中如果出现红色提示、波浪线、Traceback、No module 等信息,就表明启动过程中遇到了问题。大部分情况是缺少模块或者模型。

我这里是提示缺失一个叫 soundfile 的模块。

解决这个方法也很简单。

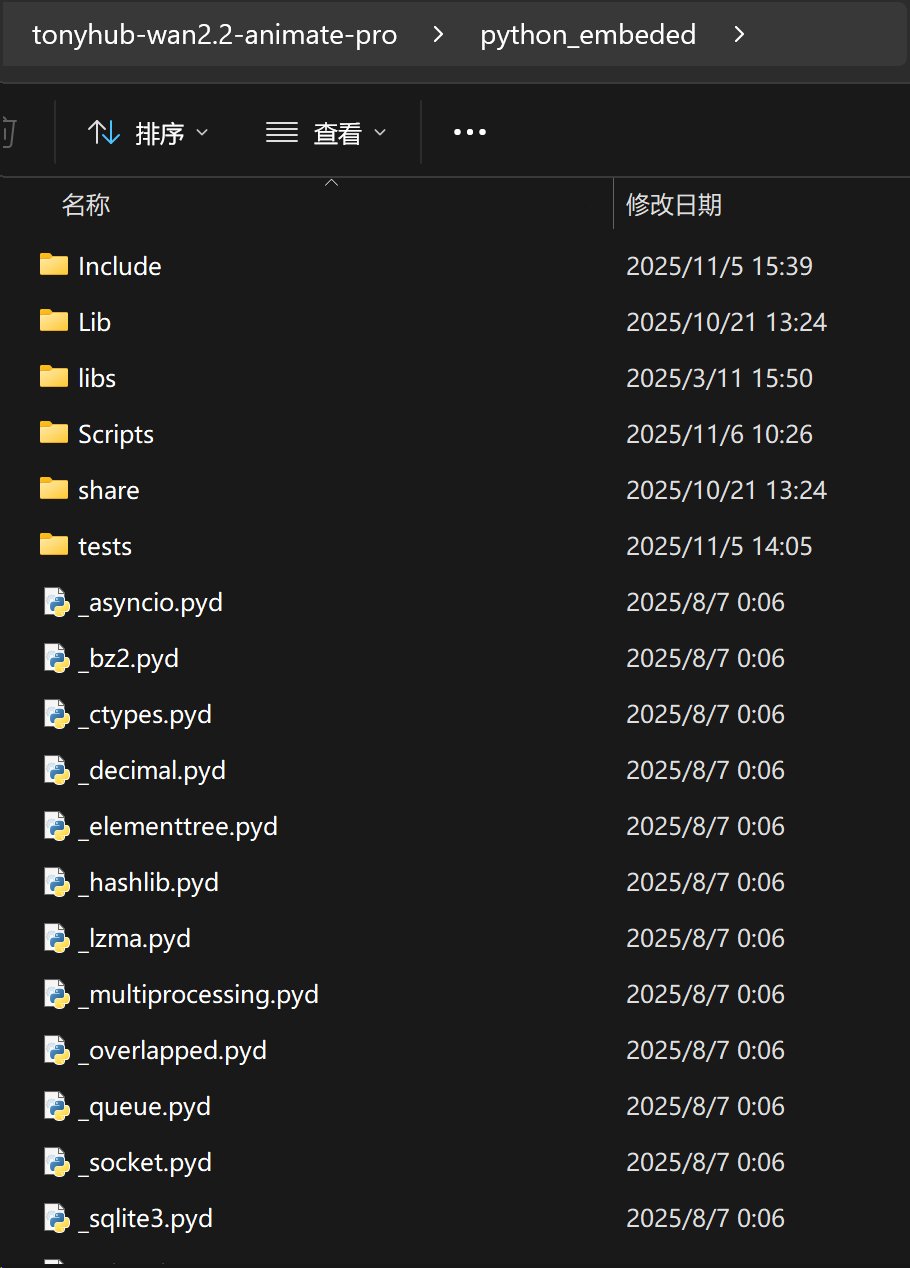

找到 ComfyUI 解压目录下的 python_embeded 文件夹,并打开。

这个文件夹里面包含了一个独立的 Python 环境,各种依赖都是安装在这个环境里面。所以必须先打开这个文件夹,然后在这个文件夹中执行命令。

空白处右键 -> 终端中打开 -> 输入命令。

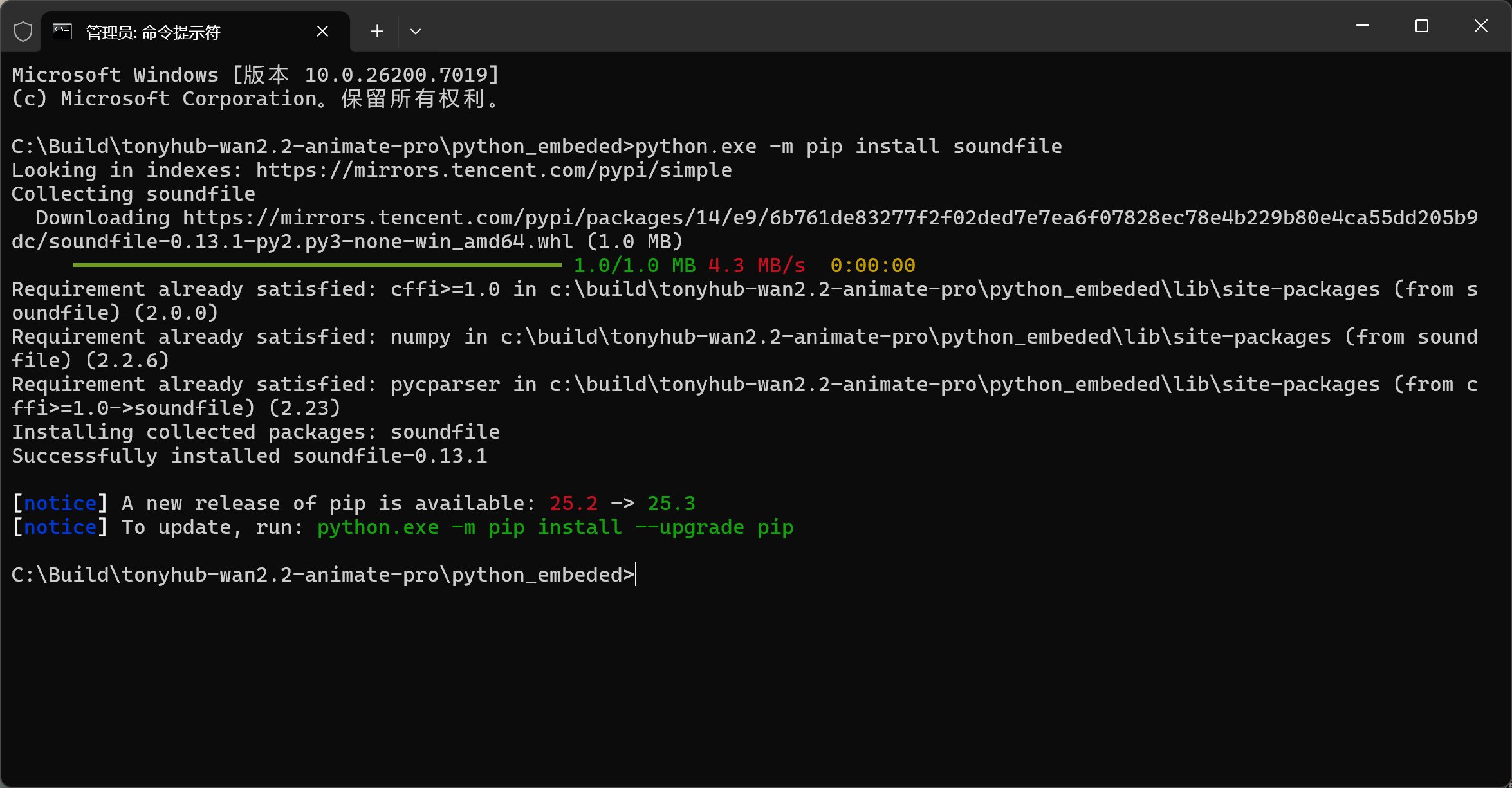

命令如下:

python.exe -m pip install soundfile

按一下回车键,等待运行完成,出现 Successfully。

这里的 python.exe -m 是必写内容,不写就无法把依赖安装到我们特定的运行环境中。

安装完成之后,重启一下 ComfyUI 就没有这个错误了。然后可以进入下一步。

4.放置模型

在之前的文章中,我们打开工作流之后,会自动提示缺失模型,以及模型的下载链接。那个是官方流特有的机制,第三方工作流并不会提醒。只能我们自己去看模型加载器里加载了什么模型。

如果你分不清哪些是模型加载器,可以先随便设置两个素材,然后点击运行。运行过程中会把加载文件的部分标红。

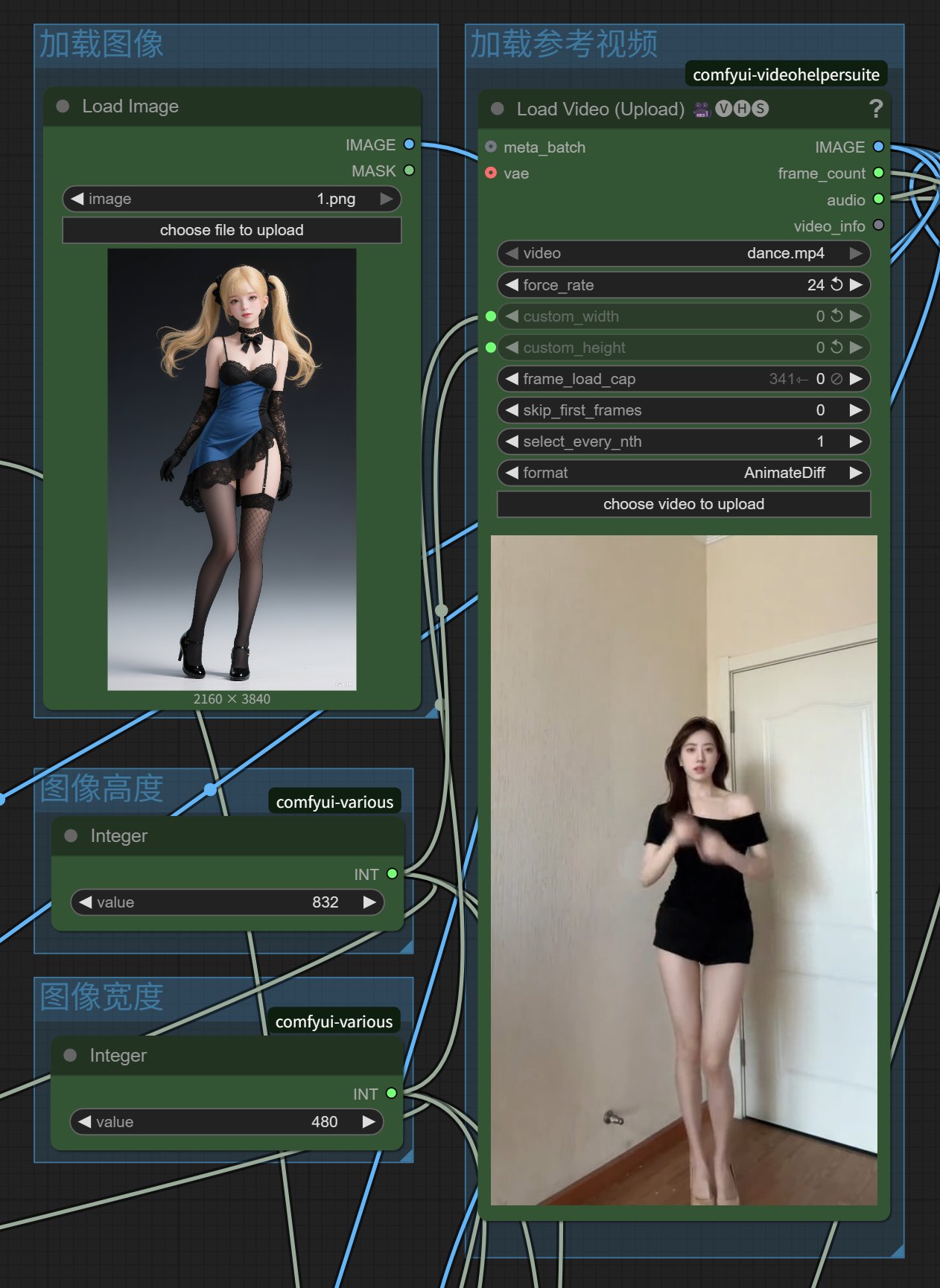

比如我随便加载一张图片和一个视频,然后点击运行。

工作流就会自动标红加载模型的模块。

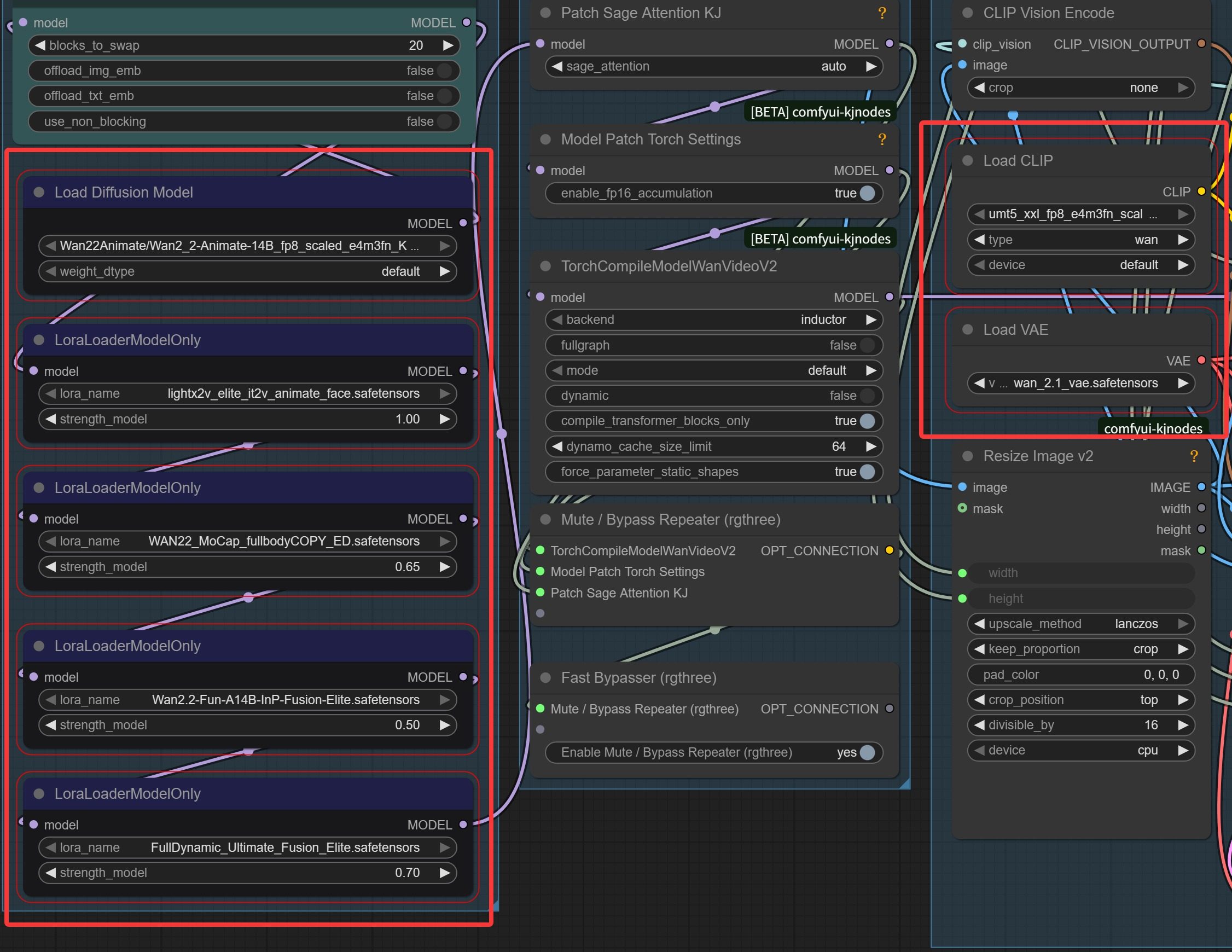

可以看到这里有七个加载节点标红了。这些就是加载模块,每个模块里面都有一个文件名字。

很多工作流并不会告诉你这些模型在哪里,这个时候就需要自己去寻找了。

寻找方法也很简单,只要根据这些模型的名称去谷歌搜索下载即可,基本都来自 Hugging Face。

下载的时候要注意,名字必须一字不差。

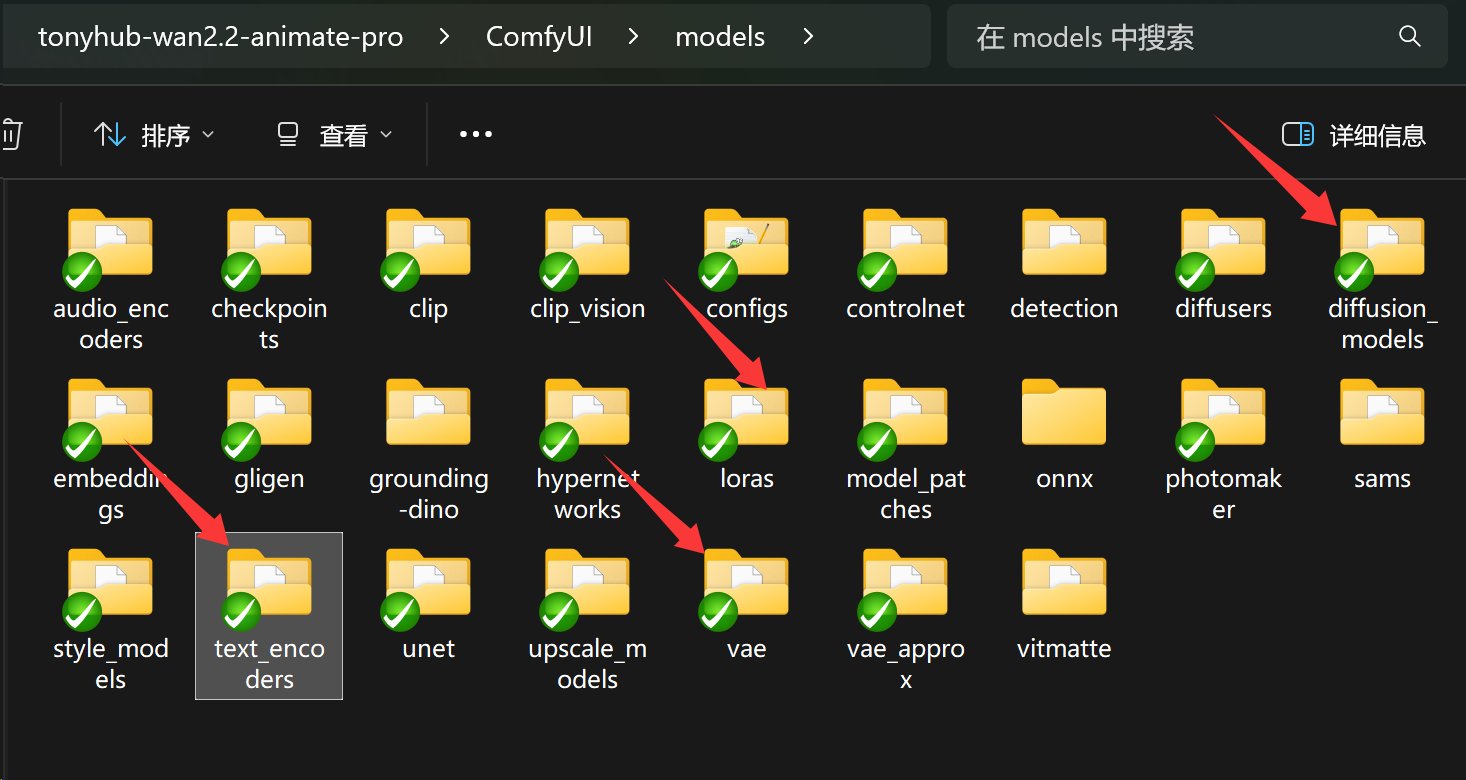

下载完成之后放到对应的路径。

这里主要有四类模型:

- diffusion_models

- lora

- vae

- text_encoders

根据 节点名称和文件夹名称 的对应关系放置就可以了。

其中 Load CLIP 这个模型是放在 text_encoders 里面的。这两个名字看起来不相关,所以我特别强调一下。

5.安装加速依赖

正常来说,模型放完就可以运行了。

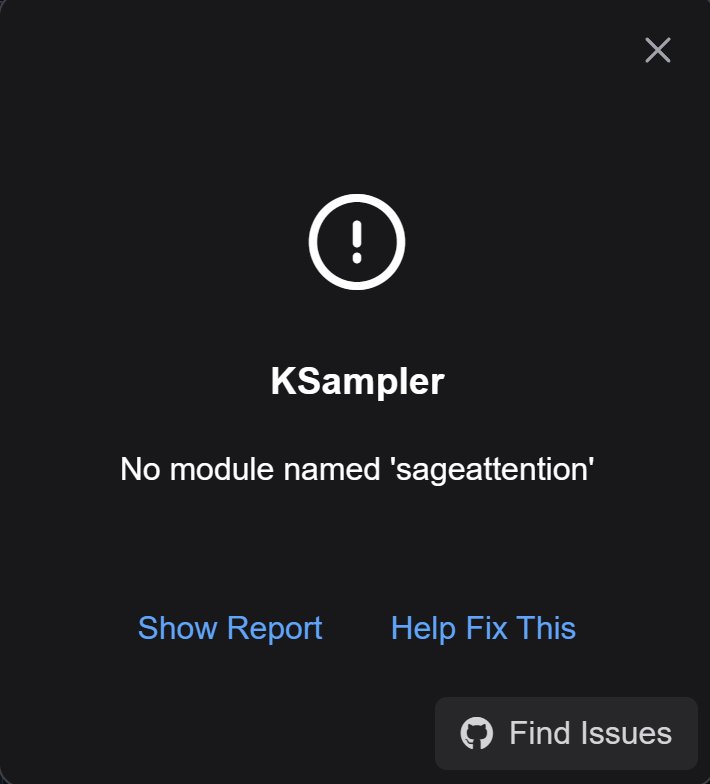

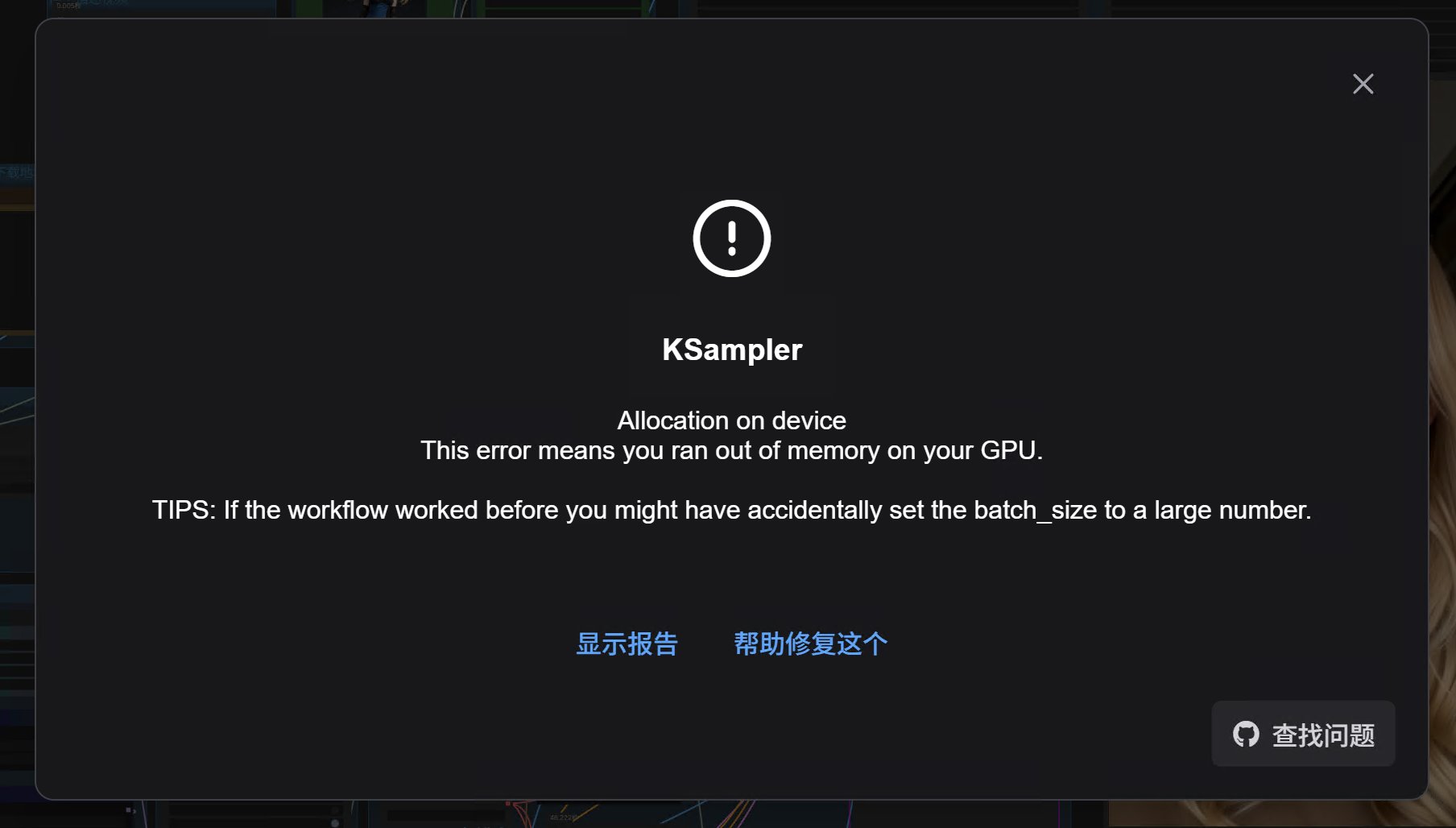

但是,这个工作流用到了一个 Windows 下的加速包。如果你不安装,就会报错。

错误提示如下:

提示 KSampler:No module named ‘sageattention’。

SageAttention 是一种针对大模型推理加速的 Attention 优化算法 / 内核,主要用于替换传统的 FlashAttention / 标准注意力计算,目标是:

降低显存占用 + 提升推理速度 尤其是在 长序列(长上下文) 的情况下。

在 Windows 上安装这个依赖,又折腾了很久。下面分享一下我的最终解决方案。

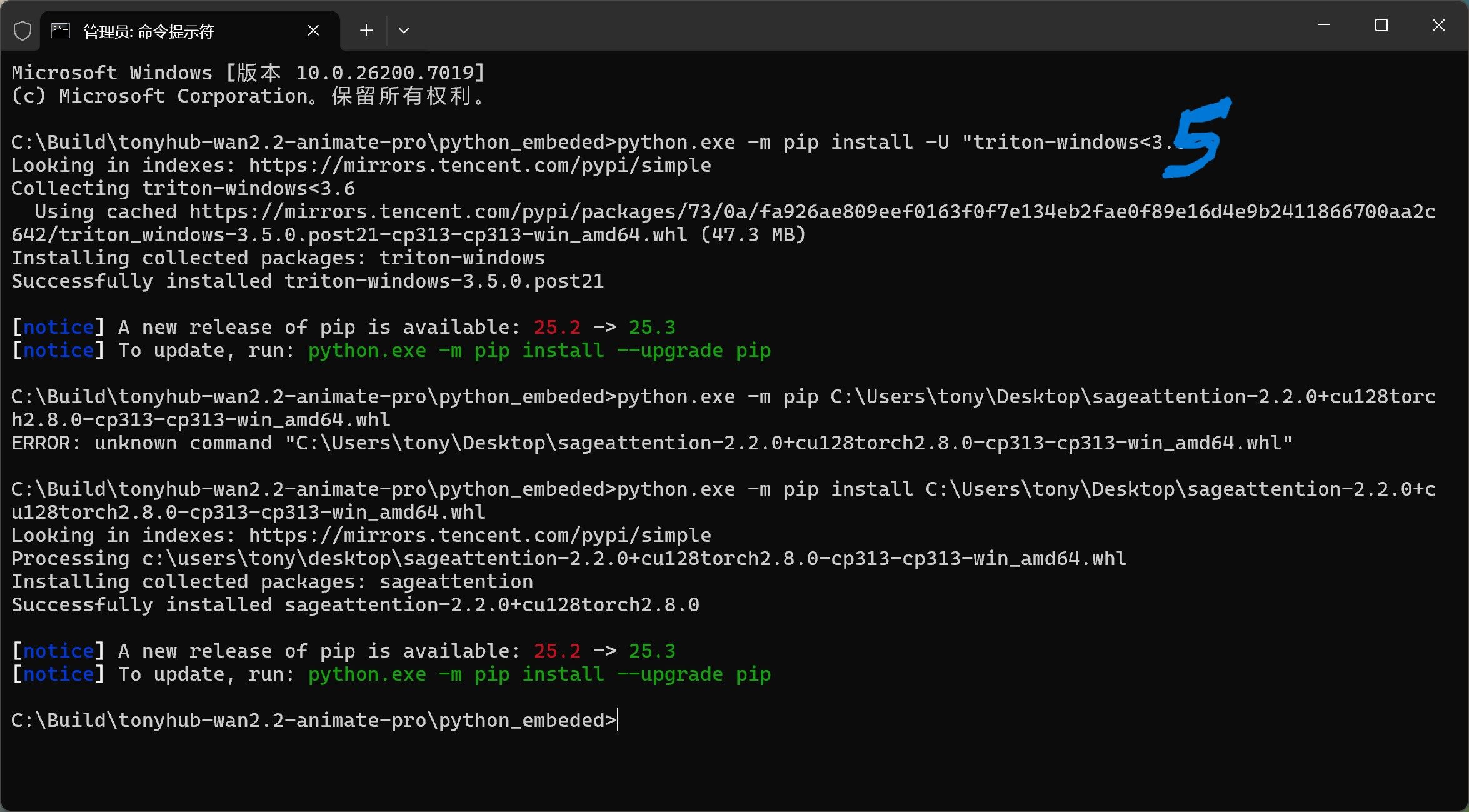

用上面安装依赖的方法,进入 python_embeded 文件夹,右键在终端中运行。

然后依次输入两行命令:

运行过程如下:

其中用到了一个 .whl 文件,需要自己手动下载。

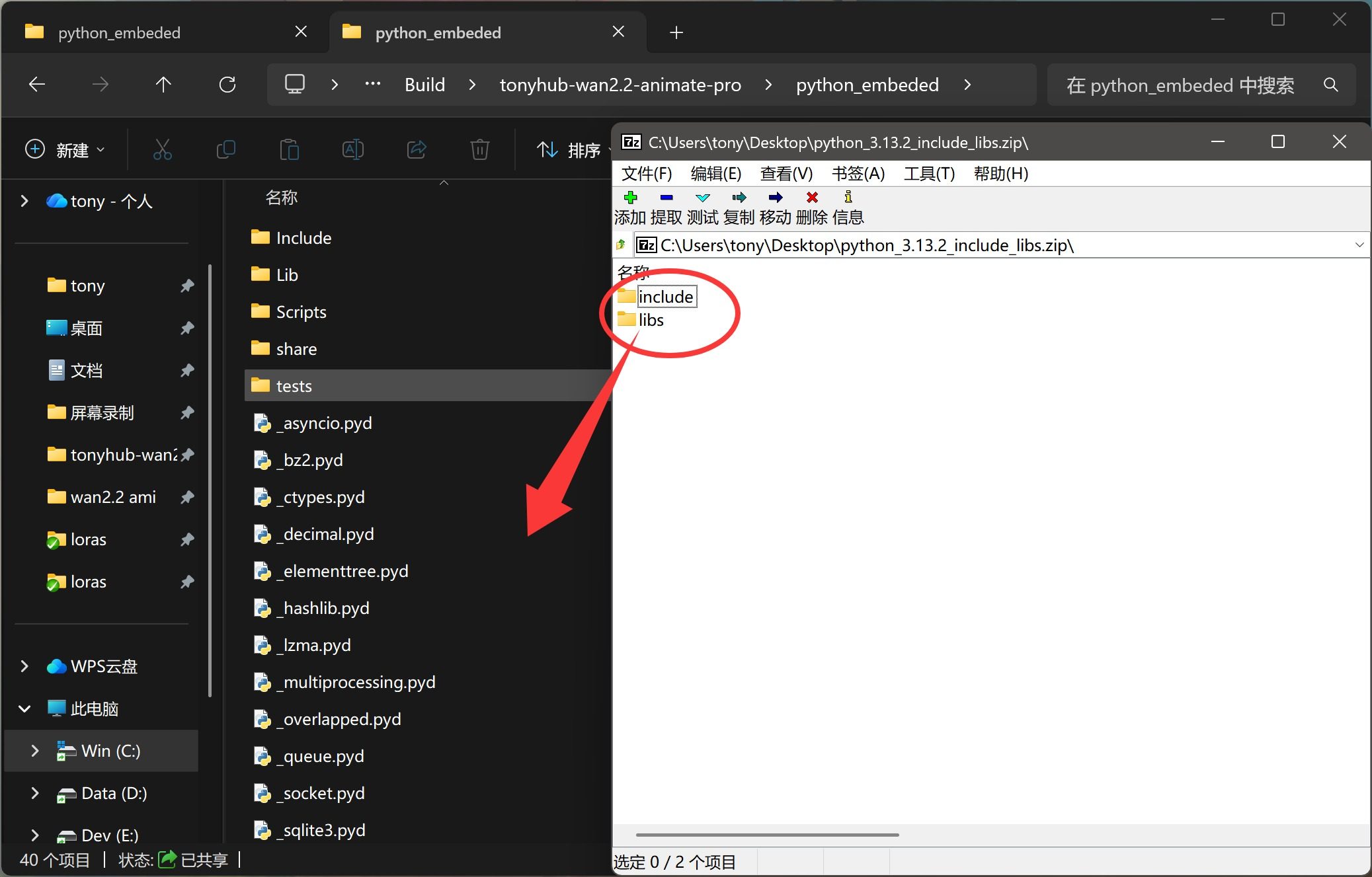

安装完依赖之后,其实还有一个问题:由于便携版使用了不完整的 Python 环境,所以又会遇到新问题,有的要折腾很久。

具体的解决方案就是安装完整的 Python 3.13,然后把里面两个文件拷贝到 ComfyUI 的便携环境中。

全部搞完之后,整个环境就部署好了。

这一步的详细操作可以参考:

https://www.tonyisstark.com/3956.html

接下来,可能还会遇到一个问题:显存不足。这个问题基本无解,要出高质量的效果,就得上大家伙。

其实也不是说完全无解。有一些优化显存的工作流,可以大幅降低显存需求。这个我们后续再详细讨论。

6.运行

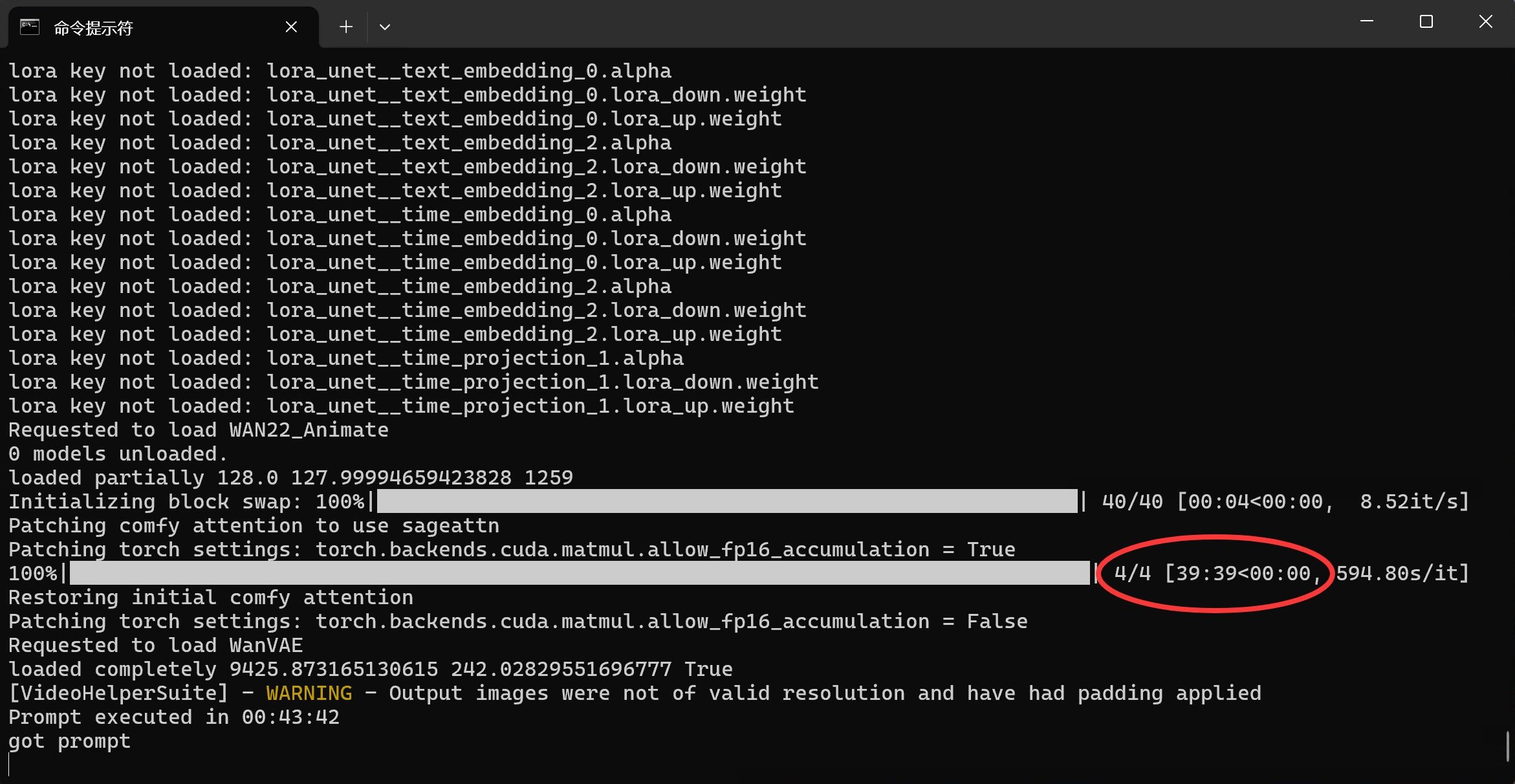

终于,经过几天的摸索和排错,一切准备就绪,可以开干了。

接下来只要选择好的素材,点一下运行,把一切交给时间。

选素材的时候注意一下,这个工作流比较适合两种场景,一类是表情控制,聚焦上半身。一类是跳舞,聚焦全身动作。

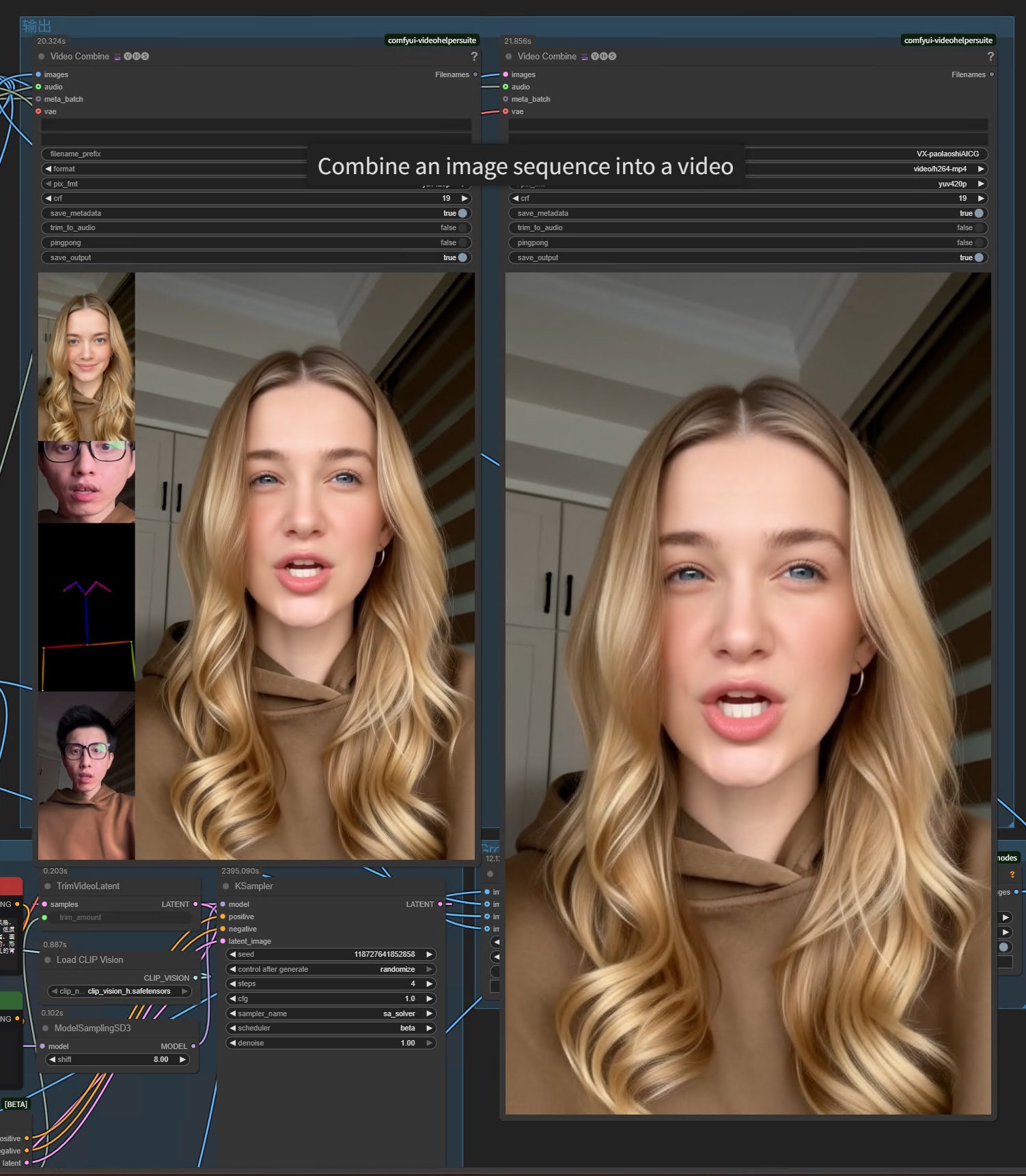

最后就可以看到结果了。

这个工作流生成的质量还是非常不错的:画面清晰,色彩正常,表情同步和动作同步都非常精准。

从目前来看,要在本地的个人电脑上生成高质量的 AI 视频,还是有一些难度,但是已经看到曙光了。

Wan2.2 这个系列只要把效果再提升一点、显存再降低一些、效率提升一些,那可是大有可为。

现在的 AI 视频已经到了井喷期,就像一年多前的 AI 图片一样。另外 AI 声音克隆、语音合成也变得非常自然、非常强大。只要掌握好工具,完全可以手搓一个数字人:能说、能唱、能跳。