本地开发闭环了? Ollama+GLM4.7+Claude Code

Ollama 竟然也支持 Anthropic 协议了,这下 Claude Code 无处不在了。

Ollama 0.15 版本一次性支持了 Claude Code、Codex、opencode、droid。最近他们还上新了 GLM-4.7-flash。

这不就完美闭环了啊。

直接可以搭建一套完全开源本地运行的编程环境了。

虽然,我们都知道这肯定是玩具,但是这玩具也太好玩了。

我们可以实现:

- 完全离线运行

- 完全免费

- 无限 token

这不是爽翻天。今天赶紧跟着官方教材来配置一下,运行看看,效果如何。其实我好几天前就开始尝试了,但是由于版本还没到位,一直失败。今天终于被我跑通了。

首先安装 Ollama v0.15.0,一定要这个版本,比这个小的版本都不行,我是浪费了一天时间,才确认这个事情。

快速验证接口。

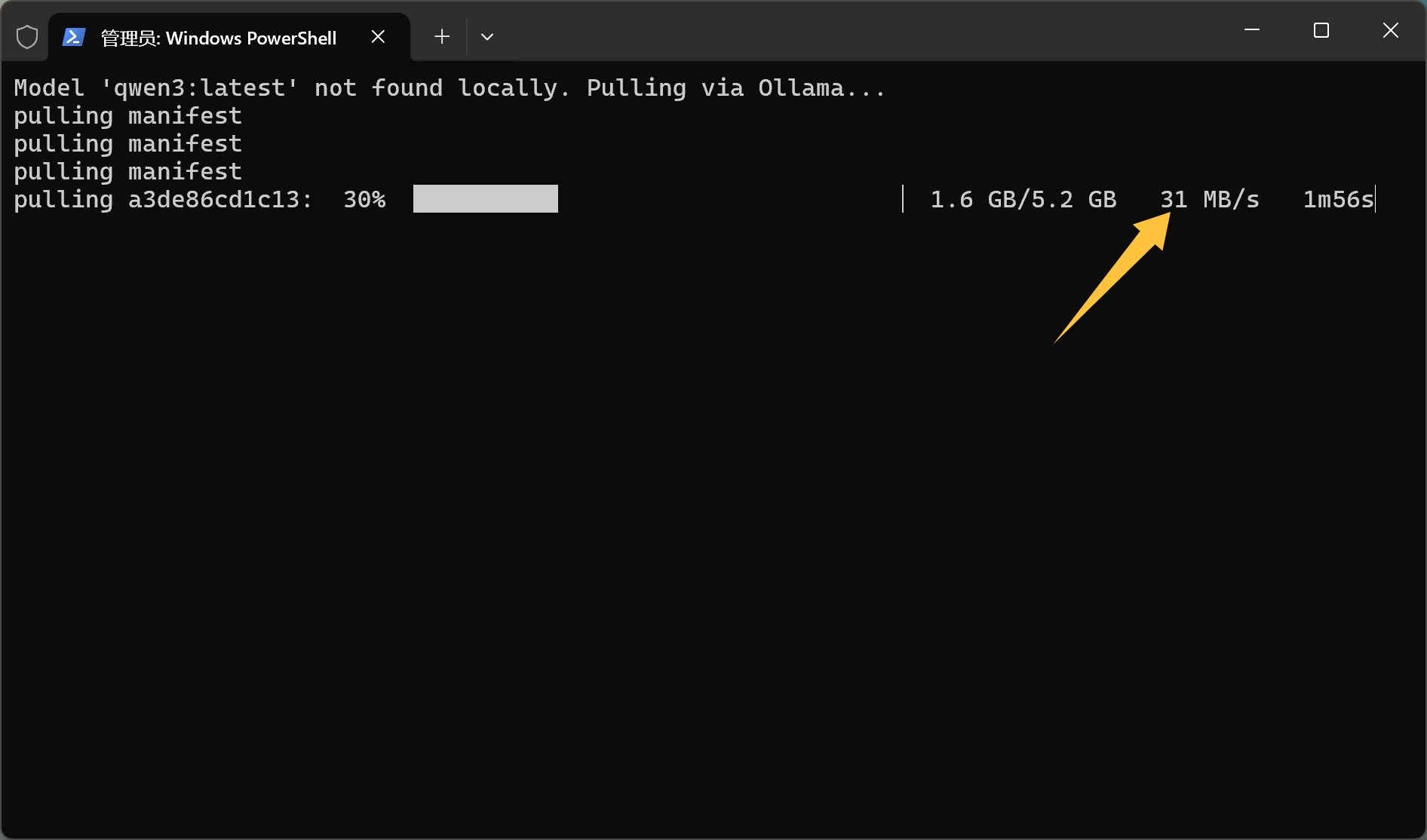

到底能不能用,我们先用一个小模型和 PS 脚本来快速验证一下:

# Configure Claude Code to use local Ollama (Anthropic-compatible API)$env:ANTHROPIC_AUTH_TOKEN = "ollama"$env:ANTHROPIC_BASE_URL = "http://localhost:11434"$env:ANTHROPIC_API_KEY = "ollama"# Optional: run Claude Code (uncomment to use)$model = "qwen3:latest"$modelExists = (ollama list | Select-String -SimpleMatch $model)if (-not $modelExists) { Write-Host "Model '$model' not found locally. Pulling via Ollama..." ollama pull $model}claude --model $model

把这个保存为 PowerShell 可以运行的 claude-code-ollama-qwen3.ps1 脚本。

这个脚本的逻辑是,首先查看 Ollama 中是否有 qwen3:latest 这个模型,如果没有的话,使用命令去下载,下载完成之后,就启用 Claude Code。

运行这个脚本的方式是,直接右键,使用 PowerShell 运行。

首次打开自动下载模型:

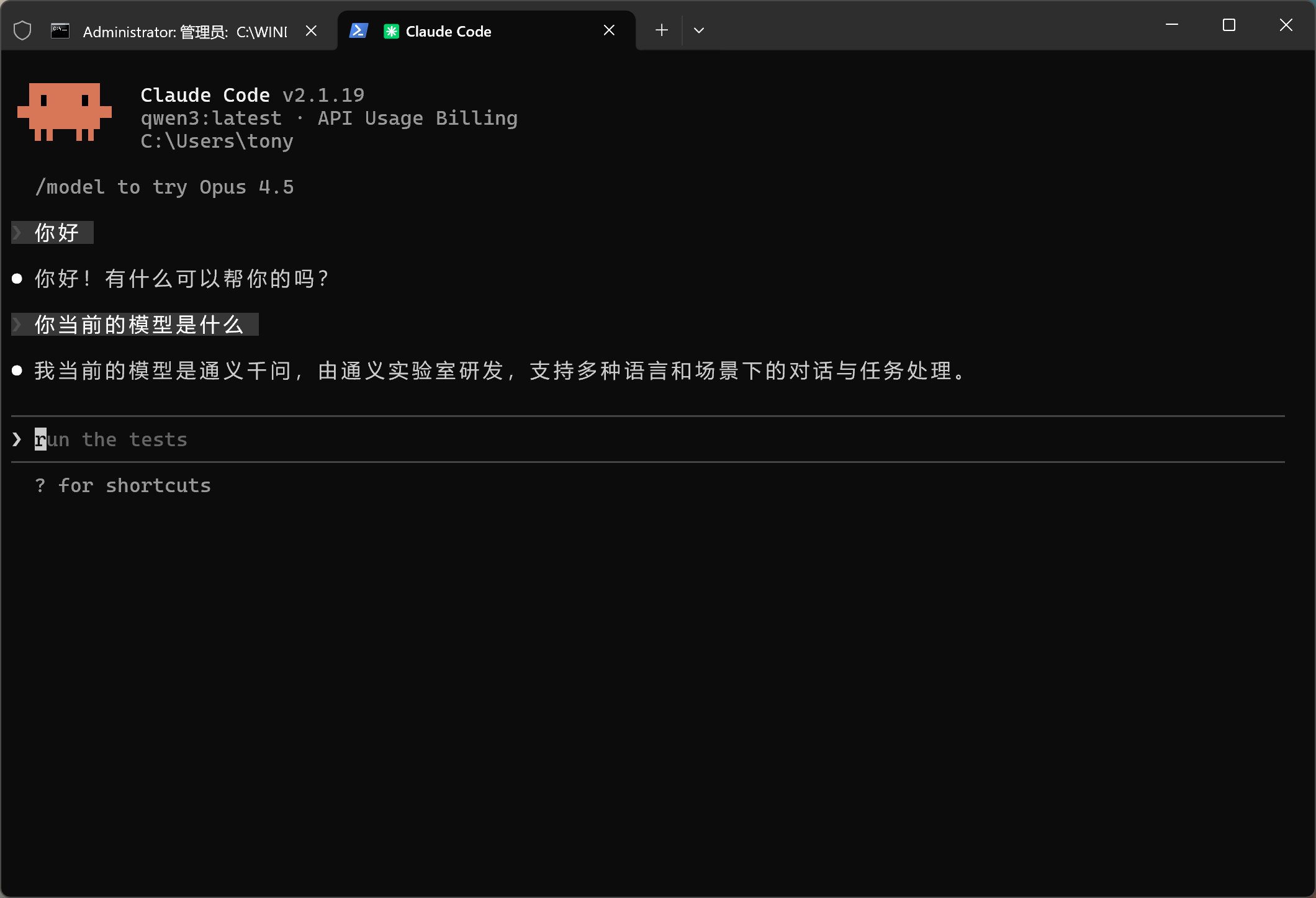

下载完成自动打开 Claude Code:

问一下他是谁,他说他是通用千问。

这就证明,我们已经可以通过 Anthropic 结构调用 Ollama 中的模型了。

开始切换 glm-4.7-flash:latest

因为 qwen3 模型比较小,而且对 Claude Code 支持不好,所以我们需要切换 glm-4.7-flash。

可以直接切换上面脚本中的名字,重新运行一次就可以了。

也可以用另外一种方法,使用 CC-Switch。

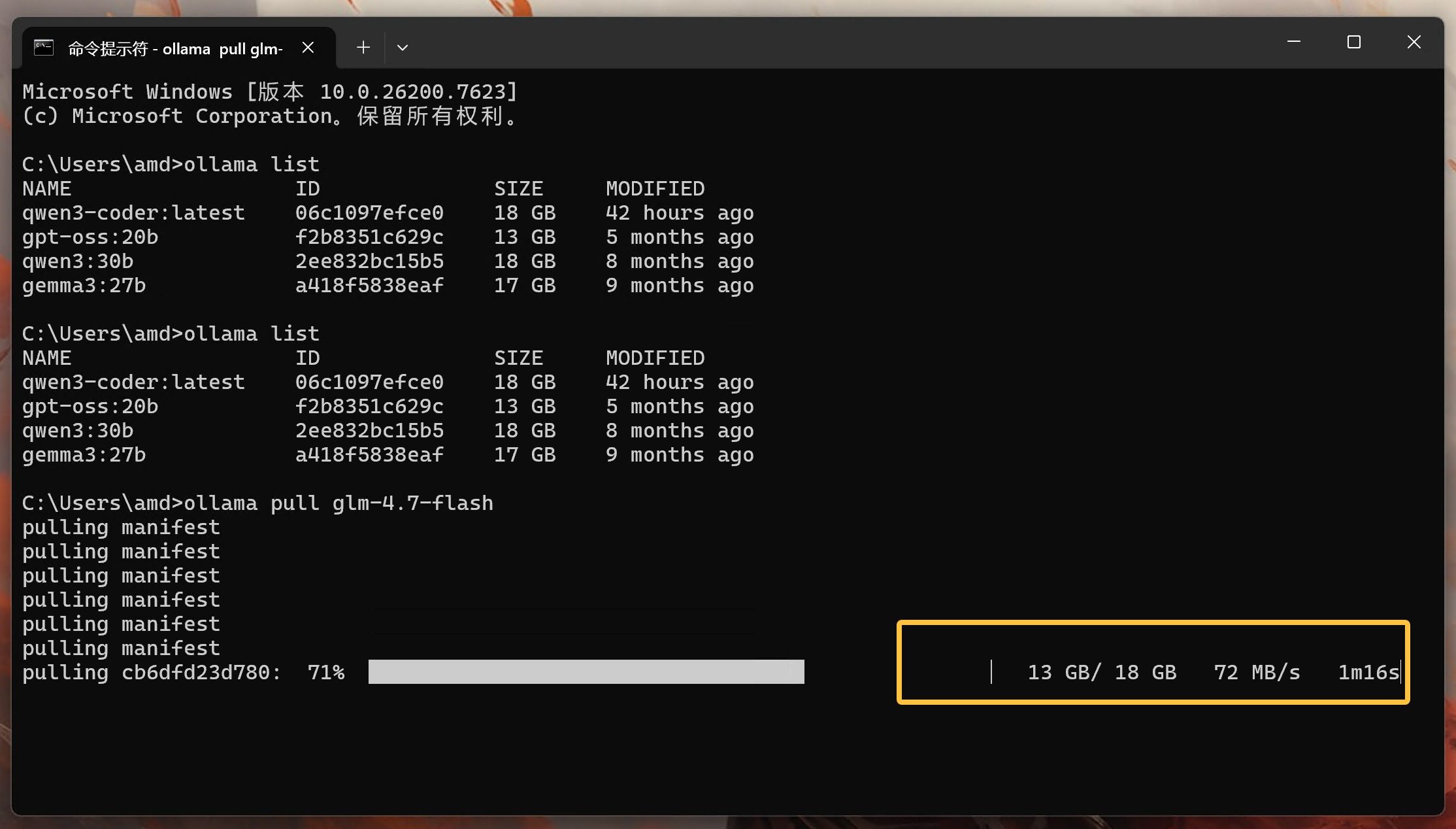

先手动下载模型。

使用如下命令:

ollama pull glm-4.7-flash

过程如下:

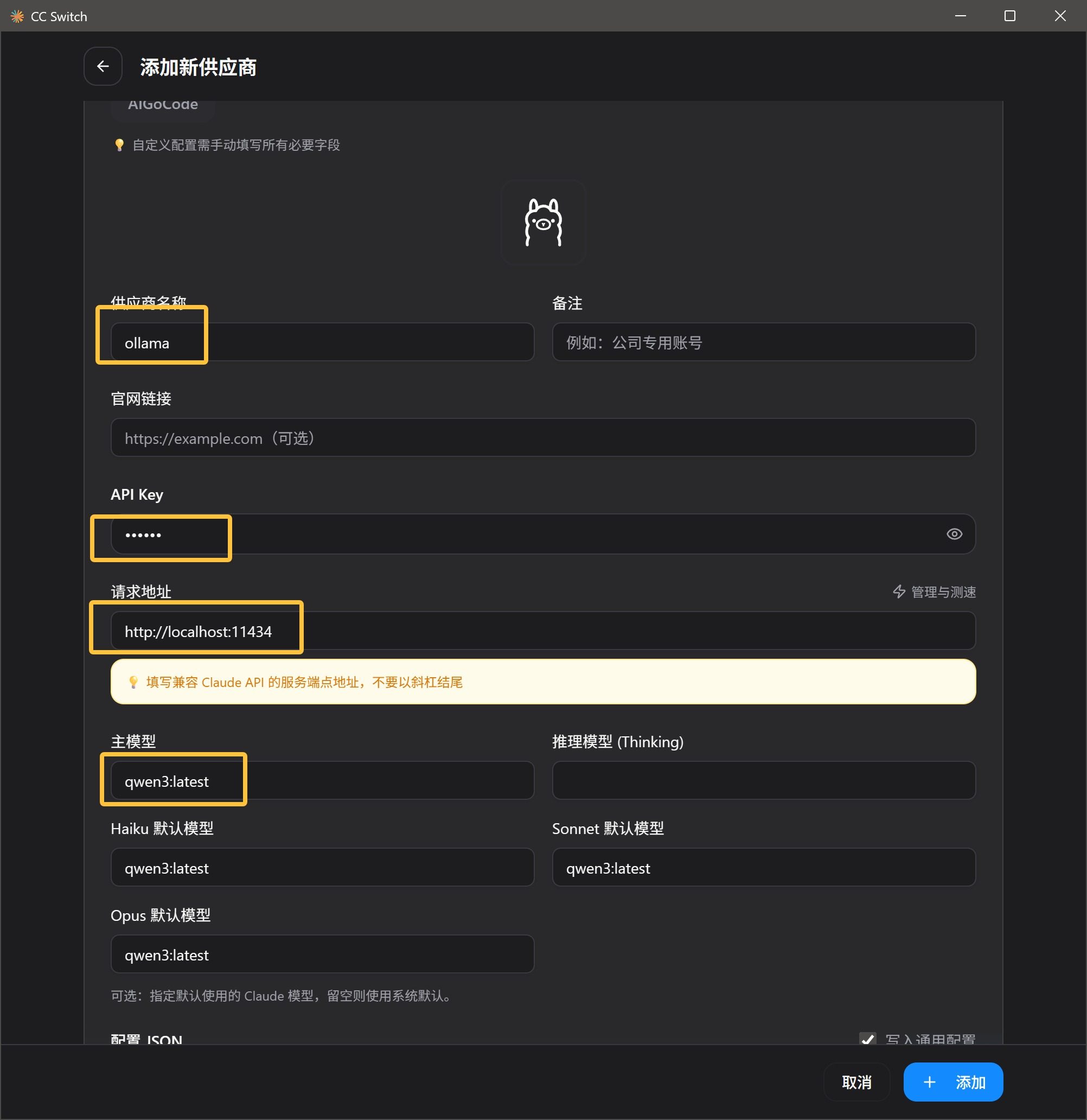

然后打开 CC-Switch 添加新供应商。

其中 API key 写:Ollama

请求地址:http://localhost:11434

然后主模型:glm-4.7-flash

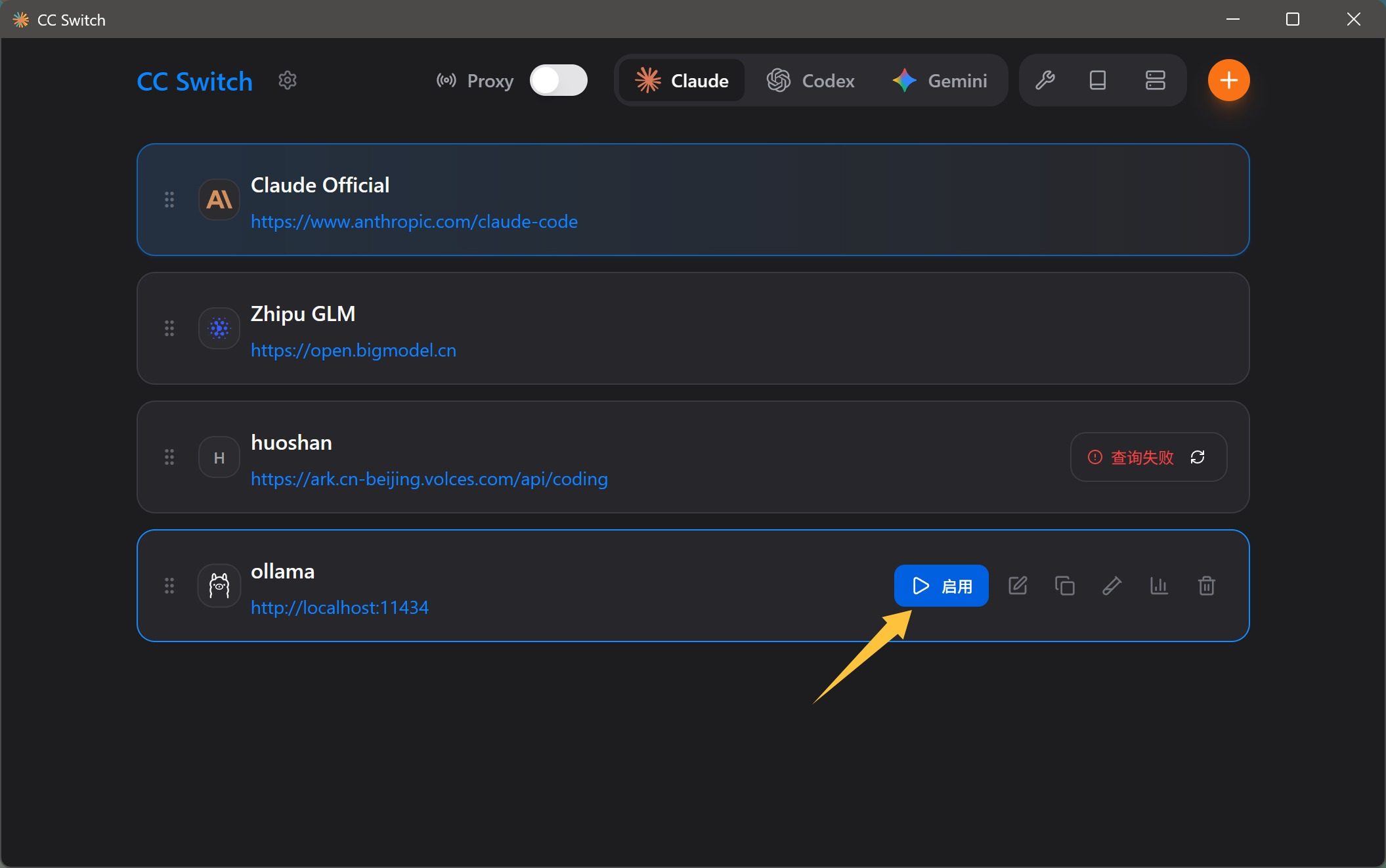

然后启用这个配置:

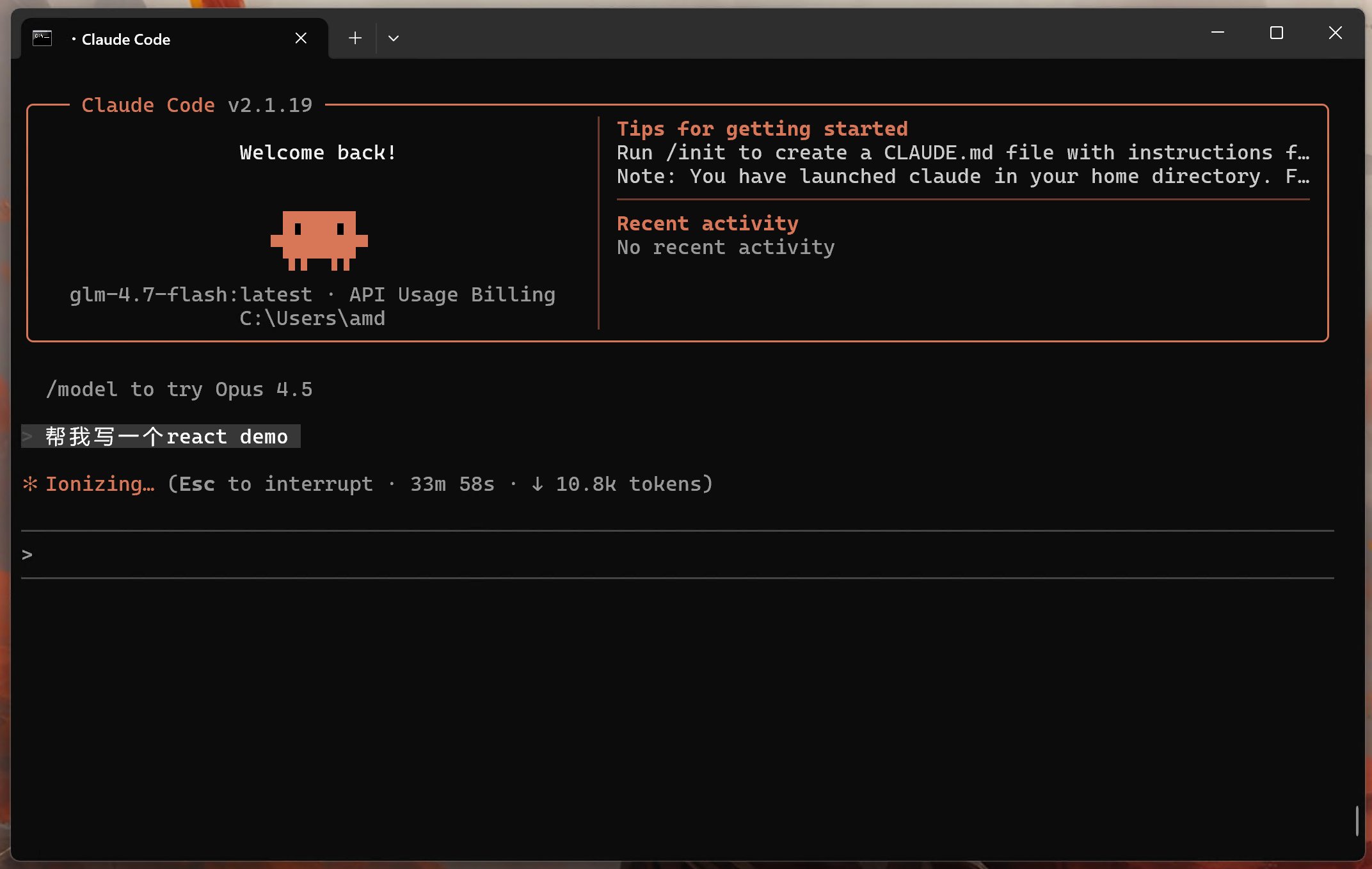

然后打开 Claude Code:

这个时候模型就切换到 glm-4.7-flash 了。

然后就可以让他干活了。

经过一番折腾,终于可以使用了。但是,最终只证明了一点:理想很美好,现实很骨感。

一个需求,思考了半个多小时,最后崩了~~我也,崩溃了!

当然,这个也是有积极意义的。

既然这条路已经跑通了,只要开源模型针对 Claude Code 优化一下,接下来就真的能玩了。

只有跑过这种模型,你才会发现 Opus 轻而易举完成那么多事情,是多么牛逼了。