全能Ollama玩转Flux2Klein和谷歌离线翻译!

几个月不见,Ollama 已经经历了好几次进化。

从原先的终端软件,到界面软件,到云端模型。

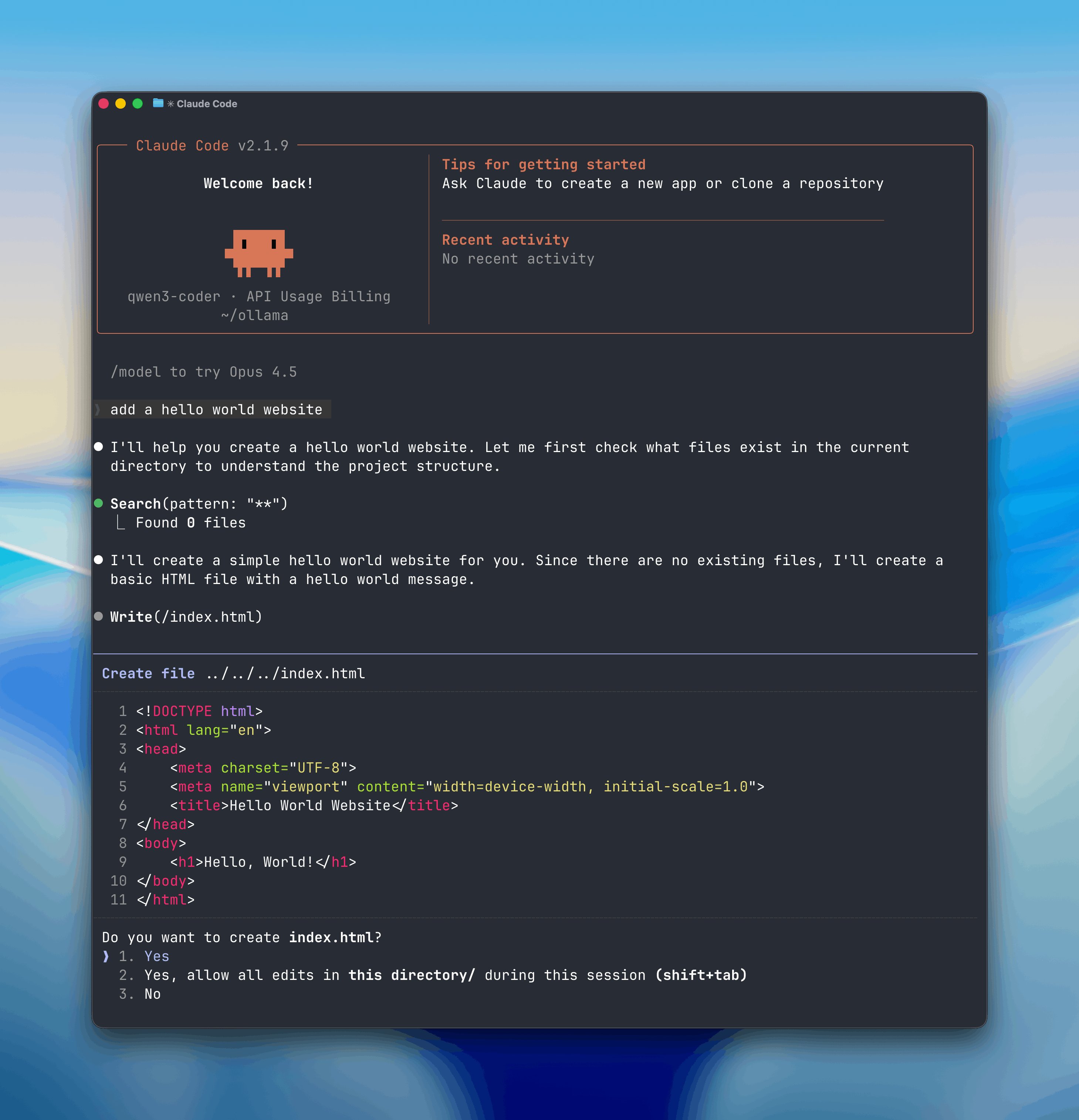

甚至可以支持接入 Claude Code、VS Code、CodeX、Cline、Droid 等软件。

现在直接可以用来画图和做专业翻译。

因为它第一时间支持了黑森林的 Flux2-klein 和谷歌的 TranslateGemma。

这两个开源模型都非常不错。

它们都有一个非常大的共同点:就是能力还不错,甚至挺不错,而且不需要高配电脑,速度又很快。

我其实在贾维斯(Jarvis)那个账号第一时间跟大家分享了这两个开源模型,但是一直没时间细聊。

今天终于有时间了,带大家一起玩一下。

直接在 Ollama 上面一次性把两个模型都跑起来,这样就不需要任何其他第三方软件了。

因为 Ollama 已经非常成熟了,所以使用起来也非常方便。它的速度很快,显存和内存管理非常优秀。

我们最早都是拿它来跑大语言模型,跑过很多模型,比如:

- 阿里云的 Qwen 3

- 深度求索 DeepSeek

- 谷歌的 Gemma

- OpenAI 的 GPT-OSS

而且 Ollama 是多平台支持的。

也就是说,只要 Ollama 支持了这个模型,你就可以在任何桌面系统上运行,包括:

- Windows

- macOS

- Linux

我今天就以 Windows 和 macOS 平台为例。

给大家完整地展示一下如何使用 Ollama 来生成图片和做专业翻译。

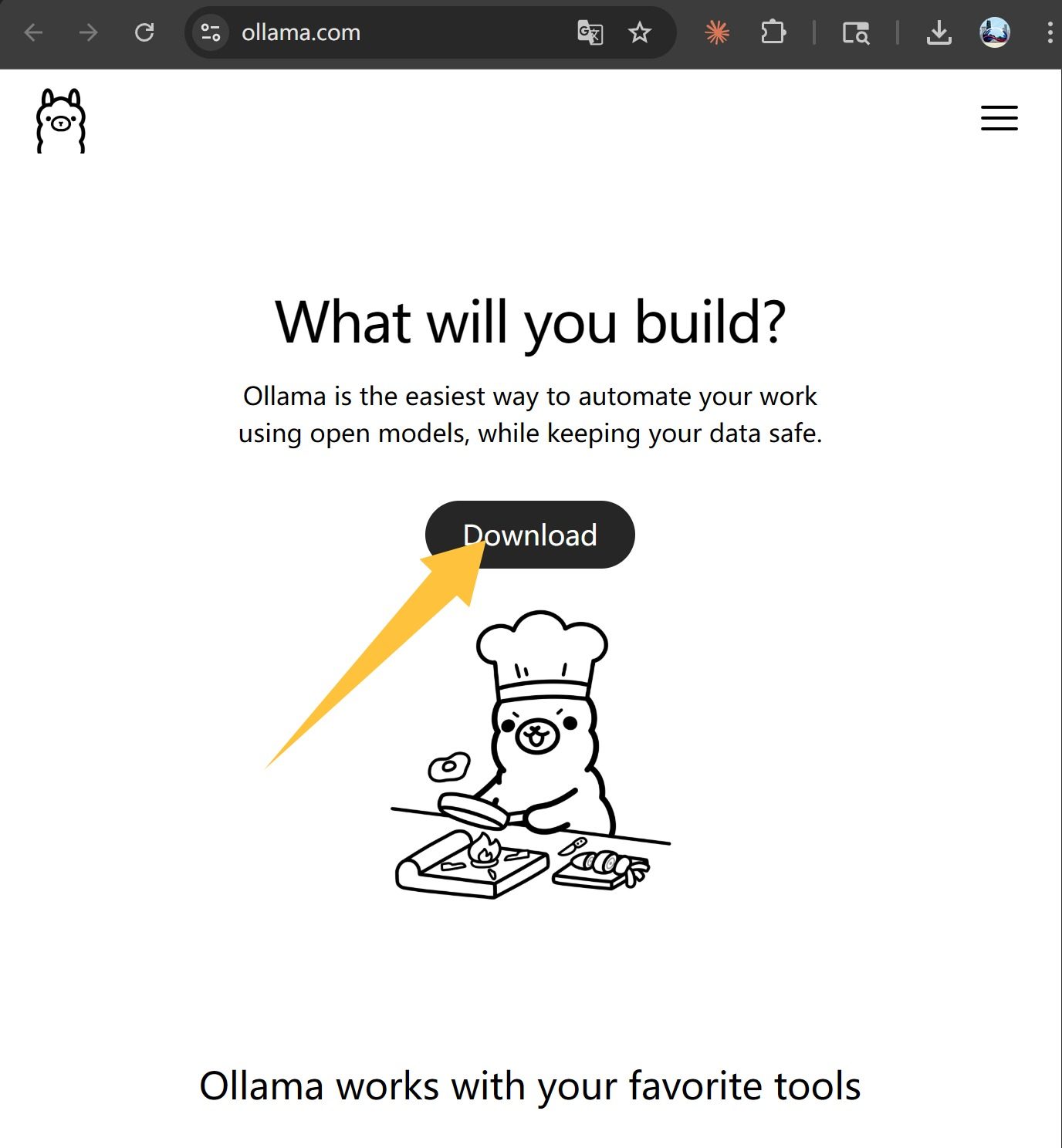

Ollama 下载和安装

工欲善其事,必先利其器。我们先把 Ollama 下载和安装一下!

Ollama 的安装非常简单,只要打开它的官网:

https://ollama.com/

然后点击页面上的 Download,等待下载完成。

因为 Ollama 现在支持的东西特别多,所以它的安装包也有一点大(大概 1 GB 多一点)。

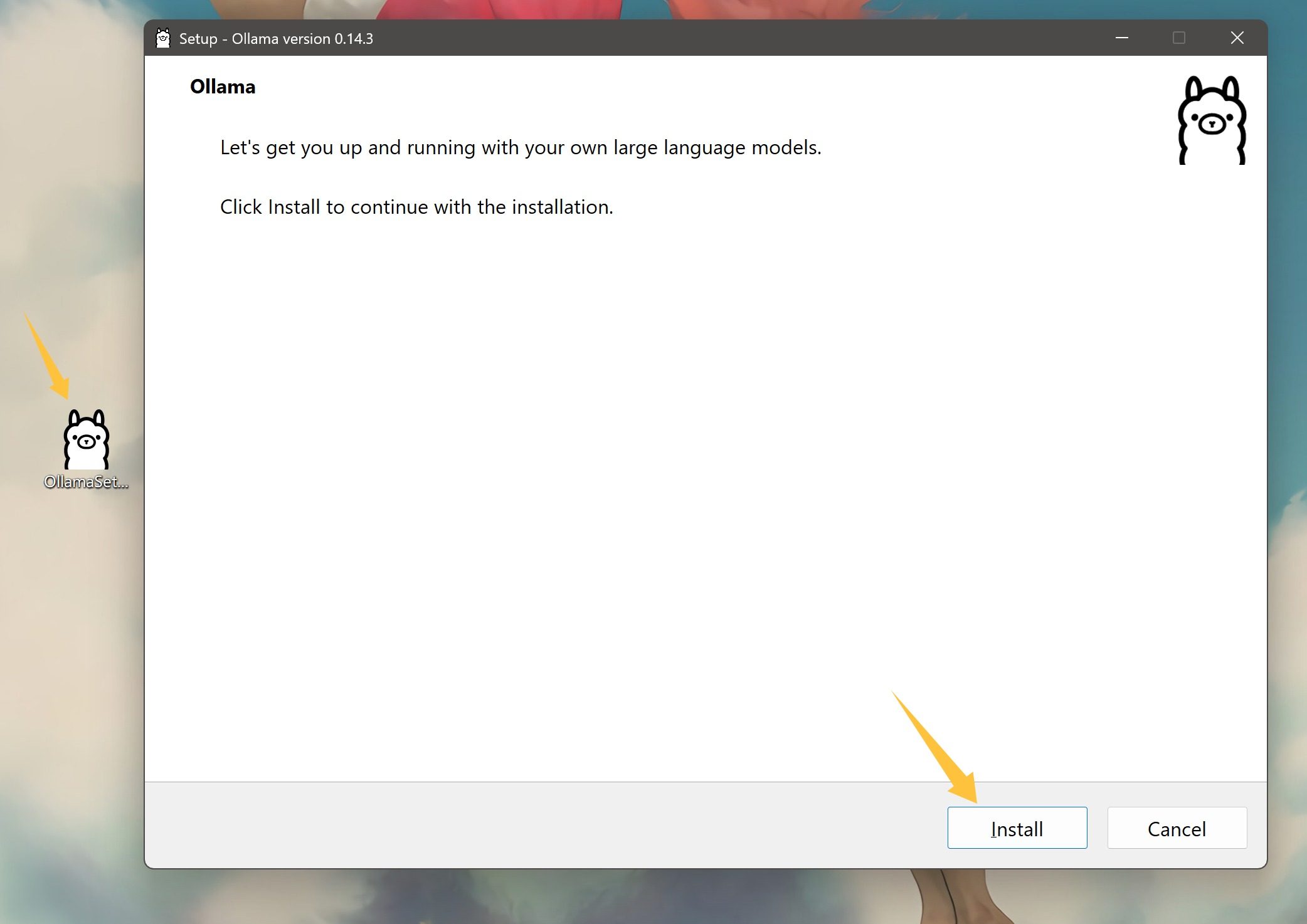

下载完成之后,会获得一个 OllamaSetup.exe。

直接双击安装:

打开之后,看一下这个版本号是否是 0.14.3。确认版本号没有问题后,点击 Install 开始安装。

为什么要强调这个版本呢?

因为有一个叫 GLM-4.7 Flash 的模型,只有在这个版本下才能运行。

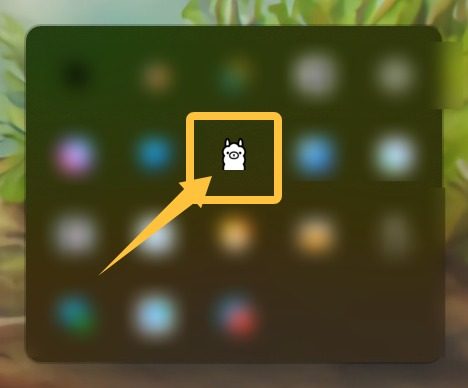

安装完成之后,在右下角的托盘里面就能找到一只小羊驼了。

直接左键单击或者右键单击就可以打开它的菜单,然后通过 OpenOllama 打开主界面。

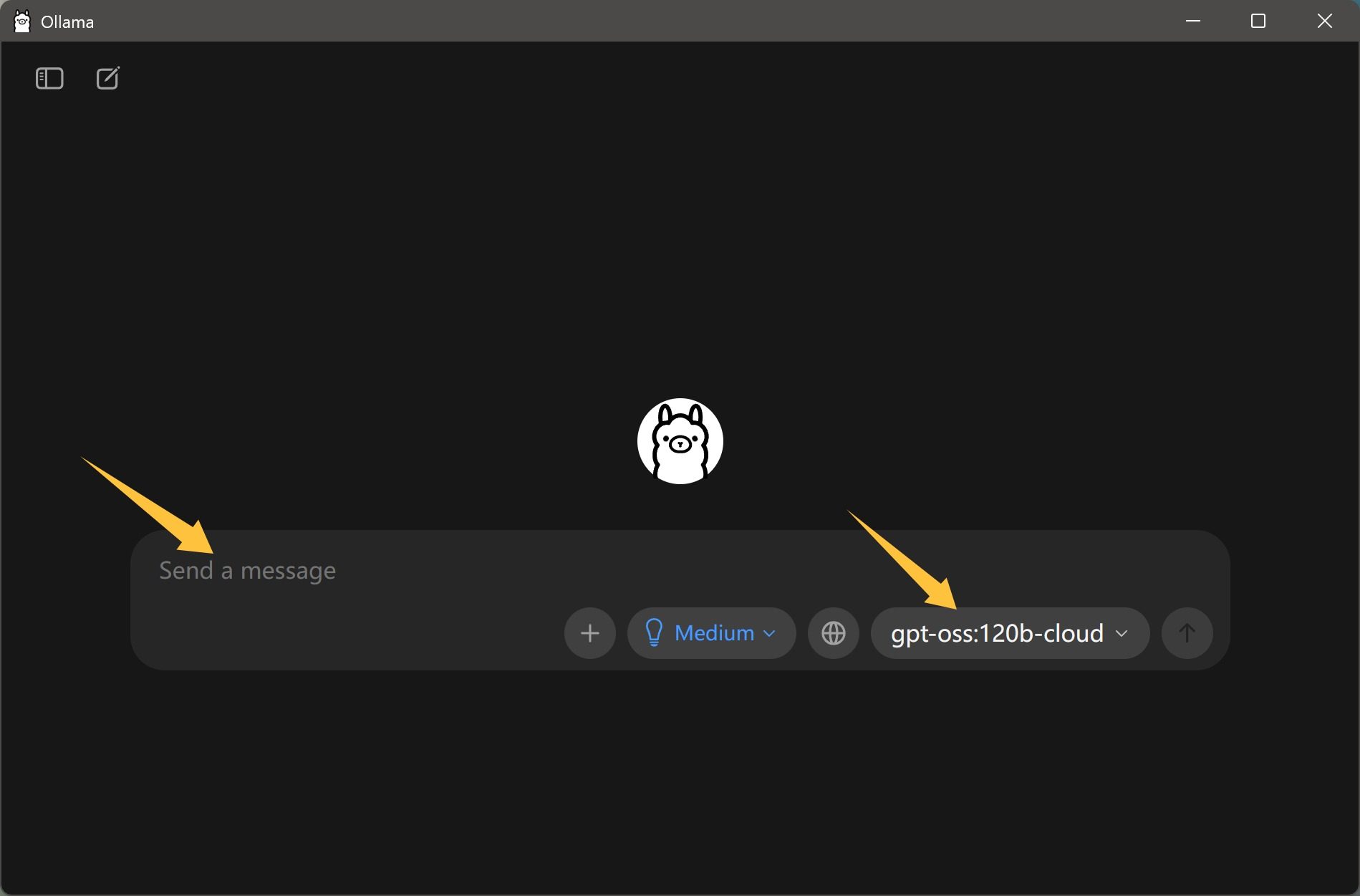

主界面非常简洁,只有一个输入框。右下角可以选择模型,在默认情况下,系统可能配置了一个云端模型。直接就可以进行聊天了!

专业翻译模型

软件装完之后,我们就可以来下载模型了。

我们先来下载谷歌开源的 Translate Gemma 模型。

这个模型支持 55 种语言,它和通用大语言模型不同。通用的模型只是会翻译,而它属于专家级别的翻译。

下载模型有两种方式:

- 通过命令行下载

- 直接在界面上输入模型名称进行下载

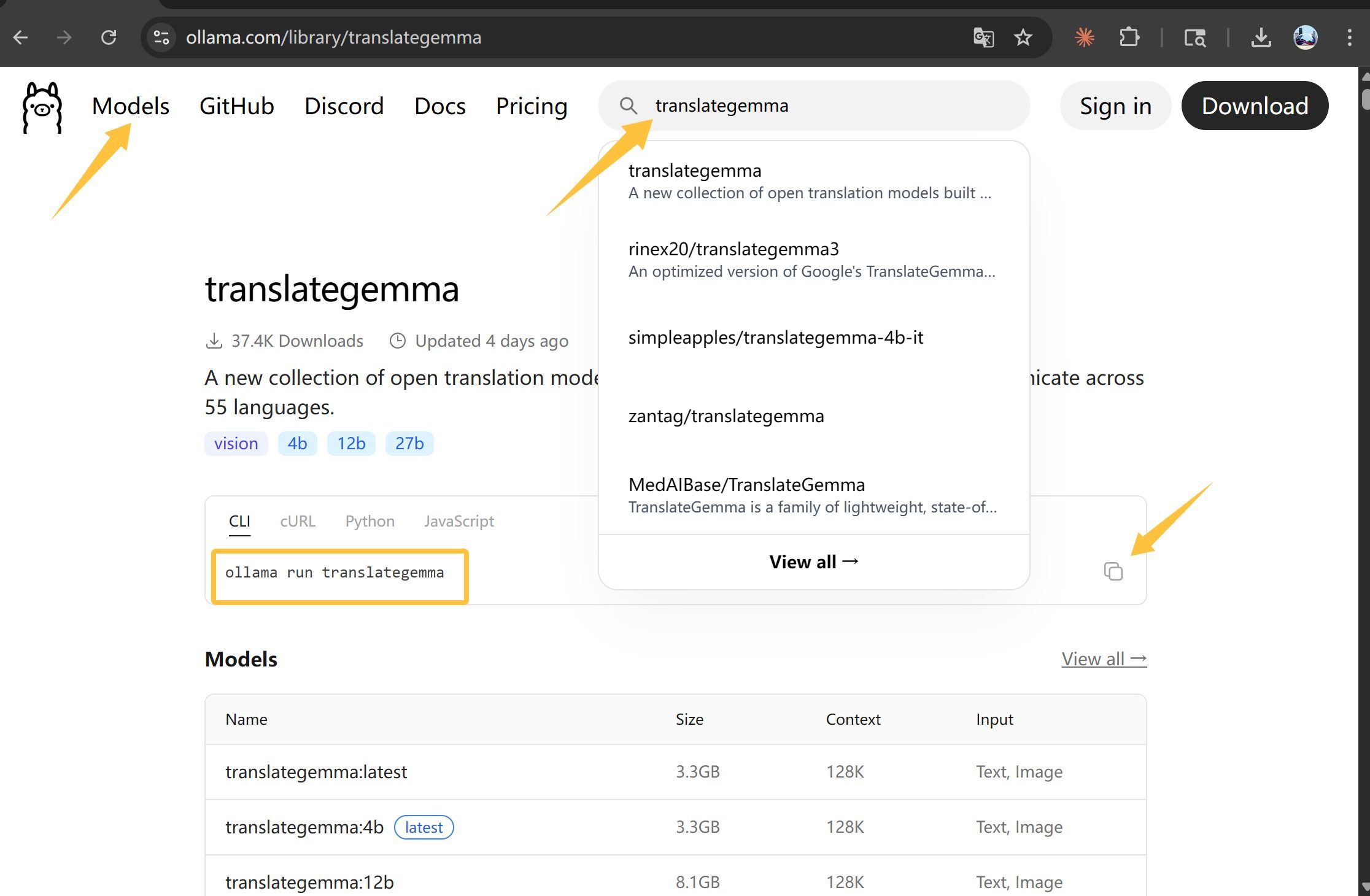

至于命令怎么写、模型叫什么,可以通过官网的模型板块来查看。

打开它的官网,然后点击 models,或者直接在中间的搜索框中输入 translategemma。

这样就可以找到这个模型的主页了。

在主页上面有一个 Ollama 的命令,你可以通过以下两种方式进行操作:

- 复制该命令,然后在本地打开终端直接输入并运行。

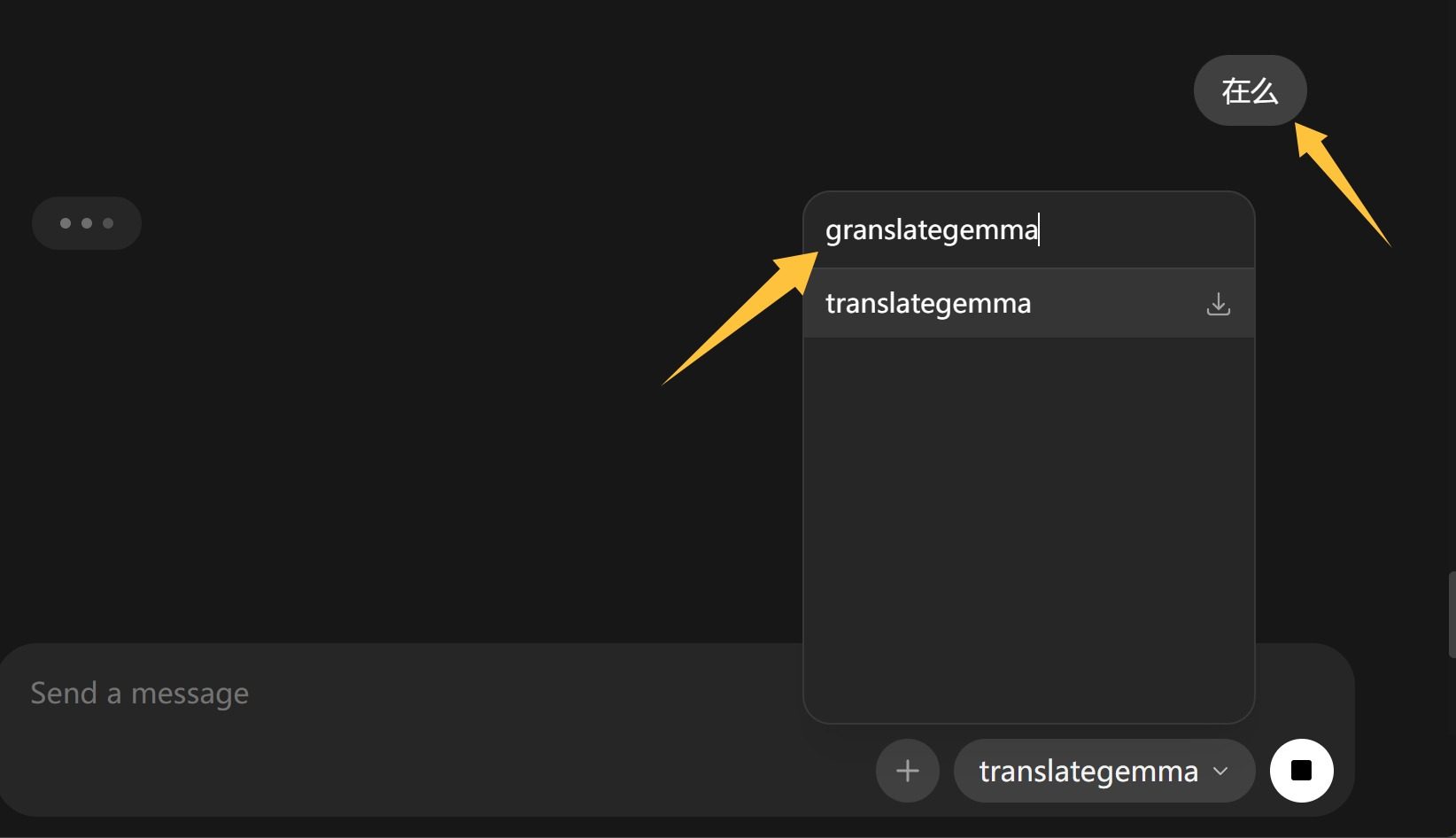

- 复制 run 后面的名字,然后在软件界面的右下角直接输入该名字。

复制这个名字粘贴并选中,然后在聊天框中随便输入一个内容,比如说“在吗?”。

然后 Ollama 就会自动下载并载入这个模型,接着回答你的问题。

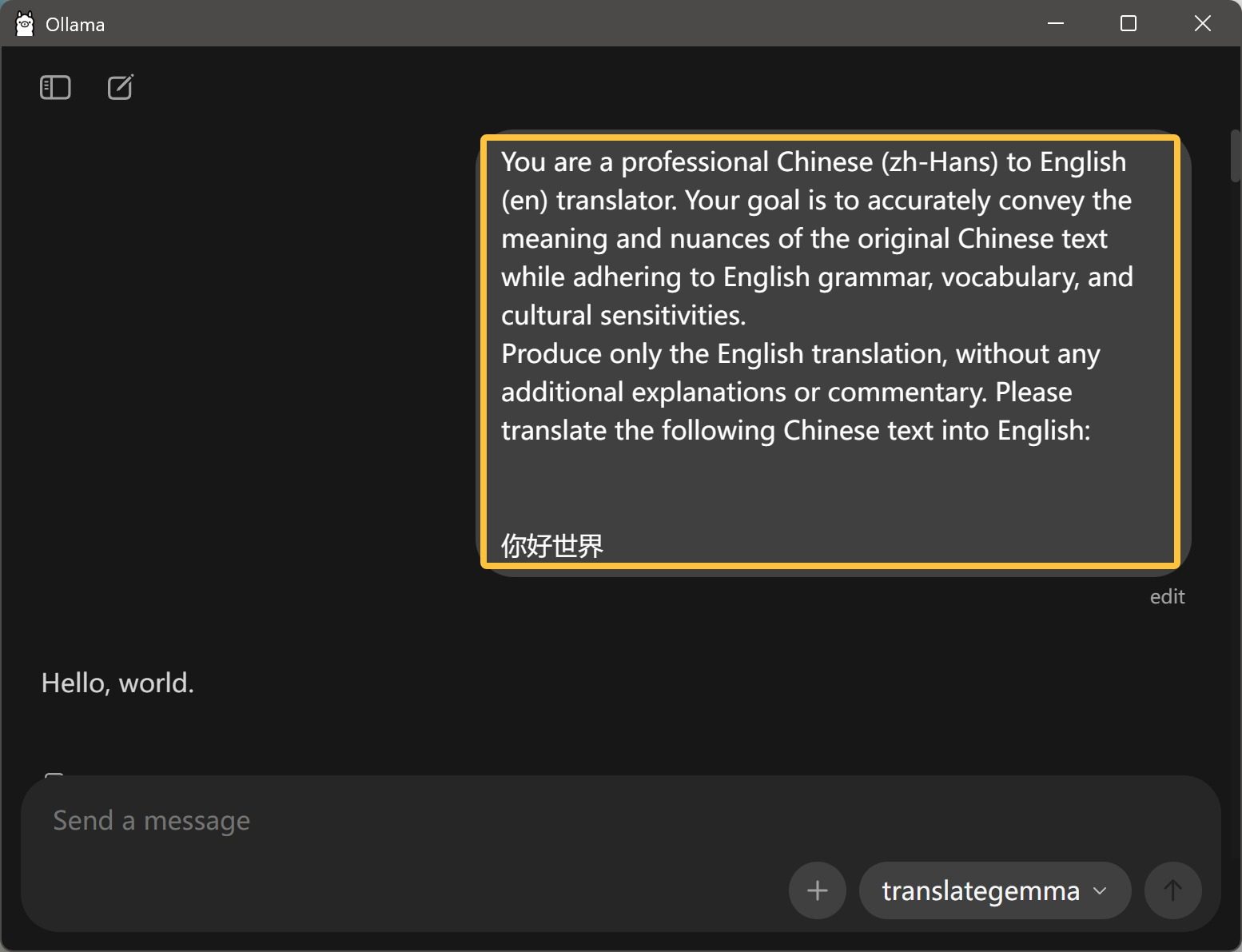

然后就直接可以让它进行翻译了:

这里需要注意输入内容的格式,第一句话最好是参考下面的格式来进行输入:

You are a professional Chinese (zh-Hans) to English (en) translator. Your goal is to accurately convey the meaning and nuances of the original Chinese text while adhering to English grammar, vocabulary, and cultural sensitivities. Produce only the English translation, without any additional explanations or commentary. Please translate the following Chinese text into English:

你好世界

这条指令输入之后,就可以进行中文到英文的翻译了。

只需要输入一次,下面直接输入你的内容就可以了。它会自动翻译,不需要再额外提醒。

在我 5060 Ti 这台电脑上,翻译速度非常快,几乎是秒出。

严格来说,可能不需要一秒,是在一秒内的。

如果你要让它把英文翻译成中文,那么就稍微改一下上面那段话,对调一下就可以了。

You are a professional English (en) to Chinese (zh-Hans) translator. Your goal is to accurately convey the meaning and nuances of the original English text while adhering to Chinese grammar, vocabulary, and cultural sensitivities. Produce only the Chinese translation, without any additional explanations or commentary. Please translate the following English text into Chinese.

Hello World

因为这是一个专业的翻译模型,所以它对指令的要求比较严格。

比如原始语言是什么、目标语言是什么,这都是有严格的类型区分的。

这个类型非常多,具体可以参考这个网址:

https://ollama.com/library/translategemma

所以对普通人来说,在 Ollama 上使用的话还是有一点点门槛,因为记不了这么长的指令,也记不住那么多语言类型的编码。

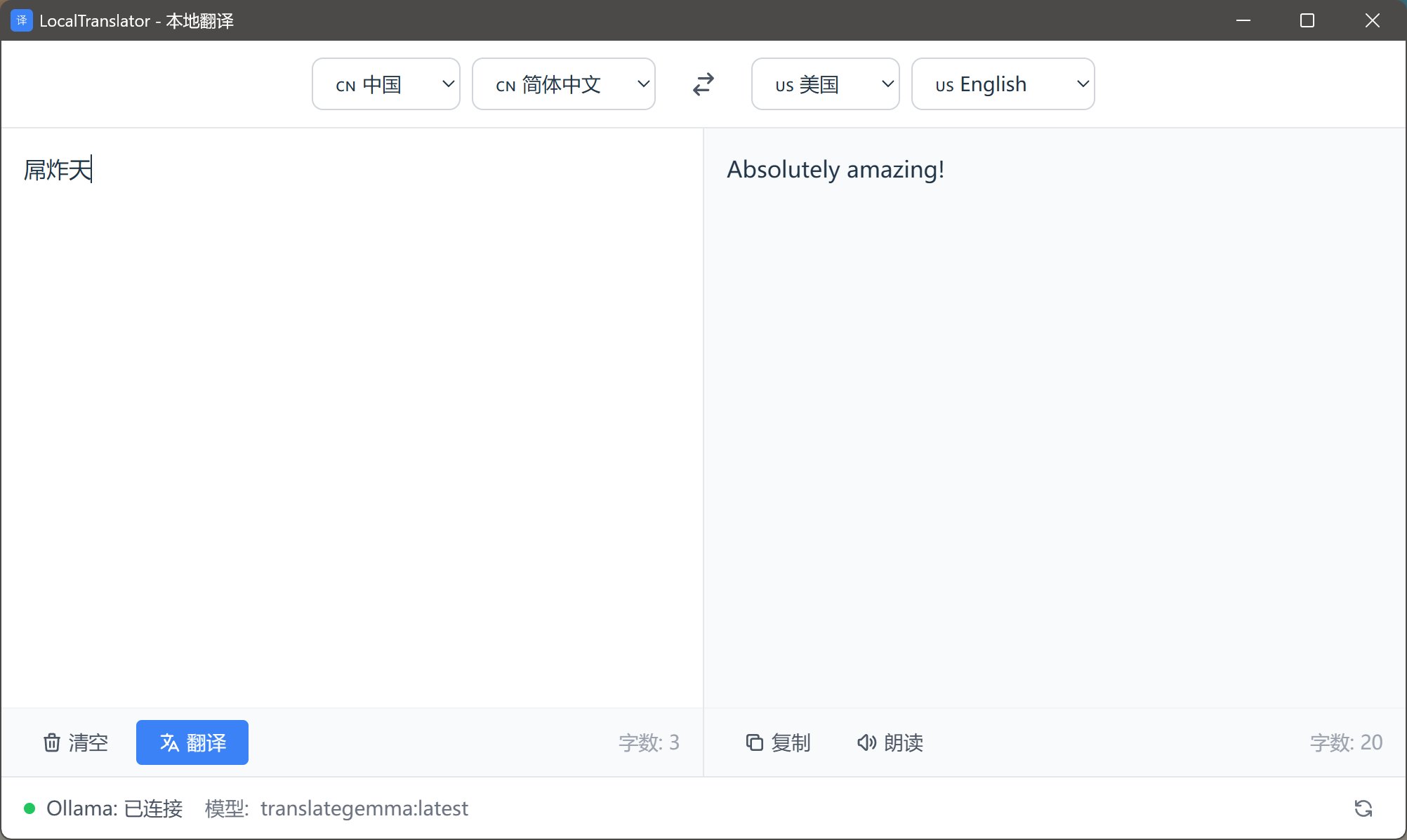

后面我会说到,我让 Opus 直接给我写了一个桌面端软件,用起来非常方便。

可以选择国家语言,然后左边输入,右边立马就会翻译出来。

你也可以进行以下操作:

- 一键清空内容

- 一键复制翻译后的内容

- 让它朗读翻译后的内容

这个软件本身大概只有 2MB 左右,非常小巧。

而且在 Windows 下打开和运行都极其高效,占用的内存和硬盘空间都极小。

我正在优化国家和语言的选项,因为涉及到的国家和语言实在太多了。

我要把这些搞清楚、理明白,这也确实很费时间。

我感觉这个软件对我来说还是挺有用的。这就相当于把一个精通 55 种语言的翻译专家,直接塞进了我的电脑里。

不管有网没网,我都能向它提问,它可以秒回。

画图模型

下面说的是语言文字相关的内容,大家可能没有那么直观的感受。接下来我们就直接上图片,直接来玩玩“一句话生成图片”那种。

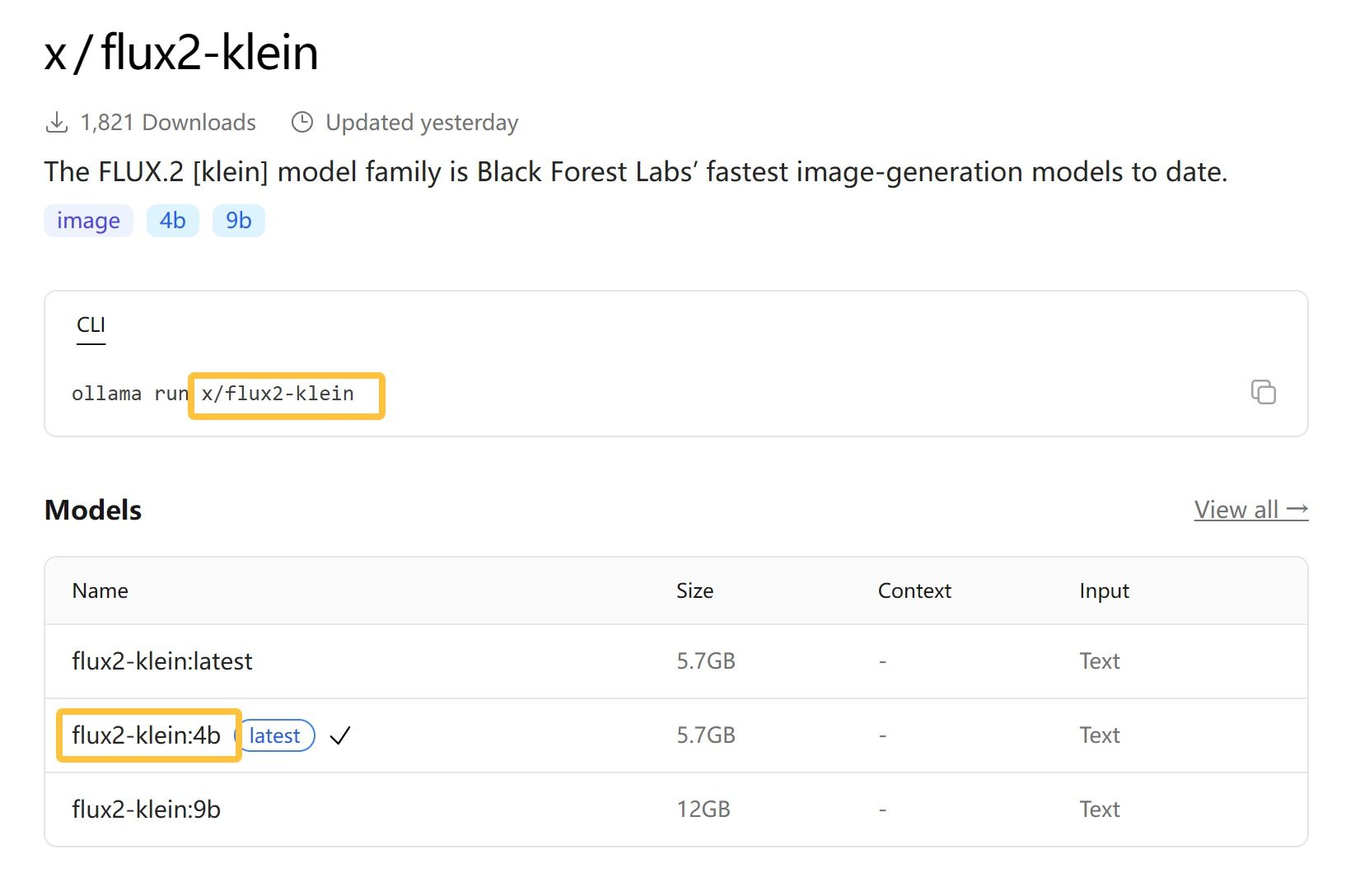

同样,我们需要先找到模型的主页,然后根据上面的提示信息下载模型。

这是黑森林最新推出的图片生成模型,同时可以生成图片和 P 图,又快又好。

模型的主页如上,从模型列表中可以看到,当前有两个模型:

- 一个 4B 的模型

- 一个 9B 的模型

那个 latest 其实就是 4B 的模型,也就是默认的模型。

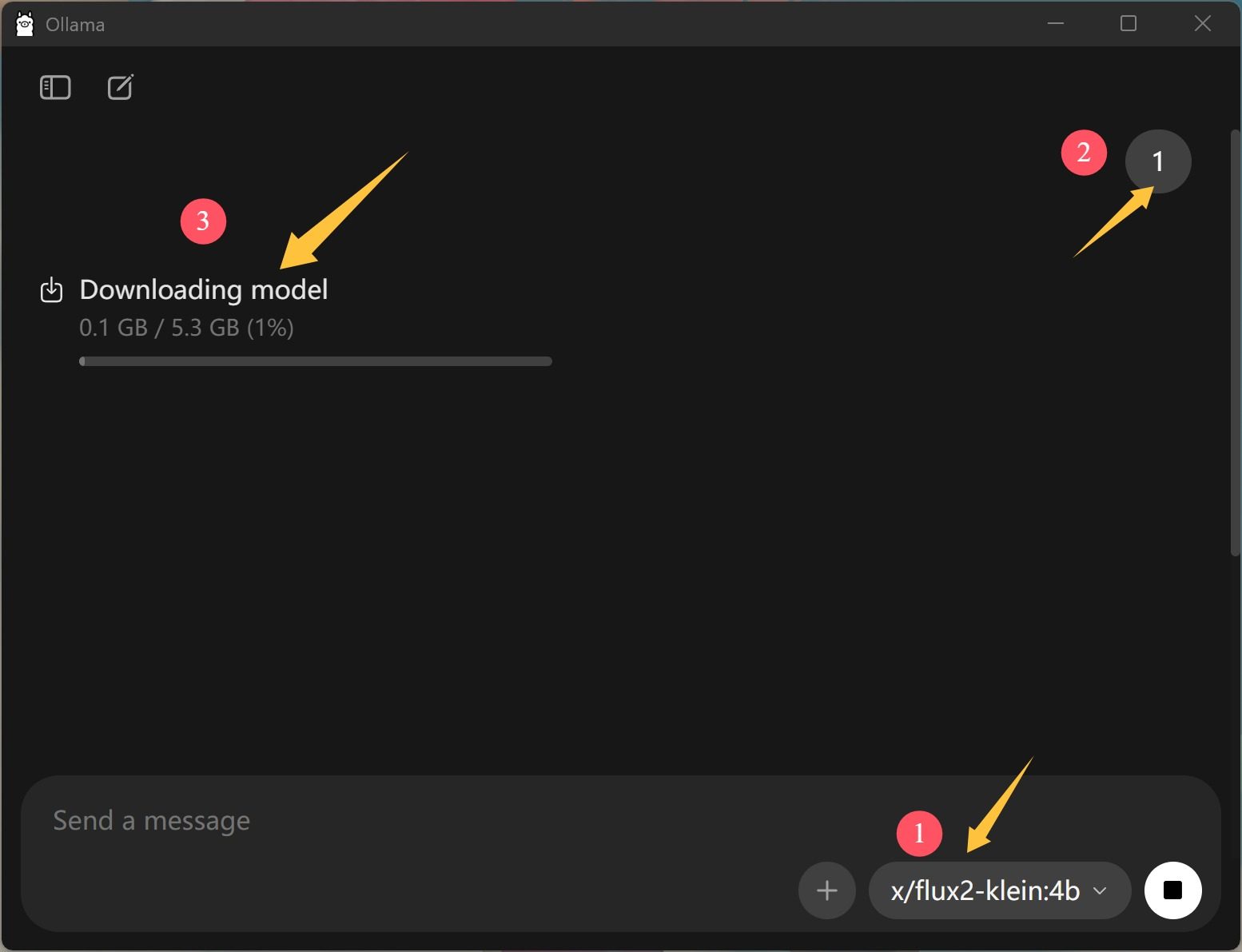

复制黄色框中的名字,然后打开 Ollama 软件。

点击右下角,展开输入这个名字。

然后随便发送一个内容,比如说 1 或者 666。

Ollama 就会自动开始下载模型。下载完成之后,它会自动载入并回答你的问题。

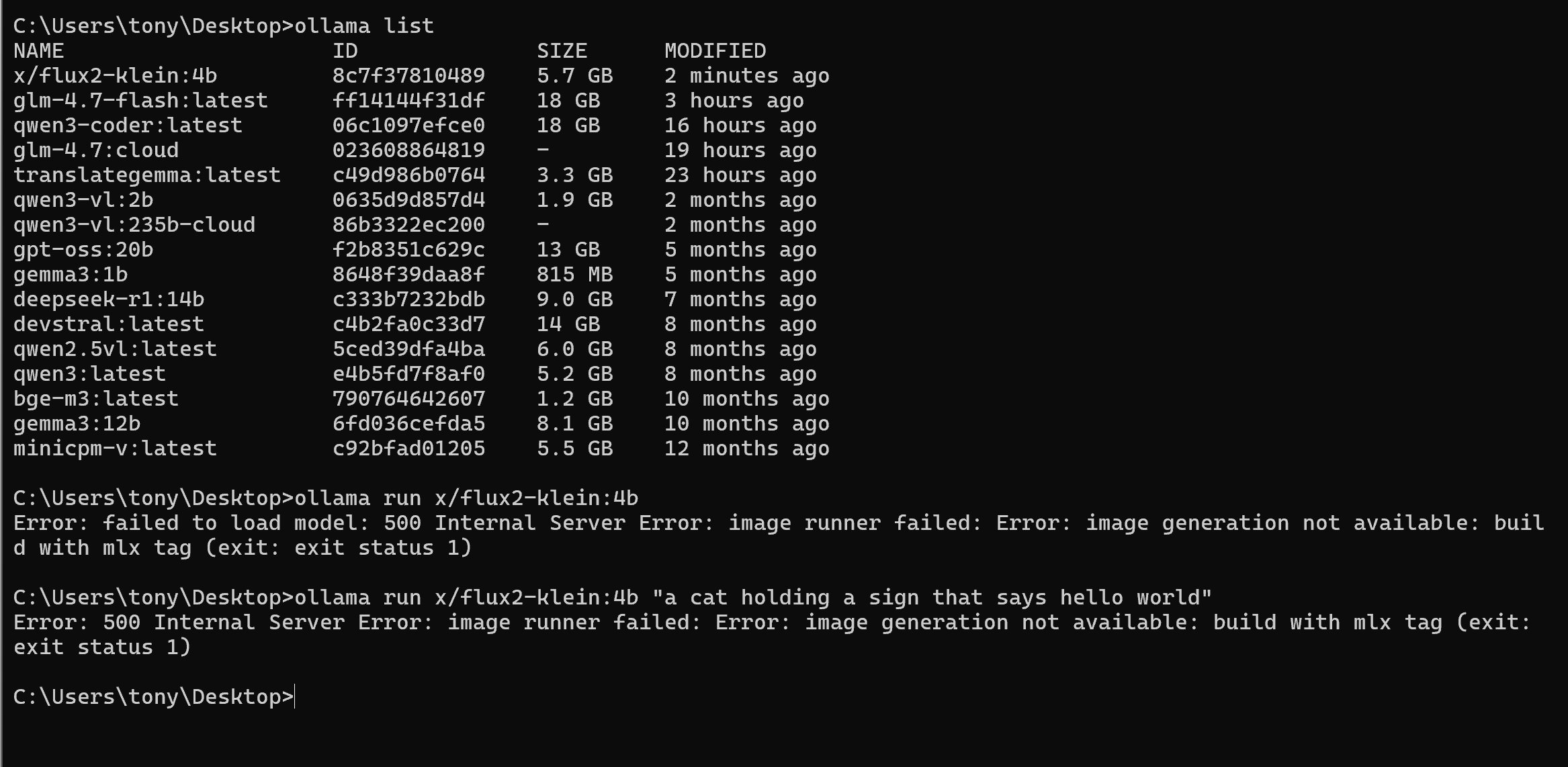

但是,实际上这一趴我遇到了一点问题。

就是加载完之后,它告诉我说:“400 Bad Request, Flux2-klein-4B does not support chat.”

我以为不能在 Chat 窗口中用,我又跑了终端命令:

没想到还是不行。

500 Internal Server Error: image runner failed: Error: image generation not available: build with mlx tag (exit: exit status 1)

这就尴尬了🥲!!!

我大概是看出门道了:他说用的是 MLX。

这不就是苹果才能用的意思吗?

看了一下它主页的介绍,确实明确说了只能在 macOS 上用。

这一刻,Windows 用户都沉默了,macOS 用户突然起立欢呼。

还好还好还好,我有一台 Mac mini。这下好了,我可以同时展示 Windows 和 Mac 平台下如何使用 Ollama 了。

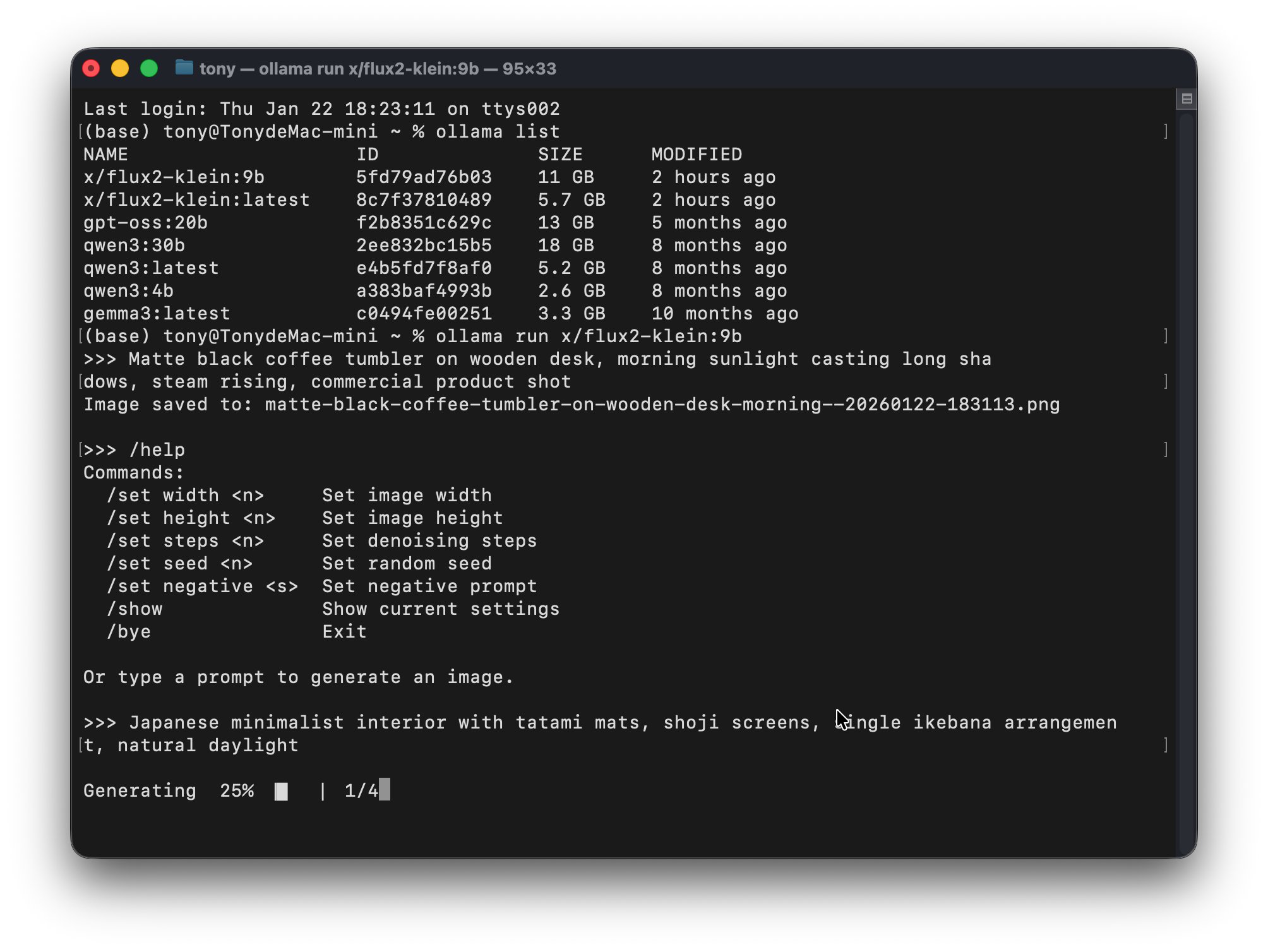

同样在 macOS 下安装一下 Ollama,然后下载一下模型。

打开系统自带的终端软件输入命令:

ollama run x/flux2-klein:9b

这条命令的作用是运行 Klein 9B 这个模型,如果没有就会先下载,如果有了,就会直接启动。

启动成功之后,只要输入提示词即可:

提示词:

Japanese minimalist interior with tatami mats, shoji screens, single ikebana arrangement, natural daylight

生成的图片:

最后生成的文件会自动保存在用户目录下面。

生成的图像默认为方形 1:1。

如果你要其他比例,可以使用 /set 命令,先设置长宽,然后再生成。

macOS 下运行速度也还可以,但是我的 mini 自带硬盘才 512 GB 伤不起,内存硬盘全爆了!

模型搬家

最后说一点实用的设置。

因为这些开源模型占据的存储空间都比较大,而 Ollama 默认是放在 C 盘的,所以可能会把你的 C 盘撑爆。

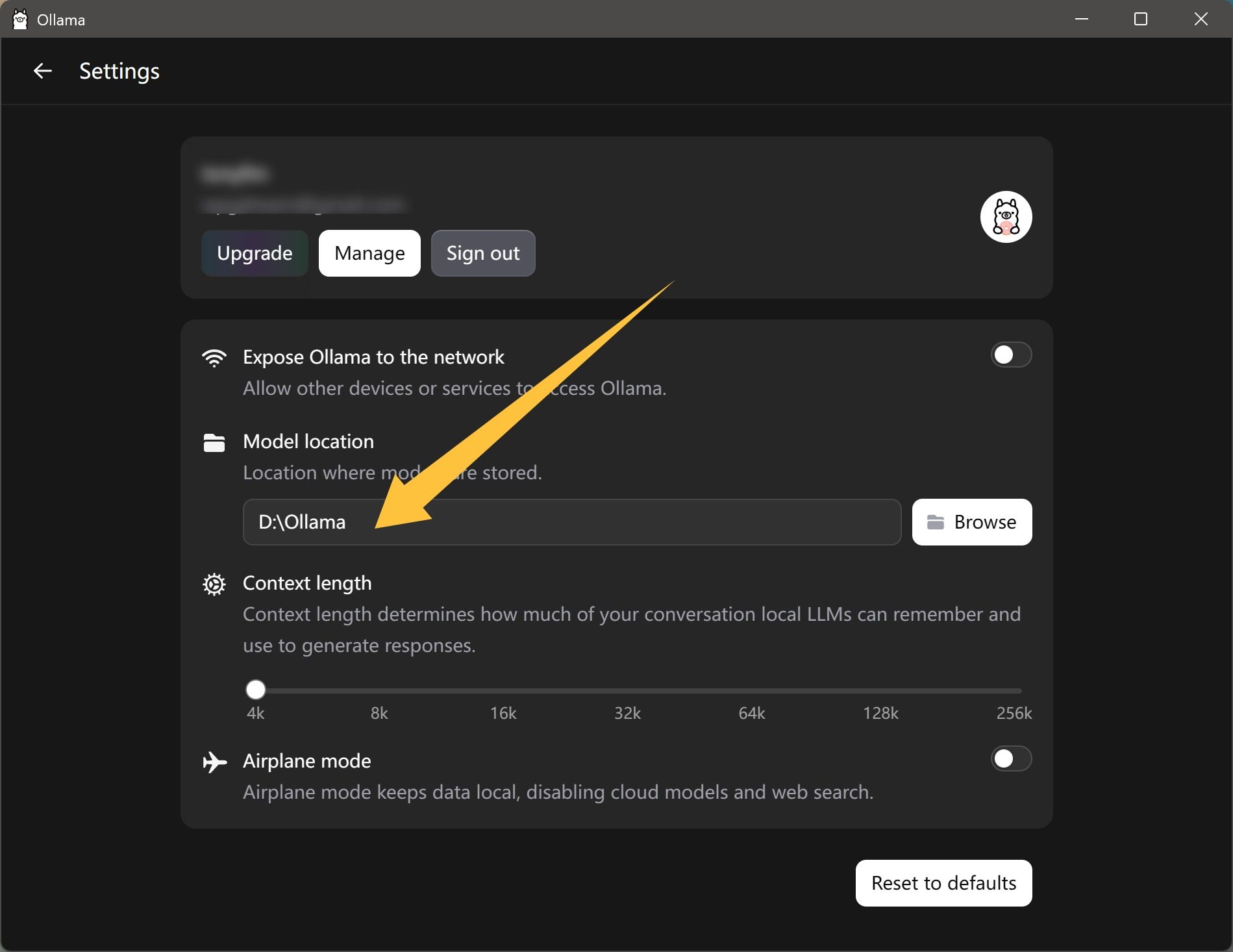

这时候可以用它的设置功能切换模型的路径。

只要在界面左边找到 Settings 打开,然后找到 Model Location,点击后面的 Browse 浏览,选中一个文件夹就好了。

搬家还涉及到一个问题。

这里只是修改路径,但是并不会自动迁移模型。所以需要手动复制。

为此,我在去年 8 月的时候还写过一个搬家工具。

这个工具可以:

- 自动识别 Ollama 的默认模型路径。

- 可以批量搬家,也可以指定模型搬家。

只要选择好模型,选择好目标路径,点击一键搬家就可以了。

对我来说,可以勾选模型这个特别有用。因为有些电脑无法连外网,但是需要运行大模型。所以我可以先在一台电脑下载,然后搬家就行了。

因为 Ollama 的模型存储结构比较特殊,手动找到模型文件非常困难。

经过 2025 年的发展,现在的 AI 真的是快到奇点了。(AI 单一技能>=人类单一技能)

打字有豆包输入法、Typeless。直接自然语言输入,准确率又高,速度又快。

P 图啊、设计啊,有 Banana、SeaDream 这种。

写代码,有 Claude Code 和 CodeX 这种。

做视频,有可灵、VEO、Sora 这种。

做音乐,有 Suno V5 这种。

在我们的网络生活中,AI 已经无处不在了。

最最关键的是,很多用 AI 生成的内容,作为普通人已经无法分辨了。

这相当于说,在某些领域,它的图灵测试其实已经完备了。

接下来 AI 会从创作领域不断渗透到各种生活领域和工业领域,这是一个持续落地的过程。

很显然,会变得越来越简单,越来越完善。

我不得不问:那我干嘛去呢?haha~~

往好的方面看,接下来应该会有很多东西可以玩的。

因为大模型对硬件设备的要求越来越低,能力越来越强,变得越来越有用啊!

如果大家下载软件和模型有困难,也可以用我下好的,放网盘了。

给公众号发关键词“Ollama”即可!

收工收工!!