Ollama雄起!一个命令运行CC、codex、opencode

Ollama 这小羊驼,野心不小,一口气把终端编程智能体给包圆了。

昨天分享了通过脚本和第三方配置来接入 Claude Code 和 GLM-4.7-flash。

今天来看看官方的命令,超级简单。

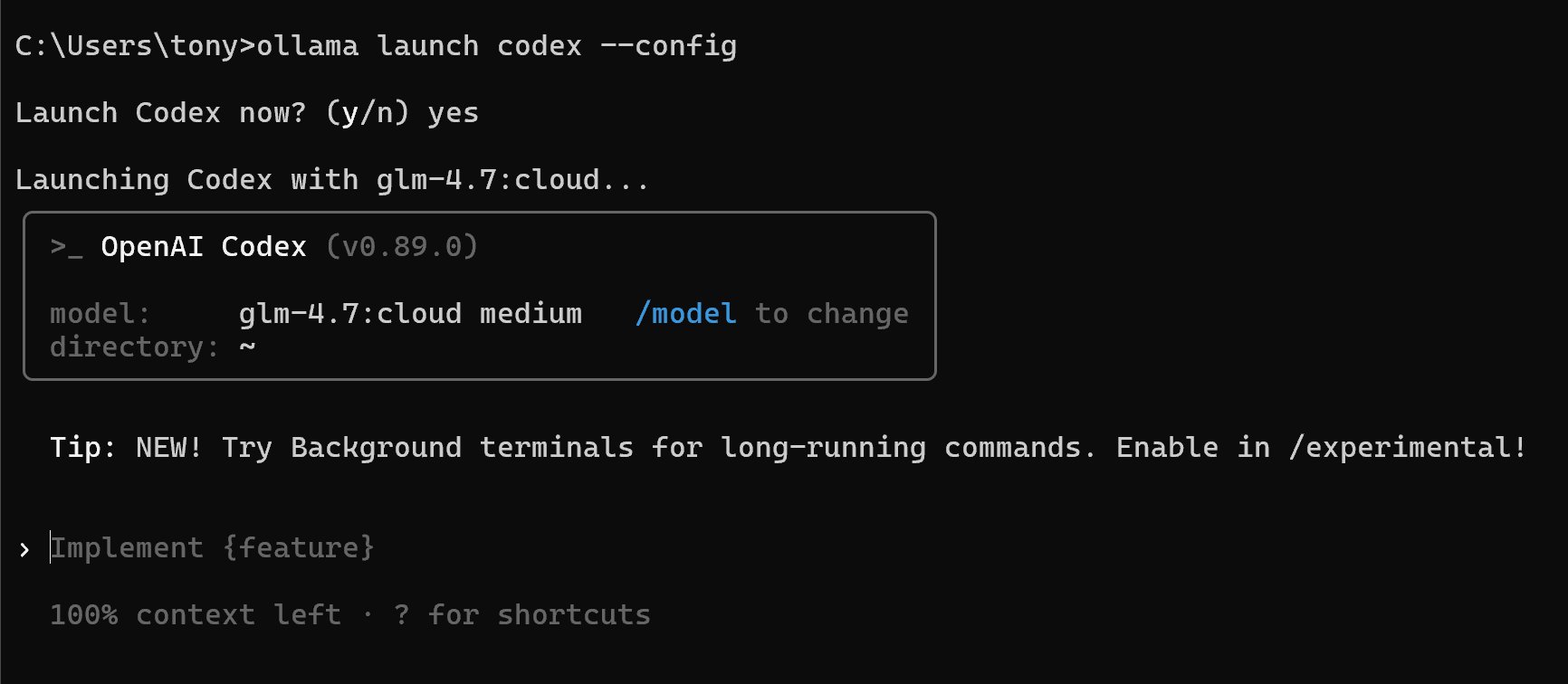

先用接入 Codex 来演示一下。

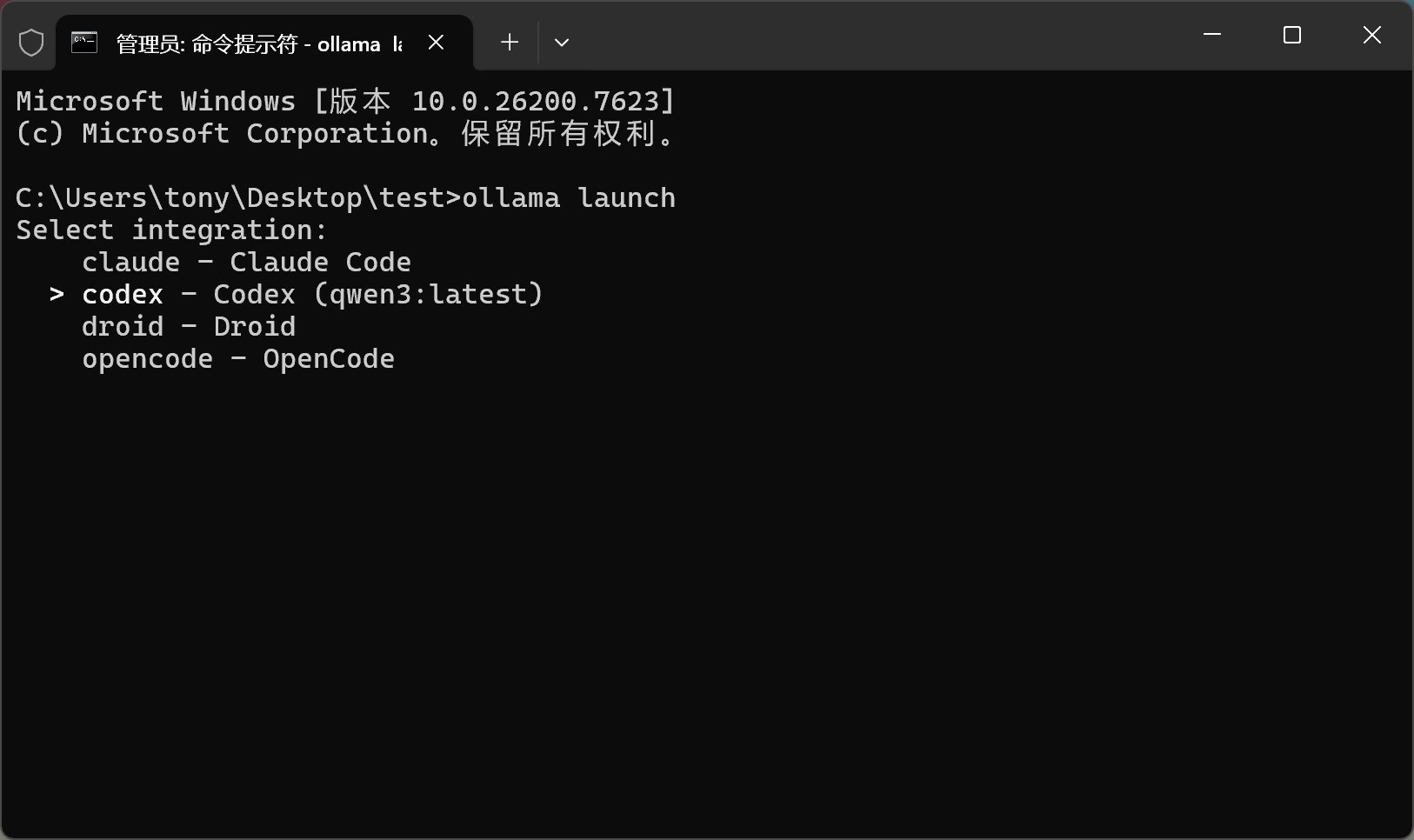

直接打开 CMD 或者 PowerShell。

输入命令 ollama launch:

然后就可以看到是个候选列表,里面包含了 Claude、Codex、Droid、OpenCode 等。

通过上下箭头直接选择一个,比如说 Codex。

选择完之后就会有一个模型列表供你选择。

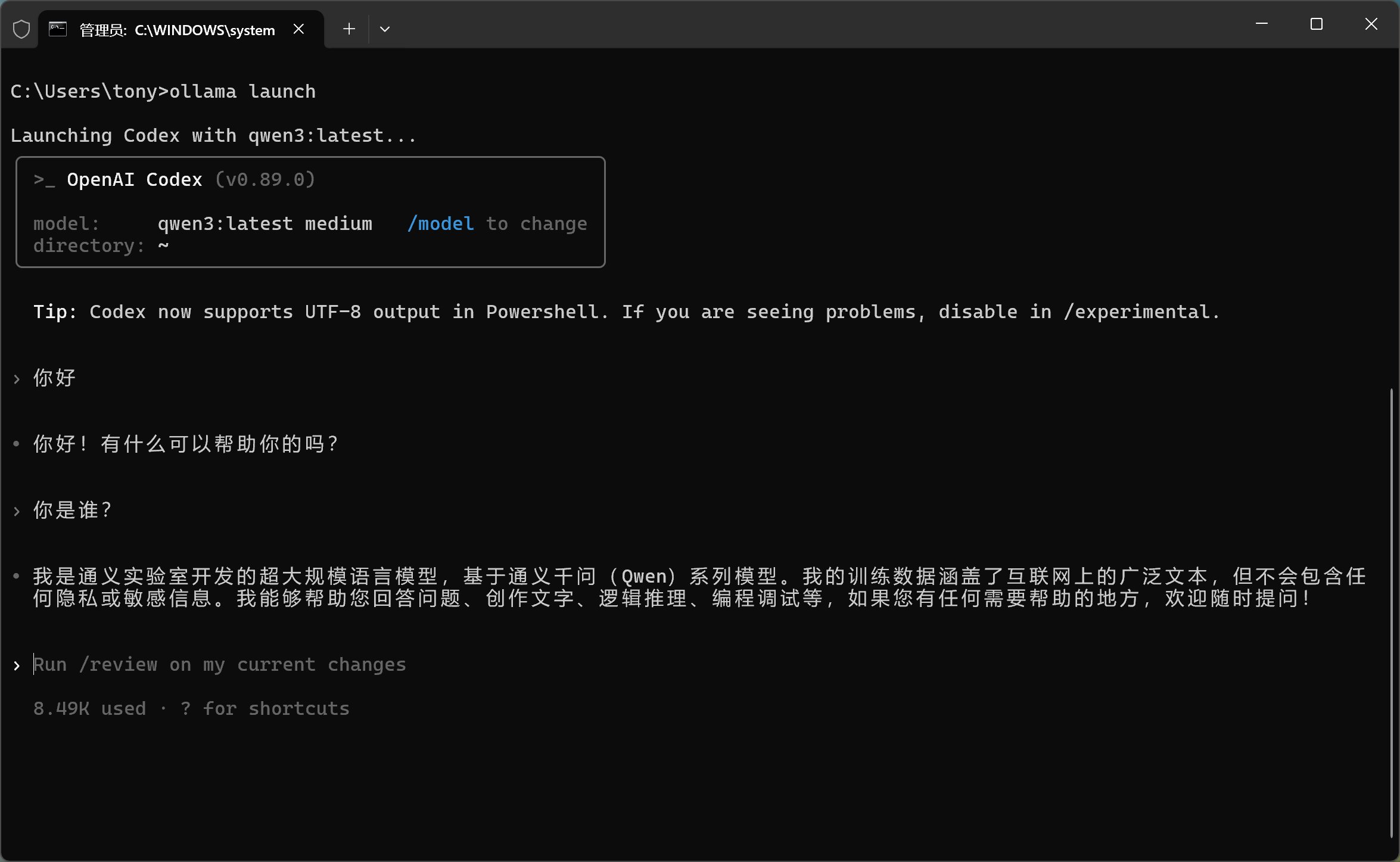

然后你选择具体的模型,就可以进入 Codex。

我选了 Qwen3,一个 5G 多的模型,一般电脑上都能跑。

进来之后可以确认一下它是不是正确载入了。

从对话中可以看到,已经正确载入千问模型。

但是现在一般的开源模型,对智能体工具调用的支持都不是太好。

所以聊天可以很丝滑,但是工具调不起来,现在还有点鸡肋。

Ollama 现在通过一个 launch 命令全面接入了各种终端编程智能体。

下面介绍一下这个命令的格式:

C:\Users\tony\Desktop\test>ollama launch -hLaunch an integration configured with Ollama models.Supported integrations: claude Claude Code codex Codex droid Droid opencode OpenCodeExamples: ollama launch ollama launch claude ollama launch claude --model <model> ollama launch droid --config (does not auto-launch)Usage: ollama launch [INTEGRATION] [flags]Flags: --config Configure without launching -h, --help help for launch --model string Model to use

官方的命令帮助中举了4个例子。

关于 Launch 的使用方式,主要有以下三种:

- 使用 Launch 不带任何参数

- 使用 Launch 后面直接跟智能体的名字

- 使用 Launch 后面跟上智能体的名字及模型的名字

- 使用 Launch 后面跟上智能体的链接,再跟上配置

第一种方式上面就演示过。

下面用启动 droid 演示下第二种方式:

C:\Users\tony\Desktop\test>ollama launch droidSelect models for Droid: > [ ] bge-m3:latest [ ] deepseek-r1:14b [ ] devstral:latest [ ] gemma3:12b [ ] gemma3:1b [ ] glm-4.7:cloud [ ] gpt-oss:20b [ ] minicpm-v:latest [ ] qwen2.5vl:latest [ ] qwen3-vl:235b-cloud ... and 4 more Select at least one model.

这个命令就比第一种方式更进一步,直接选模型了。选完之后,按一下 Tab 键,然后 Continue,就进入对应的智能体。

这里要注意:终端智能体(CodingAgent)是需要自己先装好的。

因为我没装这个工具,所以系统会提示我没有安装,请先到指定位置下载安装。

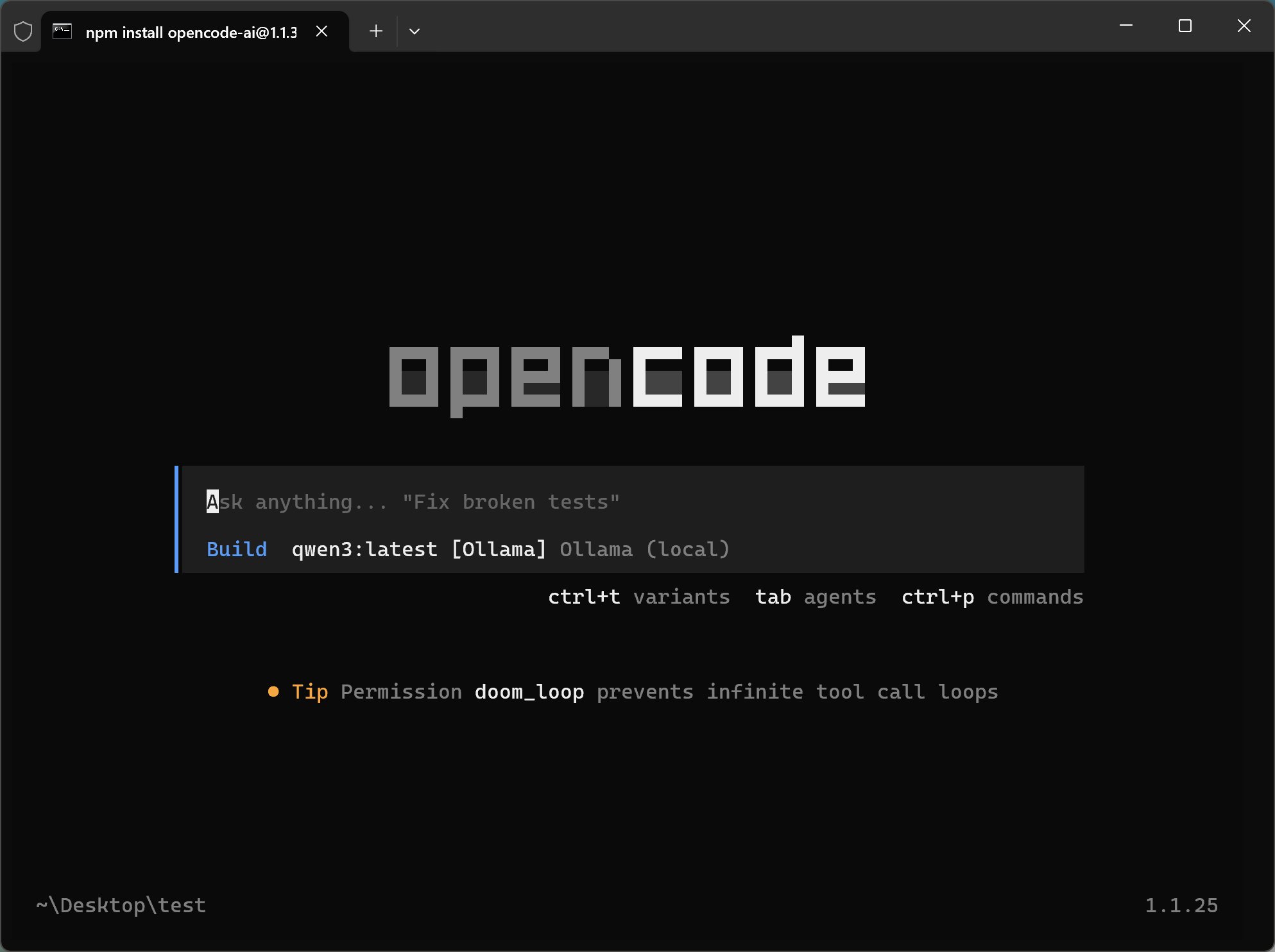

下面用 OpenCode 演示一下第三种方式:

ollama launch opencode --model qwen3:latestThis will modify your OpenCode configuration: C:\Users\tony\.config\opencode\opencode.json C:\Users\tony\.local\state\opencode\model.jsonBackups will be saved to C:\Users\tony\AppData\Local\Temp\ollama-backups/Proceed? (y/n)

在这种方式中,我指定了智能体,也指定了模型。也就是说,一个命令可以直接进入第三方的智能体。

这里提示会覆盖原先的配置文件,需要注意一下。

如果你同意,就直接输入 yes 并回车。

然后就会进入 OpenCode 的界面:

然后直接就可以进行对话了,相当丝滑。

最后看一下第四个命令:

C:\Users\tony>ollama launch codex --configSelect model for Codex: > qwen3:latest bge-m3:latest deepseek-r1:14b devstral:latest gemma3:12b gemma3:1b glm-4.7:cloud gpt-oss:20b minicpm-v:latest qwen2.5vl:latest ... and 4 more

这个命令输入之后,它就会让你选择具体的模型。

因为按之前直接运行的方式,一旦你 launch codex,它就会自动调用 Qwen3 这个模型。

所以这个命令非常有必要了,它可以让你重新配置智能体对应的模型。

然后我在这里切换了一个 glm-4.7 cloud medium 的模型。

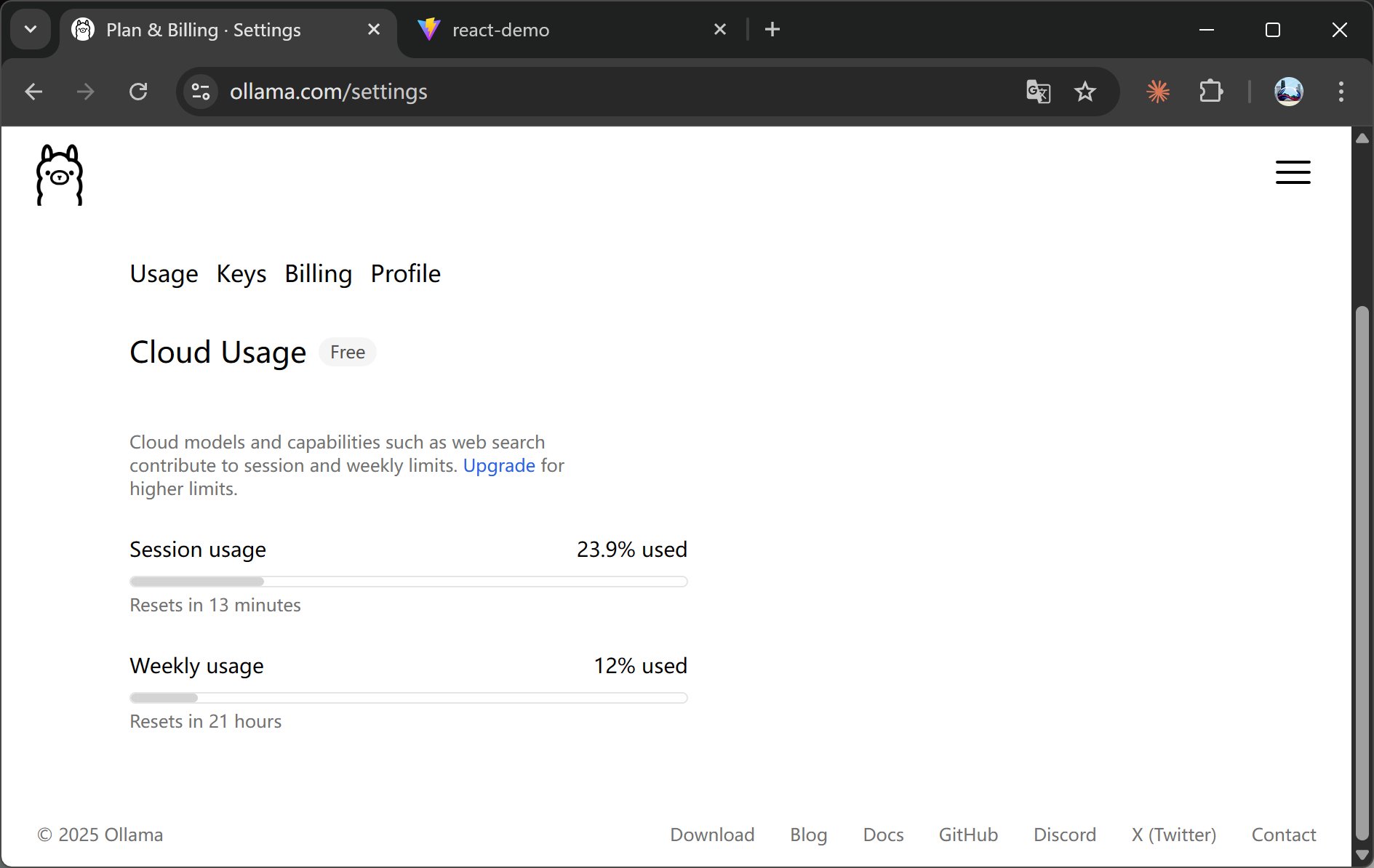

这是一个云端模型,Ollama 现在是支持云端模型的,而且有免费的配额。

因为开源模型基本上对工具调用支持都不是太好,切换到这个 GLM-4.7 之后,你就能正常调用工具了。

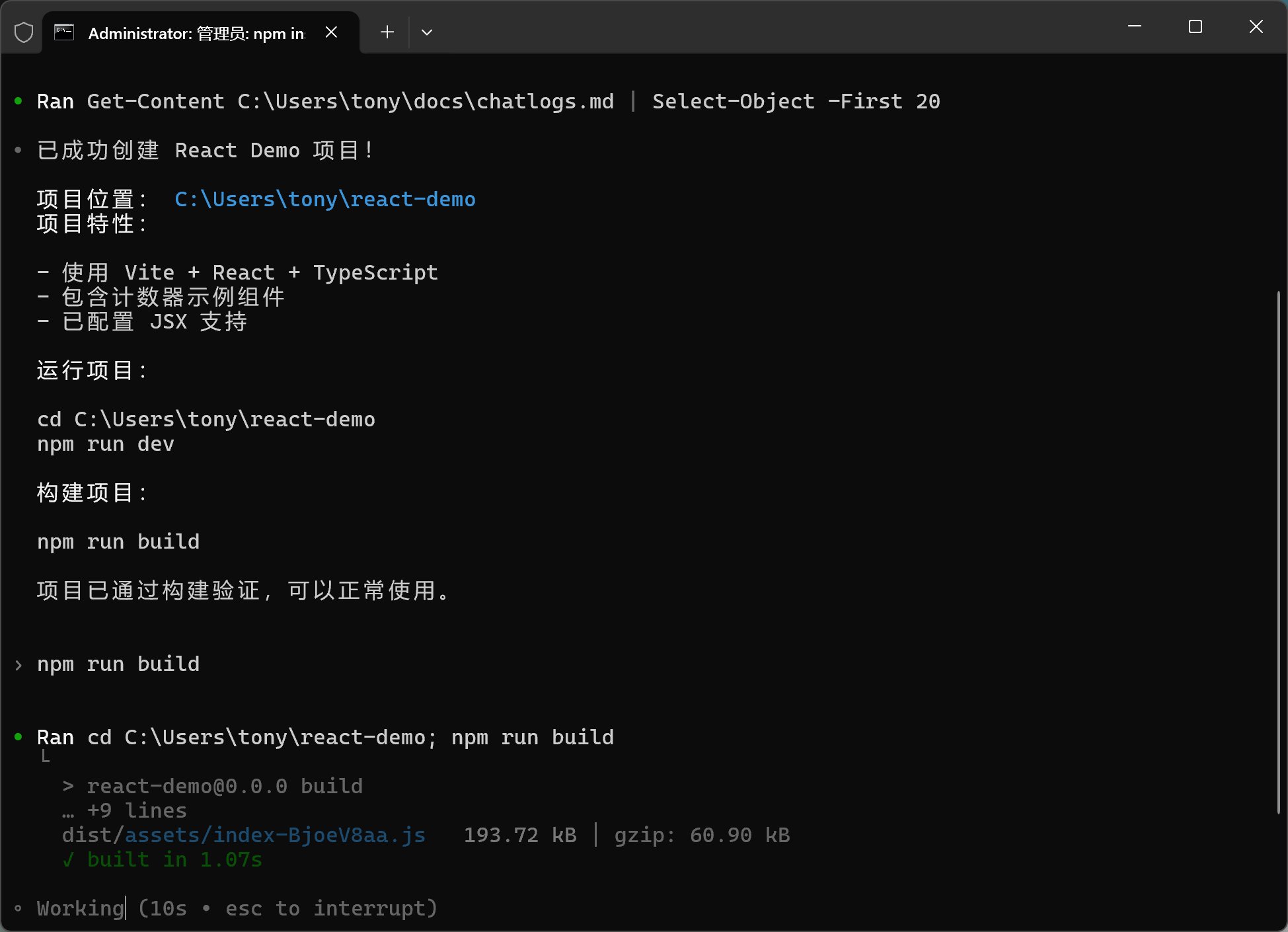

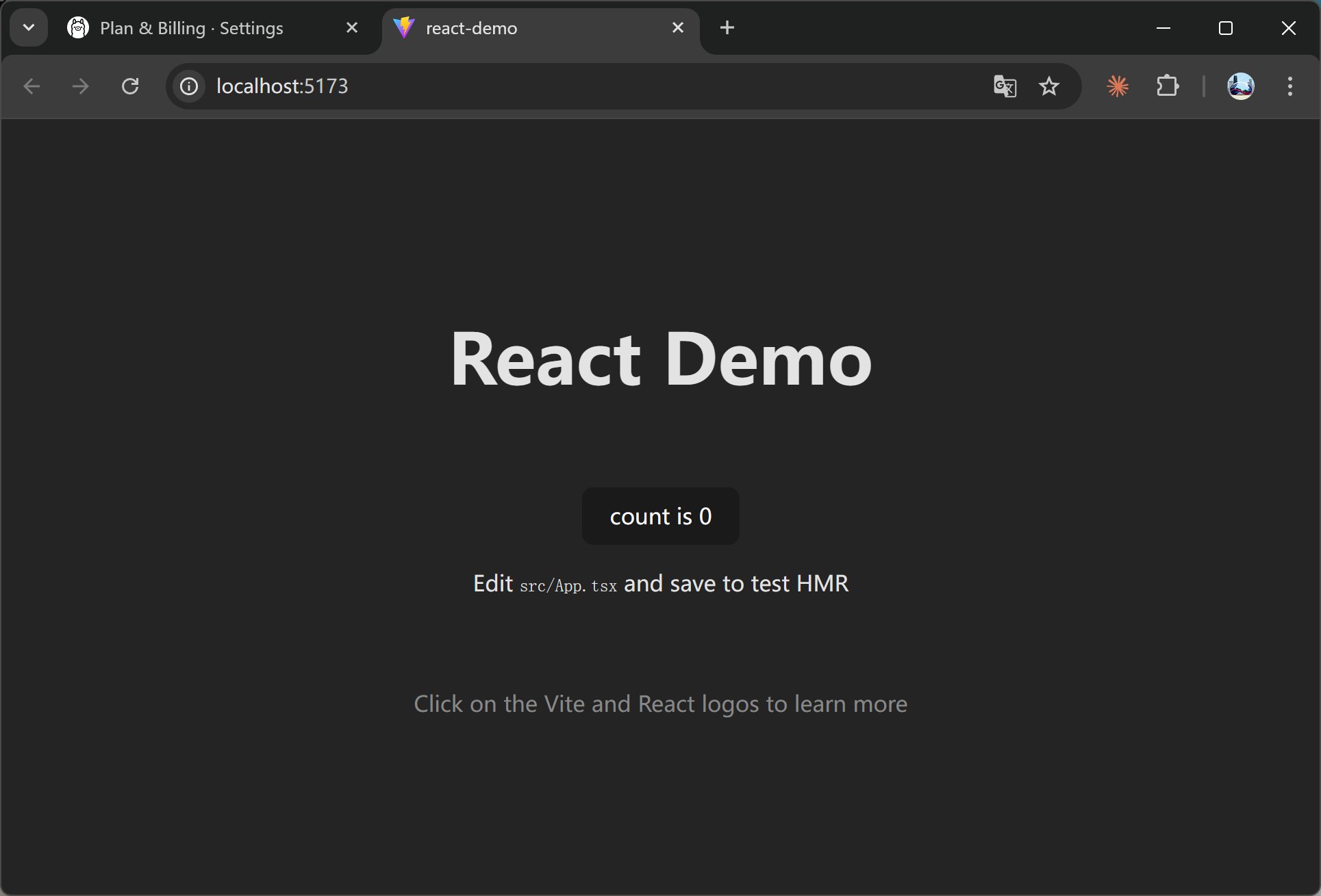

就可以在命令行里面直接输入,比如说:“帮我创建一个 React 的 Demo 项目”,它就会自动调用各种工具帮你创建项目。

没想到 GLM-4.7 在 Codex 上面这么丝滑。

全程零错误构建,一把直接启动:

这一个 demo 跑完大概用掉了 23% 的绘画额度,以及 12% 的周额度。

还可以还可以!

接下来所有的开源模型,都应该针对 Claude Code 或者 Codex 这种智能体进行优化。

这样的话,在不久的将来,在本地(纯本地)的中高配置电脑中使用离线模型进行开发,也不是不可能的。

因为一旦有终端智能体来管理模型,模型的能力是可以超常发挥的。

比如做一些常规的本地电脑命令调用、文件创建等操作,这类任务根本不需要模型有多复杂,但前提是它必须支持工具调用(Tool Calling)才可以。

期待一下,随着 Claude Code 出圈,今年能实干的个人智能体应该可以搞起了。