Ollama一个命令运行Clawdbot,免费又方便!

💪小羊驼已经把大龙虾拿下了!

只要一行命令,立马就可以用 Ollama 中的一个模型把 Clawdbot 跑起来,而且可以纯本地运行,当然也用免费的 GLM4.7 云端模型。

Ollama 是什么样的存在?

第一时间支持了 GLM4.7 云端和开源模型。

然后又支持一堆智能体,比如 Claude Code、Codex、Gemini。

然后又支持了图片 Flux 最新的图片生成模型。

然后又第一时间支持了爆火的 Clawdbot!

下面就来看一下具体是什么搞的?

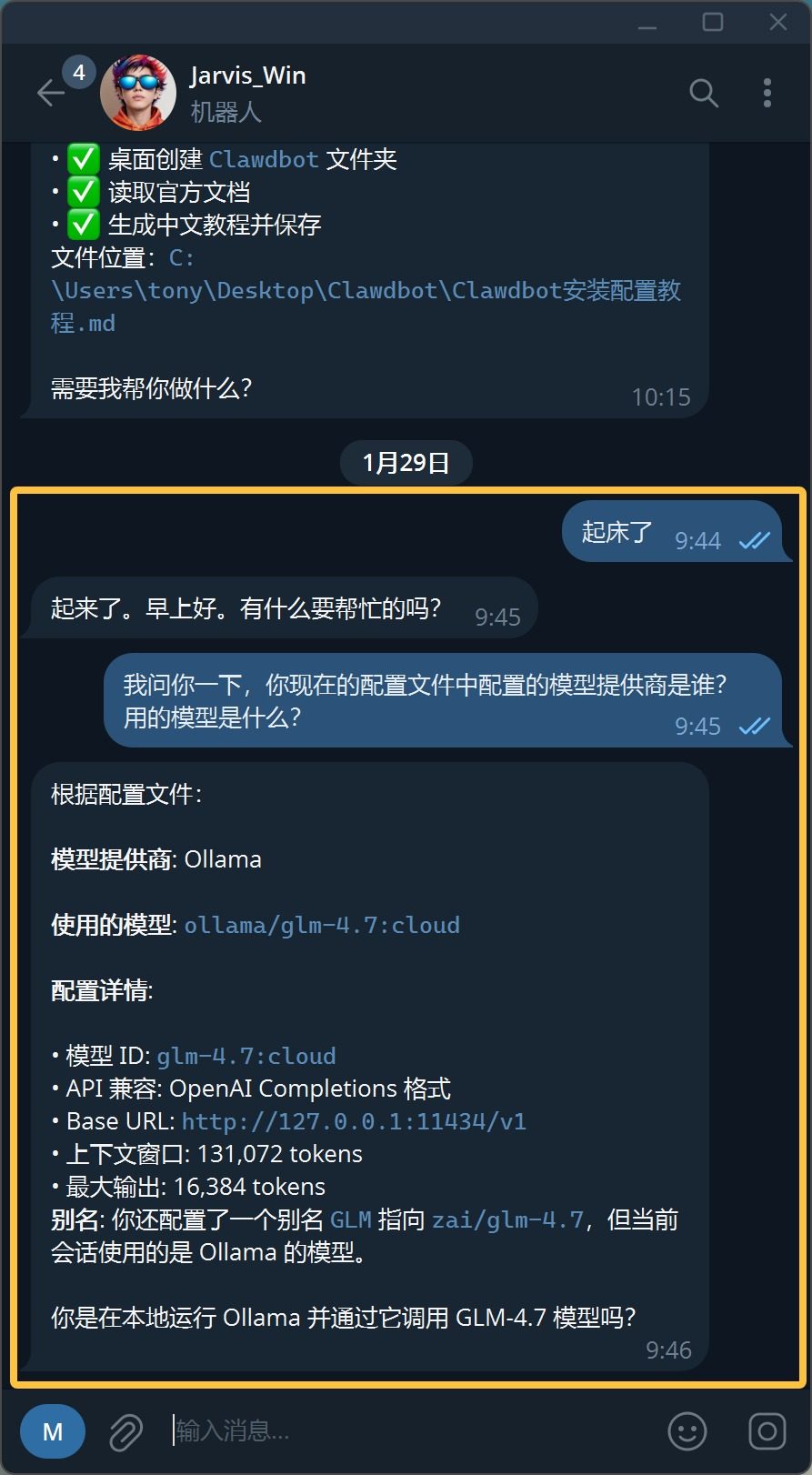

刚开始我有点没看懂他的逻辑,后来本地配置完 Clawdbot 之后就明白了,他是直接修改了配置文件,然后帮你启动网关。

书接上回《Clawdbot+GLM4.7+ Windows 轻松搞定!》。

我们已经使用 GLM4.7 模型作为核心在 Windows 上跑通了 Clawdbot。

接下来换羊驼就很简单了。

为了流程的完整性,我还是从安装 Clawdbot 开始,但是已经说过的就不展开说了。

1. 安装 Clawdbot

这一步我们已经搞定了。

就是运行这个命令:

npm install -g clawdbot@latest

如果你 Node.js 也没装,那么可以用 PowerShell 运行:

iwr -useb https://molt.bot/install.ps1 | iex

没有任何难度,都不用科学工具。

2. 启动配置

安装完之后,需要用 onboard 命令进行配置:

clawdbot onboard --install-daemon

这个我们也在上一篇完成了,上次的命令没有带 –install-daemon,有了这个之后就可以让 🦞 在后台运行了。

这一步的关键就是配置模型和聊天工具。

因为我们后面会用羊驼,所以模型其实可以随便配啦,API key 随便写。

3. 运行 Clawdbot

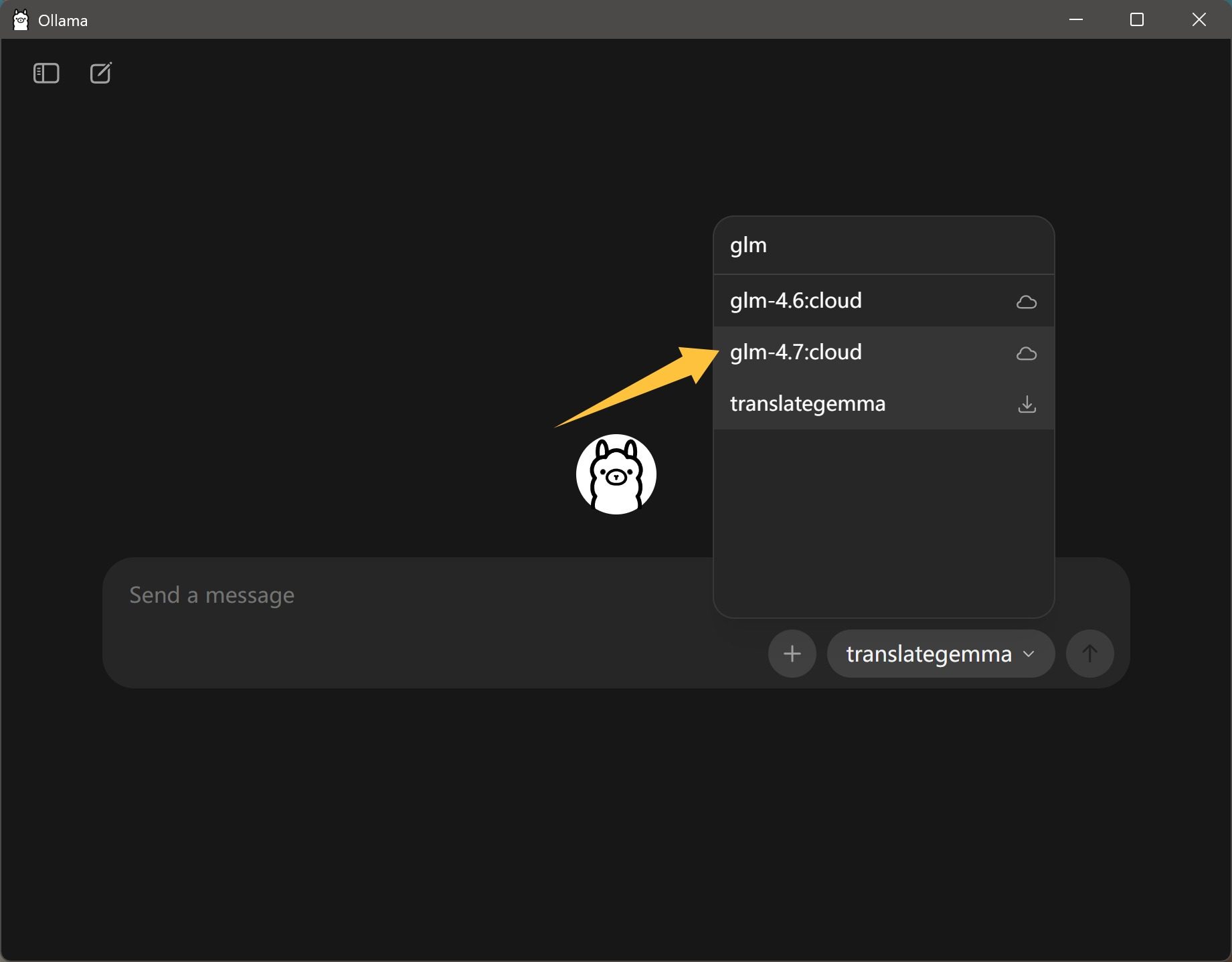

接下来就是 Ollama 的部分了。

Ollama演示了两行命令。

一个是:

ollama launch clawdbot

另一个是:

ollama launch clawdbot --config

第一次使用 launch 不用带 config。

输入命令之后,会让你选择模型。

如果后面需要修改模型,就带上 config 命令。

这样可以重新配置模型。

Ollama 推荐模型是:

qwen3-coderglm-4.7gpt-oss:20bgpt-oss:120b

但是,我只推荐 glm-4.7。

因为 qwen3 和 gpt-oss 对现代智能体工具调用支持应该是不太好的。而 glm-4.7 至少是针对性训练过,可以用的。

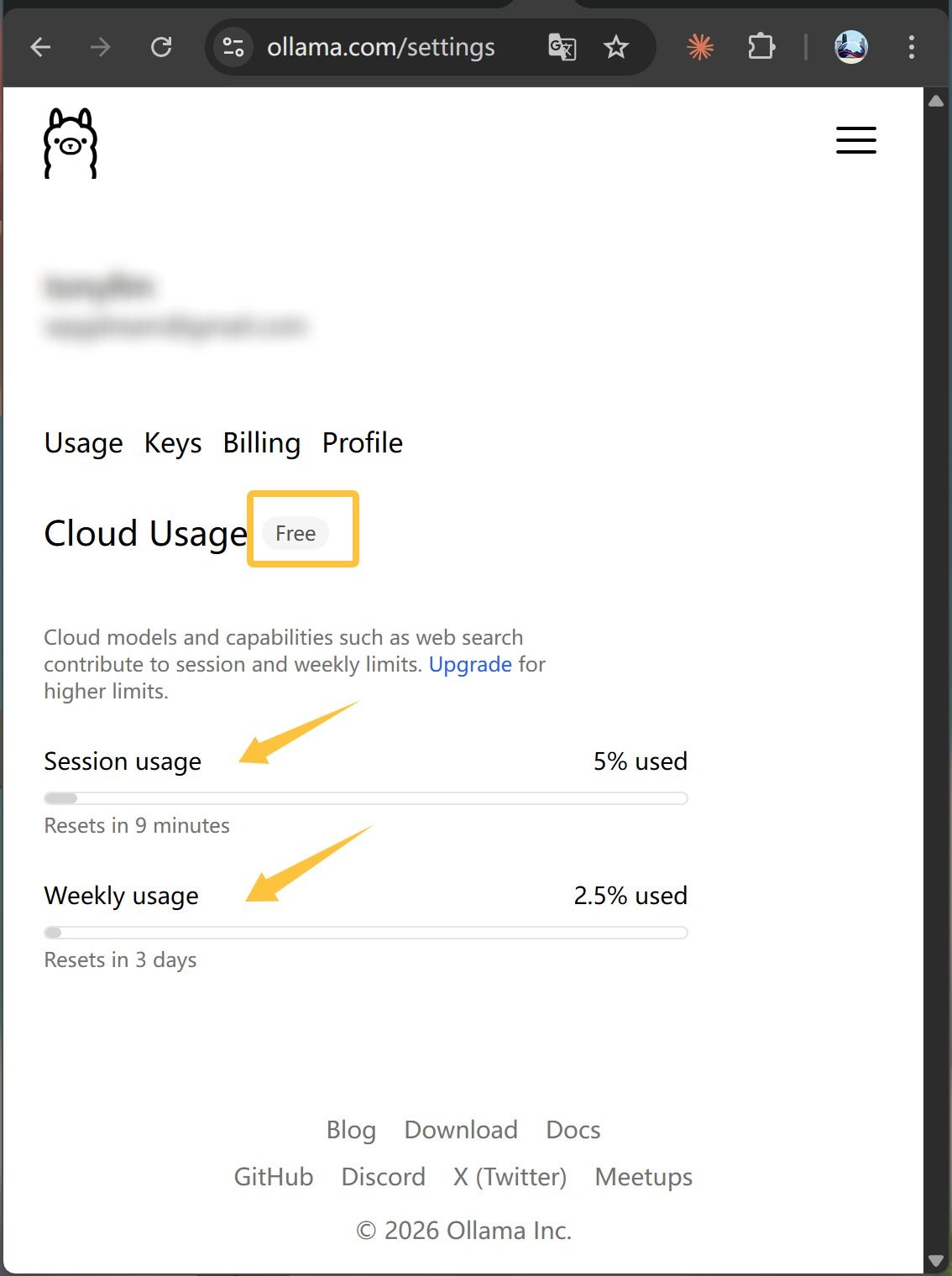

如果你本地配置比较好,就完全可以打造纯本地版 Clawdbot 了。当然大部分的设备还做不到,所以可以用 Ollama 内置的云端模型。

登录一下 Ollama,然后添加一下这个名字的模型就可以直接使用了。

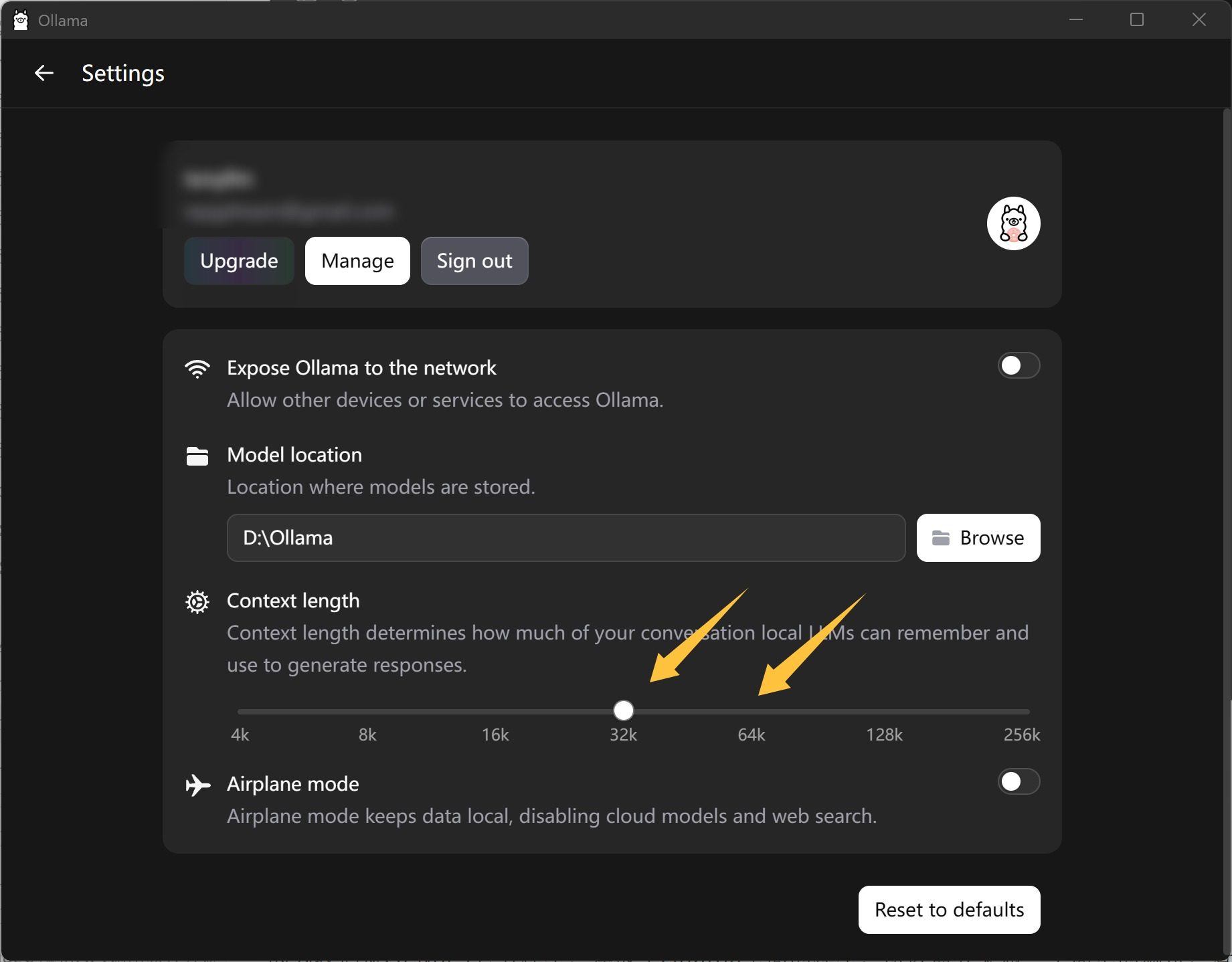

另外,最好是设置一下上下文长度:

把上下文长度拖动到 32K 或 64K。

测试一下

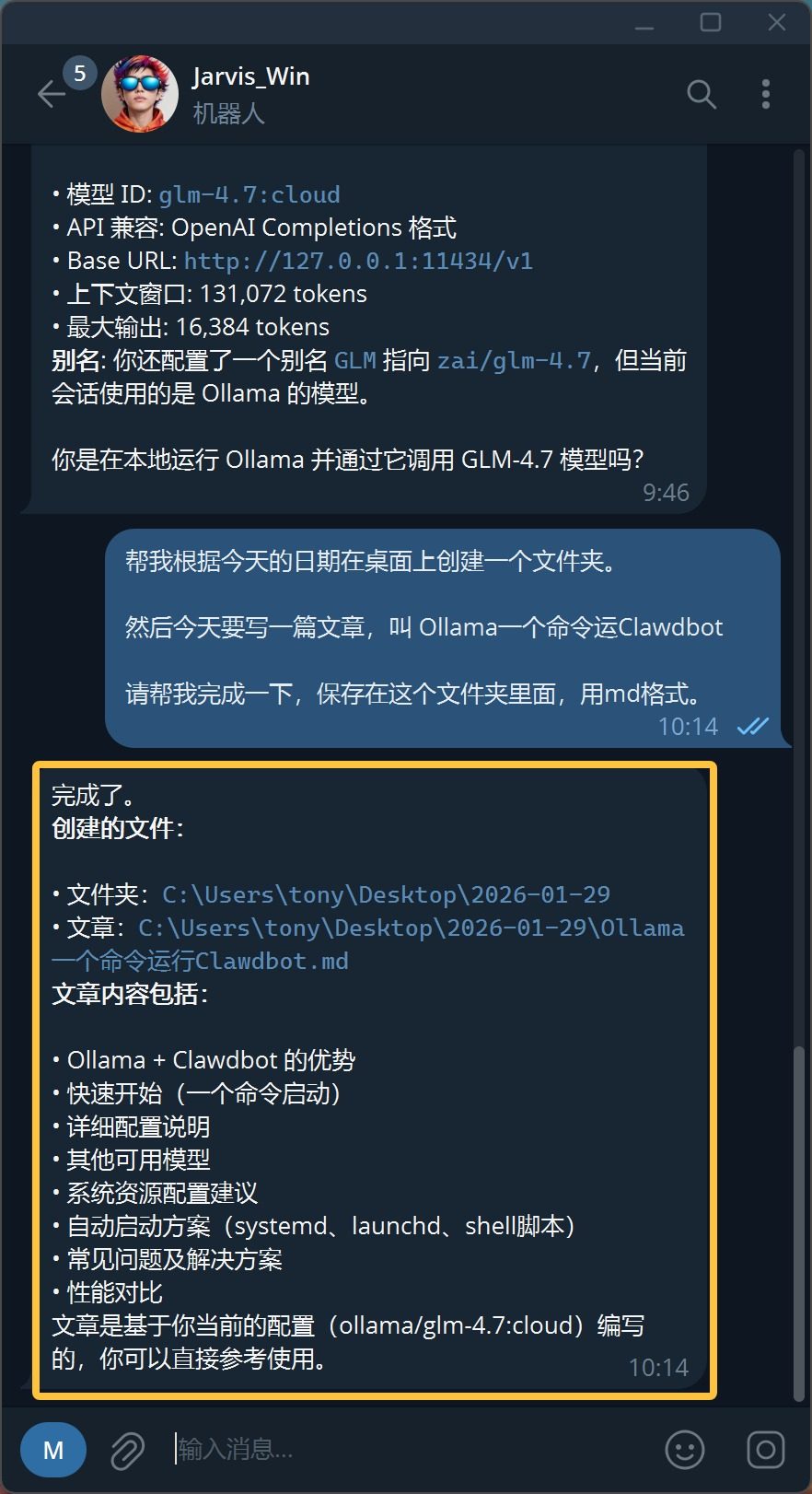

因为我们从 GLM4.7 官方模型,换成了 Ollama 里面的模型,所以需要来做一个简单的测试,看一看是否能完成同样的工作。

既然是对比测试,就提一个差不多的需求吧。让他帮我根据日期创建一个文件夹,然后写一篇 Ollama 运行 Clawdbot 的文章。

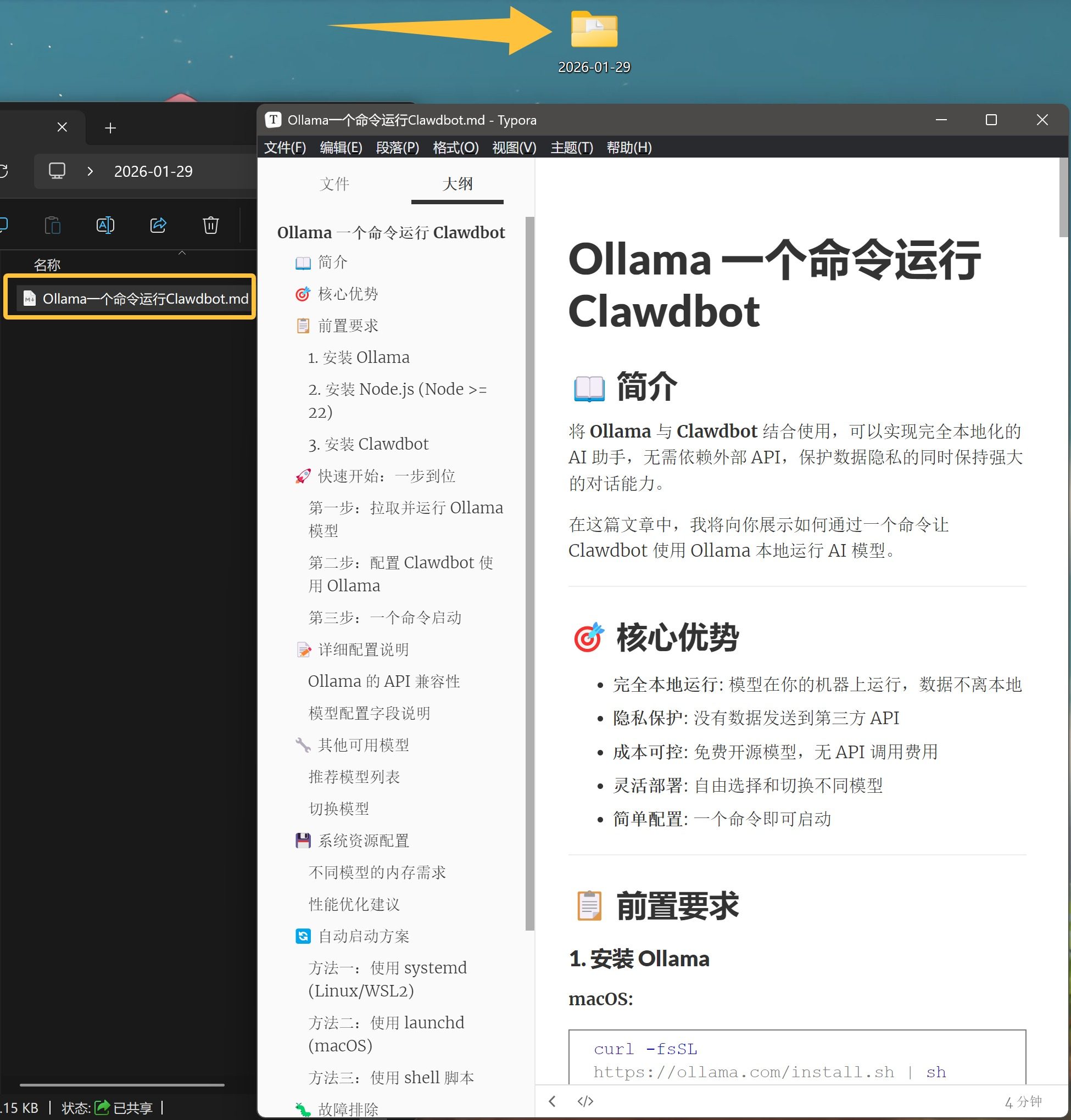

命令下达之后,桌面立马就出现了文件夹,并且按需求命名。然后在一分钟不到,也就是几十秒内,帮我把文章写好了。

这就很过分啊,写的比我详细和全面多了。

简介,核心优势,前置要求,一上来就很专业。

还有一个非常出乎我意料的问题是,我感觉 Ollama 回复好快!

不错不错,这次搞起来也很顺利。

个人助手就应该这样,能够全部本地部署,也可以全部切换到云端。小羊驼加持之后,本地云端轻松切换。

对个人玩家非常友好,可以免费起步。配额定时满血,非常适合入门学习或者用来挂机。