Mac M系列用户看过来!FLUX Kontext 安装和运行测试来了

我16G的5060ti能轻松运行Flux Kontext,那么24G的MacMiniM4没理由用不了吧。所以,时候把M4拉出来遛遛了!这篇文件就是分享MacMini上完整的安装过程,以及运行测试。重点是探索下能不能跑Kontext,跑得速度怎么样。

首先,简单说一下Mac电脑分为Inter和Silicon系列。 Inter系列已经逐渐被放弃了,很多新软件都不太愿意支持Inter版本了。Silicon系列是苹果自家的芯片。

苹果的 M 系列芯片(Apple Silicon) 是典型的 SoC(System on a Chip) 架构,集成了 CPU、GPU、NPU(苹果称为“Neural Engine”),以及其他多个子系统在同一块芯片上。

ComfyUI的桌面版是支持Apple Silicon,所以这次我们直接选择桌面版。安装过程会很简单。

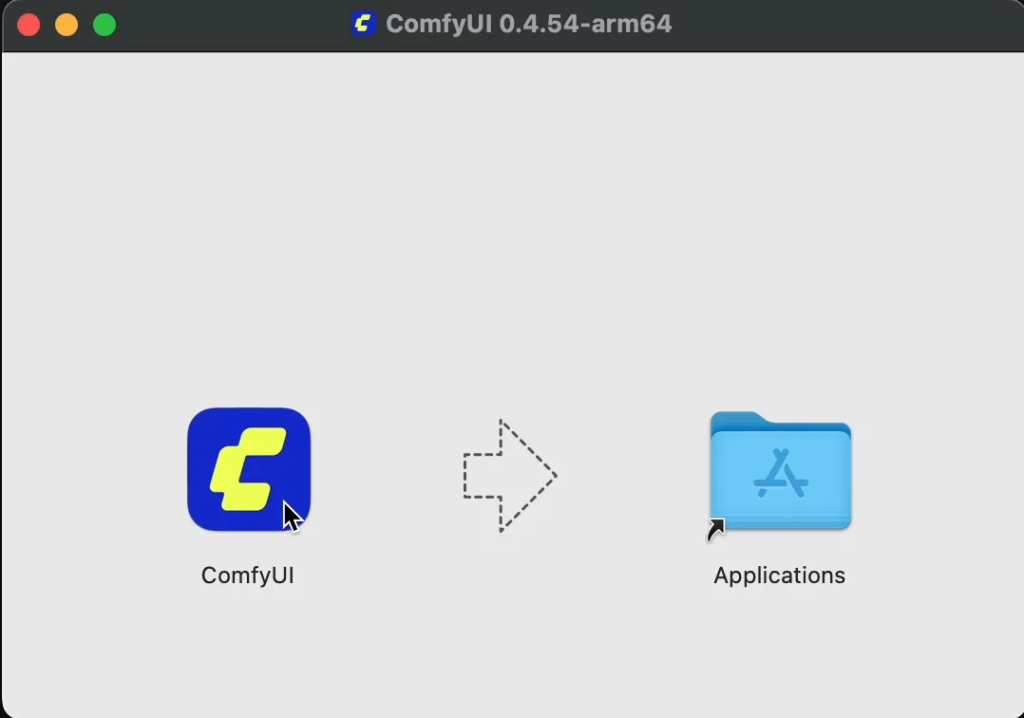

打开comfy.org,直接下载Mac版就可以了。下载完成之后直接双击dmg文件。

这就是一个常规的macos软件安装方式 ,拖动到Application。然后打开ComfyUI

然后就会进入配置页面了,全程可视化配置,没有任何复杂的地方。

点击开始使用

选择GPU类型

按默认选择左边的MPS加速,不启用CPU模型。点击下一步!

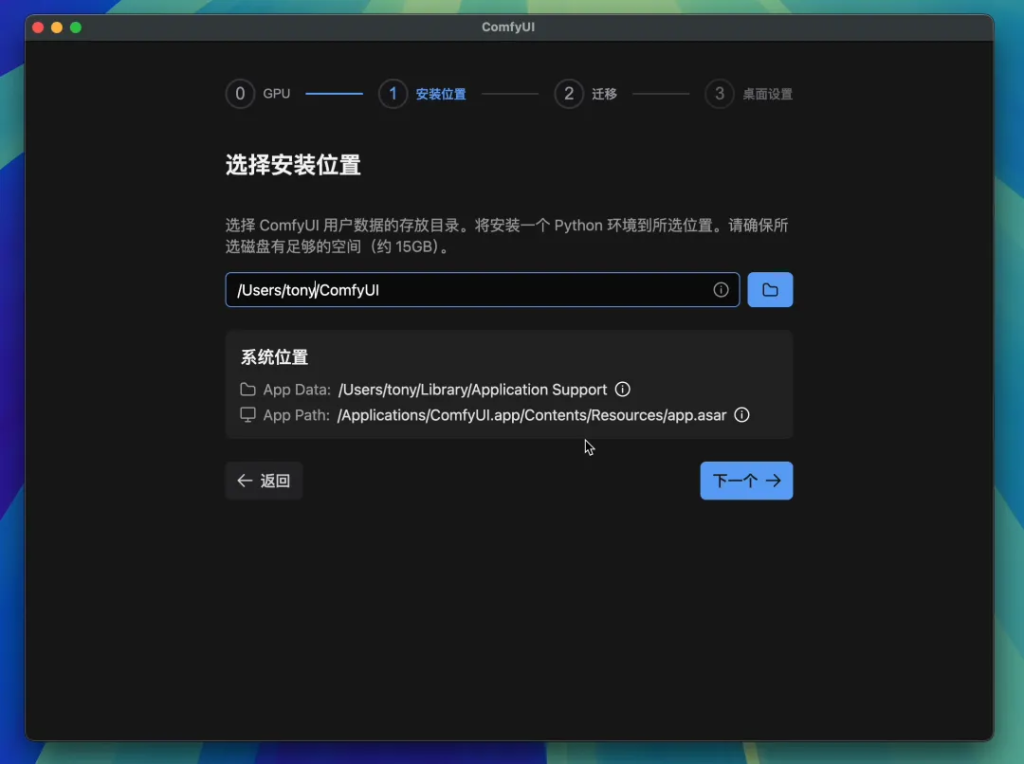

安装位置设置

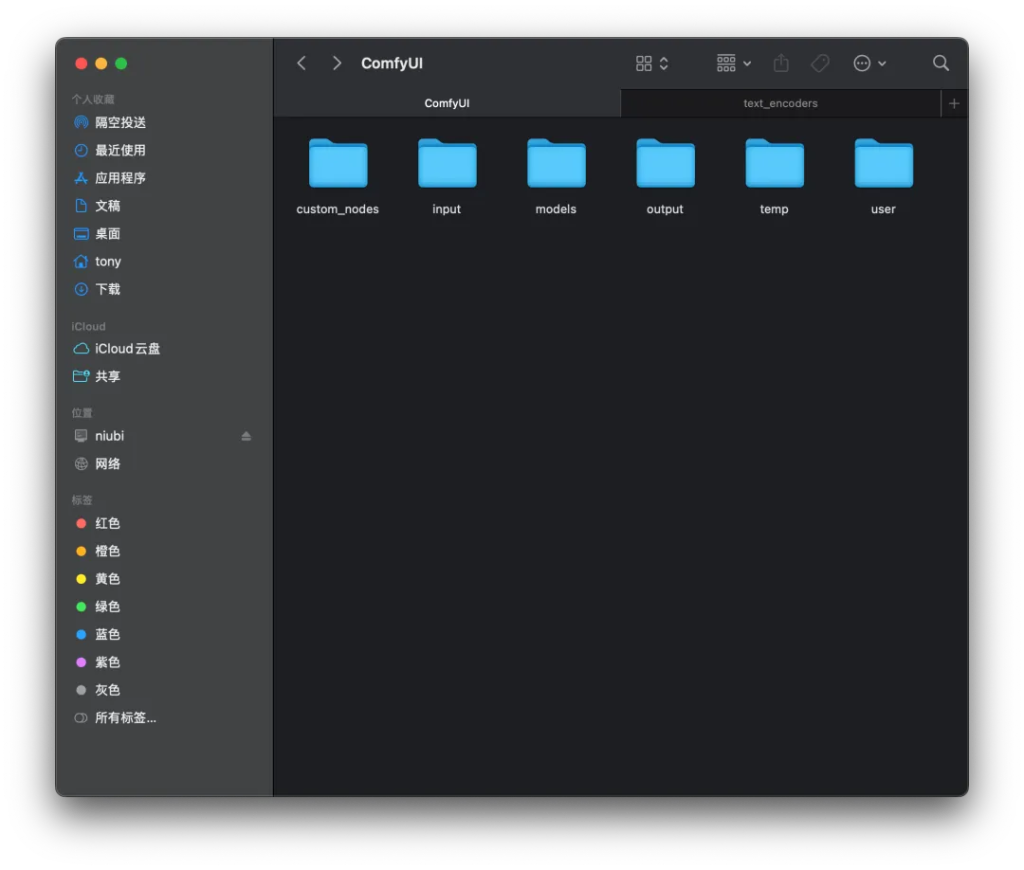

可以设置ComfyUI的主要目录。这个目录里会包含如下的文件:

插件,输入,模型,输出这些都放在 这里。如果没有特殊需求直接下一步,如果有多个硬盘,或者有大的硬盘,就尽量切换到大空间的路径。因为这个目录需要放模型,所需空间会比较大。

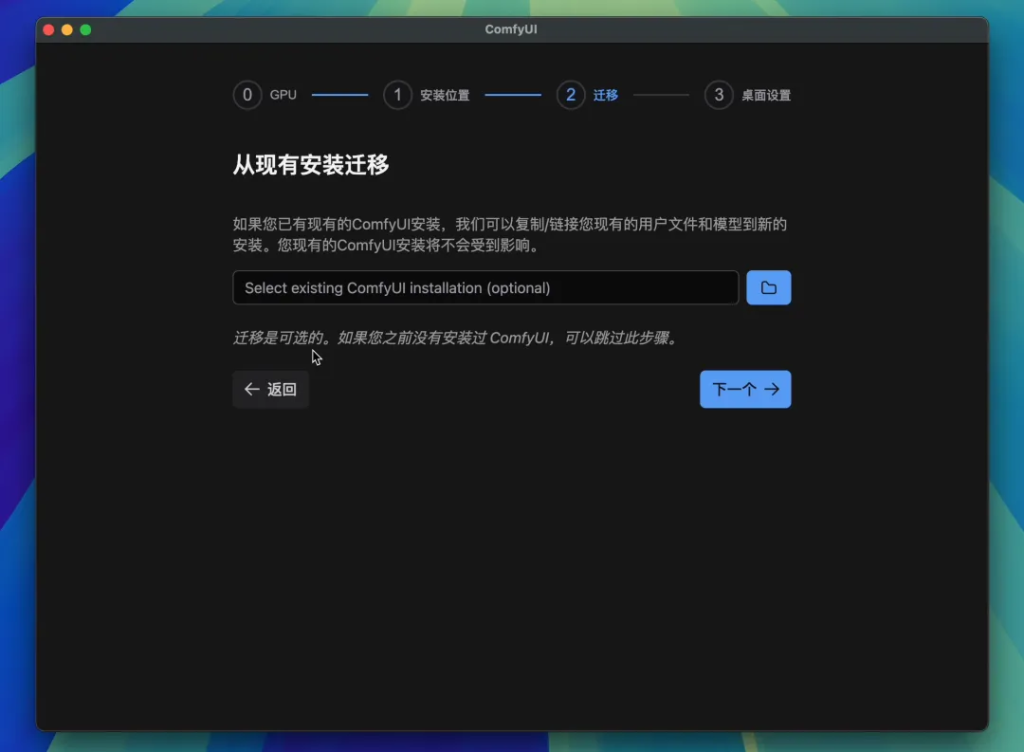

迁移老项目

第一次安装的不要关注这个,直接下一个就可以了。如果你装过,那么这里可以选择之前的安装路径,它会帮你复制或者链接老的用户文件和模型。

桌面设置

这里基本默认就可以了,如果你的网络是内外,可以点开镜像设置。我的网络没问题,他直接打勾✅了,所以我是直接点击安装。

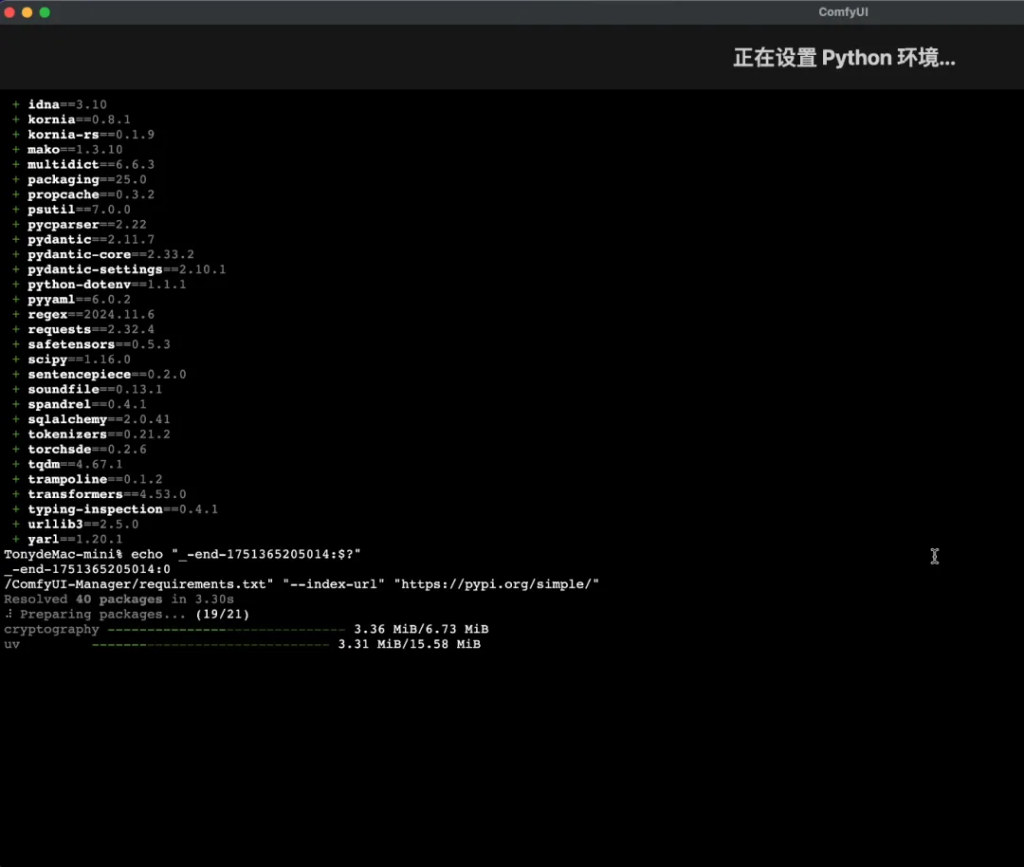

自动设置Python环境和安装依赖

这个过程非常丝滑。

你不需要关心具体细节,它会全自动完成。因为macOS的深度学习包不是很大,也不需要几个G的CUDA,所以即便是在线下载依赖,整个过程也不会太久。

安装完成之后自动启动。

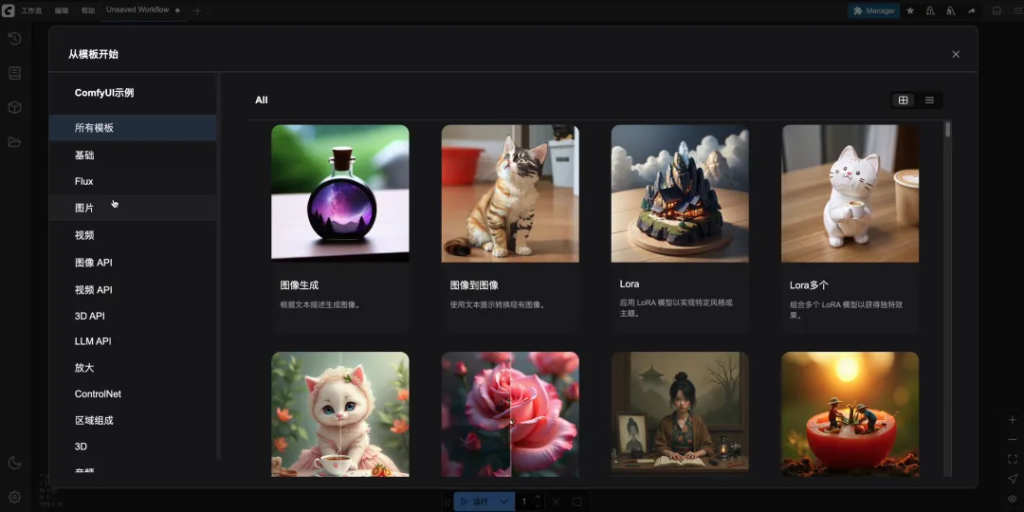

启动之后会弹出模版,让你选择,选好之后就可以开始使用了。到这里之后,后面的操作就和Windows平台差不多了。

同样在演示例子中选择Flux,然后选择小兔子的那个工作流。

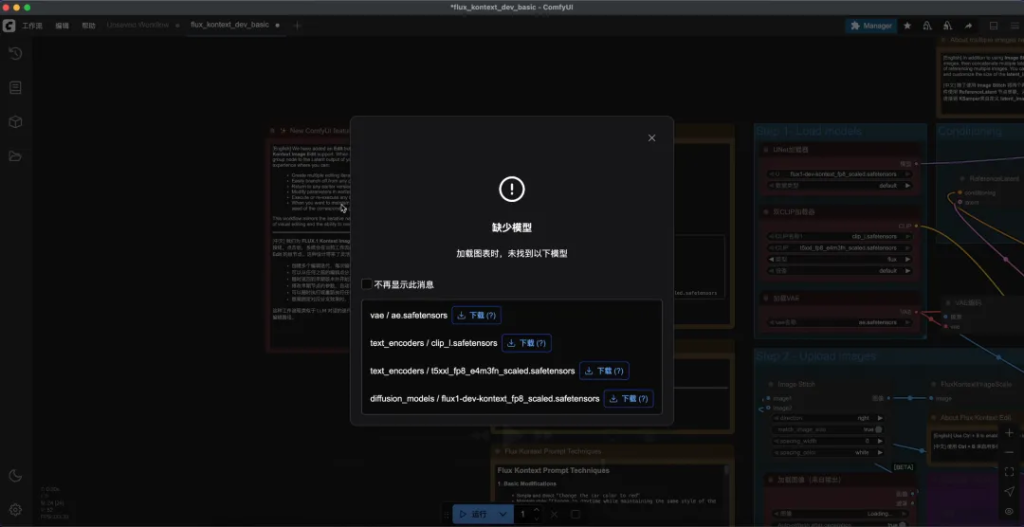

打开之后,他同样会提示你下载几个必要的模型。因为这是桌面端,只要点击一下下载,它会自动帮你下载并放到正确的路径。当然,你也可以直接去Huggingface或者我的网盘上下载之前提供的模型。这个模型是通用的。

下载完成之后,就可以点击运行了。

在运行之前一切顺利,整个过程还挺丝滑。但是点击运行之后就出现问题了。

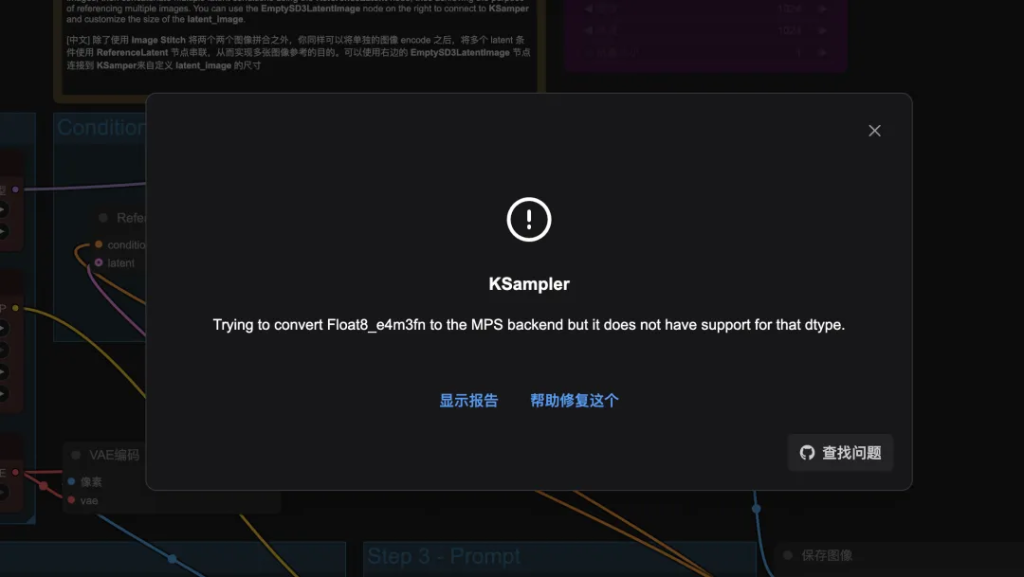

模型加载全部没有问题,但是到了KSampler这一步的时候,就出了错误了。错误提示为:

Trying to convert Float8_e4m3fn to the MPS backend but it does not have support for that dtype.

通过右下角角的查找问题,可以快速转到github的讨论版块,有六个提问,一个已经被解决了,看了一圈也不是特别清楚。但是,我根据他的提示信息盲猜,这应该是数据类型的问题。M系列芯片和N卡支持的数据类型不一样,FP8这种估计只有N卡上可以。

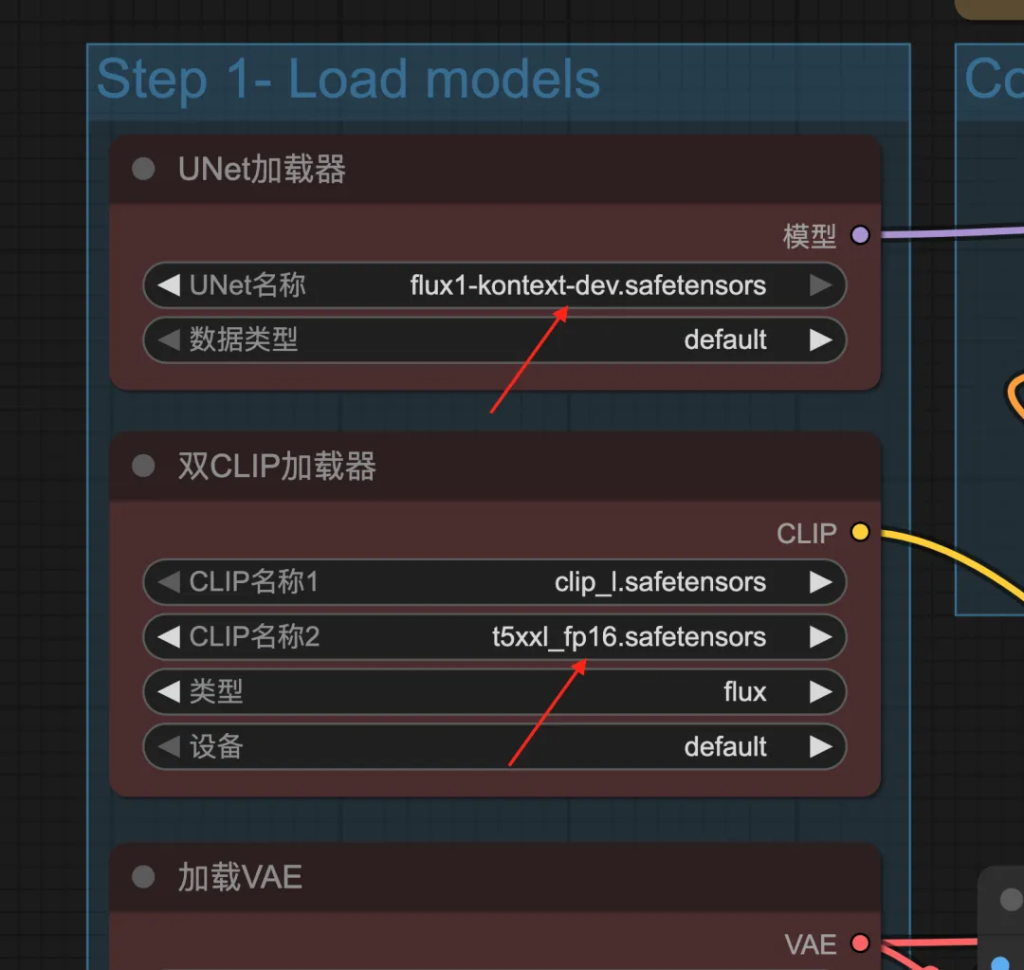

所以,我的思路是下载FP16的FLux模型,FP16的Clip模型。果然,换了模型之后,就没有报错了。两个模型的名字分别为:

# 放到路径: ComfyUI/models/diffusion_modelsflux1-dev-kontext_fp8_scaled.safetensors # 放到路径: ComfyUI/models/text_encoderst5xxl_fp16.safetensors

下载地址分别为:

# 黑森林官方HF https://huggingface.co/black-forest-labs/FLUX.1-Kontext-dev # ComfyUI官方HF https://huggingface.co/comfyanonymous/flux_text_encoders

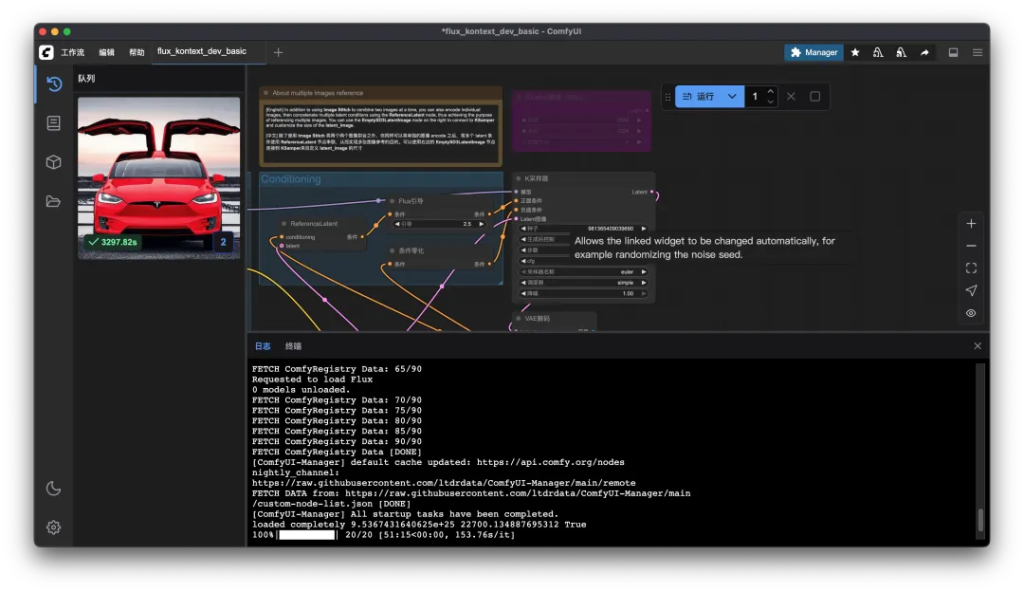

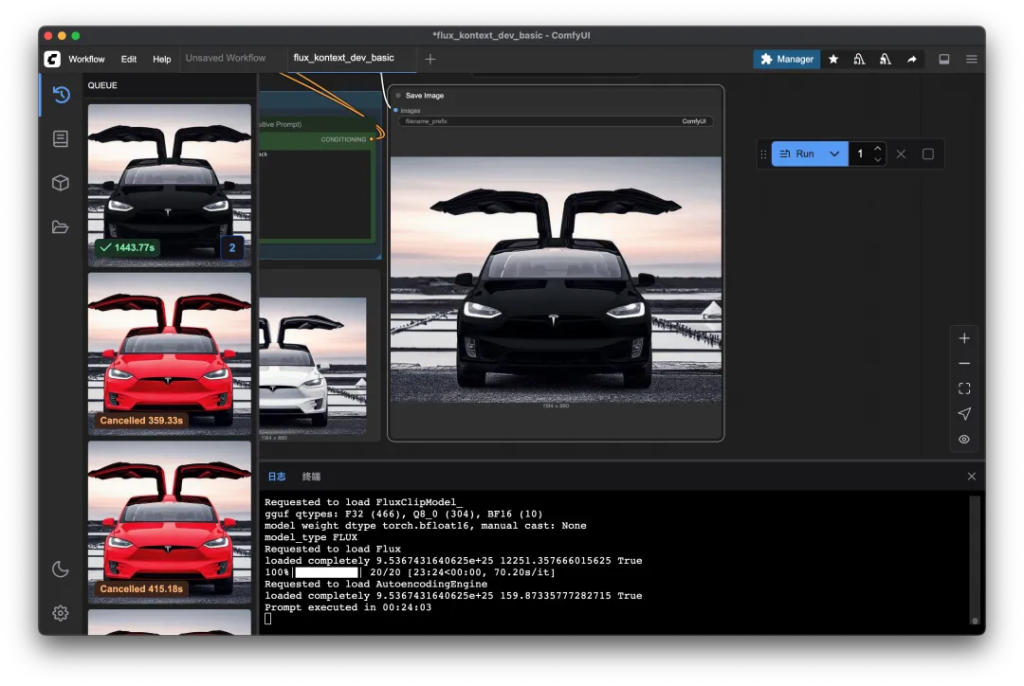

换了模型之后就可以正常生成图片。但是…. 时间有点久。

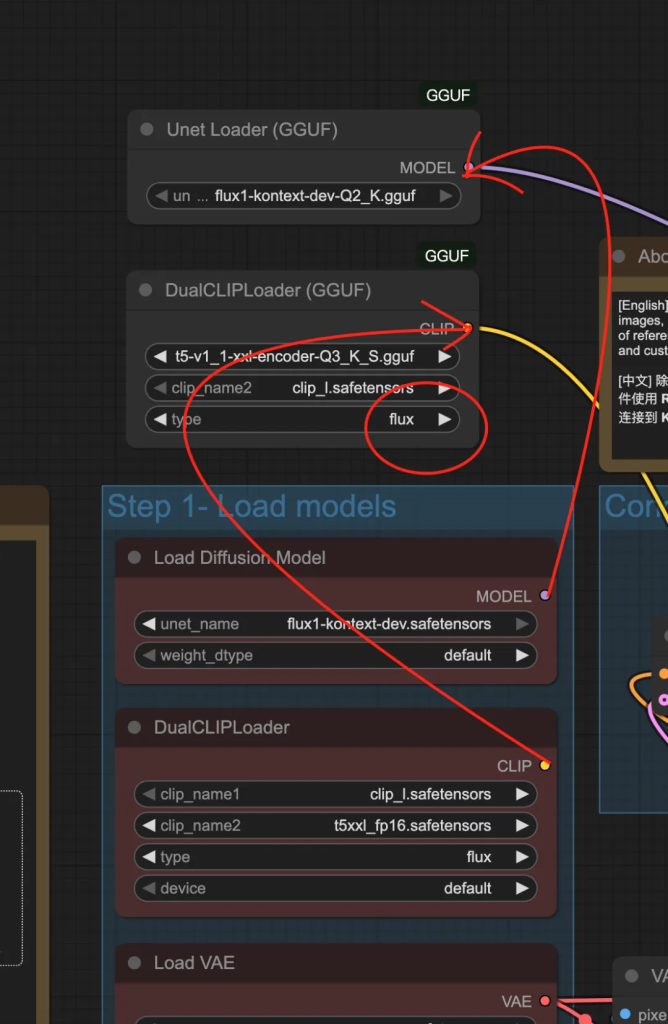

我实测是用了51分15秒!这个时间,让人有点崩溃!天知道为了在m4上整这一套我花了多少时间!必须优化下!借用Windows的优化思路,同时考虑到M系列对GGUF支持比较好。我就在M4上也安装了GGUF插件,然后加载了GGUF模型。具体的模型获取方式,可以参考上一篇文章。

这一套整完之后,速度提升了不少,来到了23分34秒(Q8量化)。

使用Kontext Q2,Q4,Q8等不同量化模型,似乎并不影响执行时间。

大语言模型在M系列芯片上已经达到了勉强能用的程度,但是Flux等AI图片生成应用,还是有点难,这个速度玩一下可以,但是一直这么用会有点崩溃。

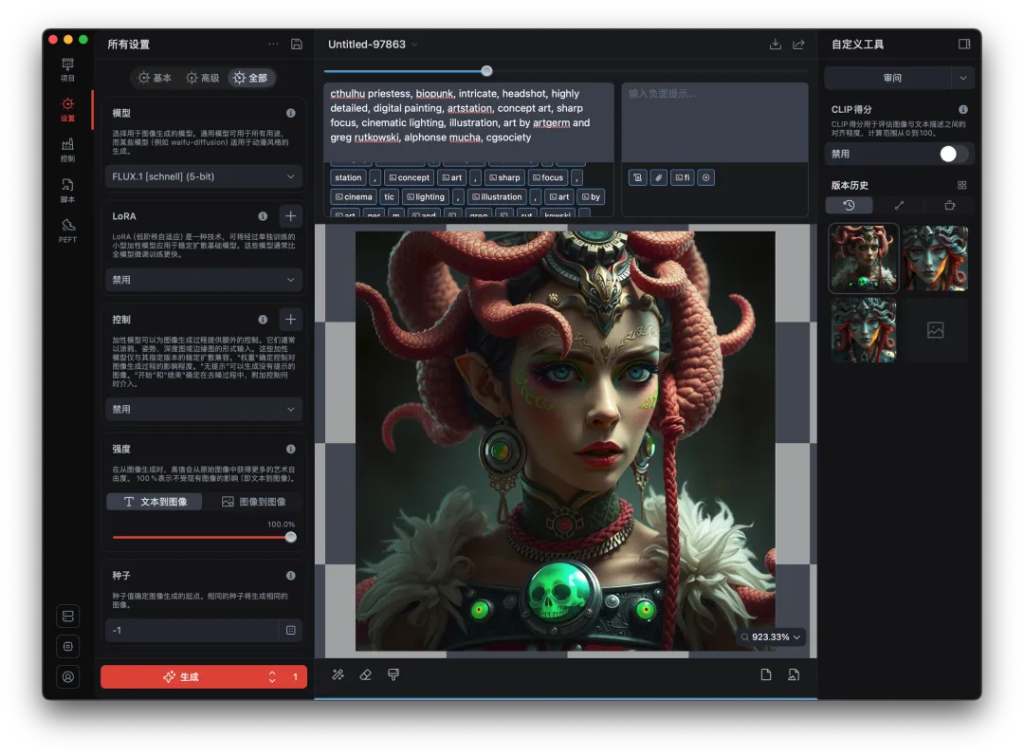

另外,我在查资料的时候,有一些发现,也一并分享一下。在macOS的应用市场里面有一款不错的AI画图软件。安装和使用都非常简单,速度上比ComfyUI快几分钟。

软件的名字叫 DrawThings:Offline AI Art

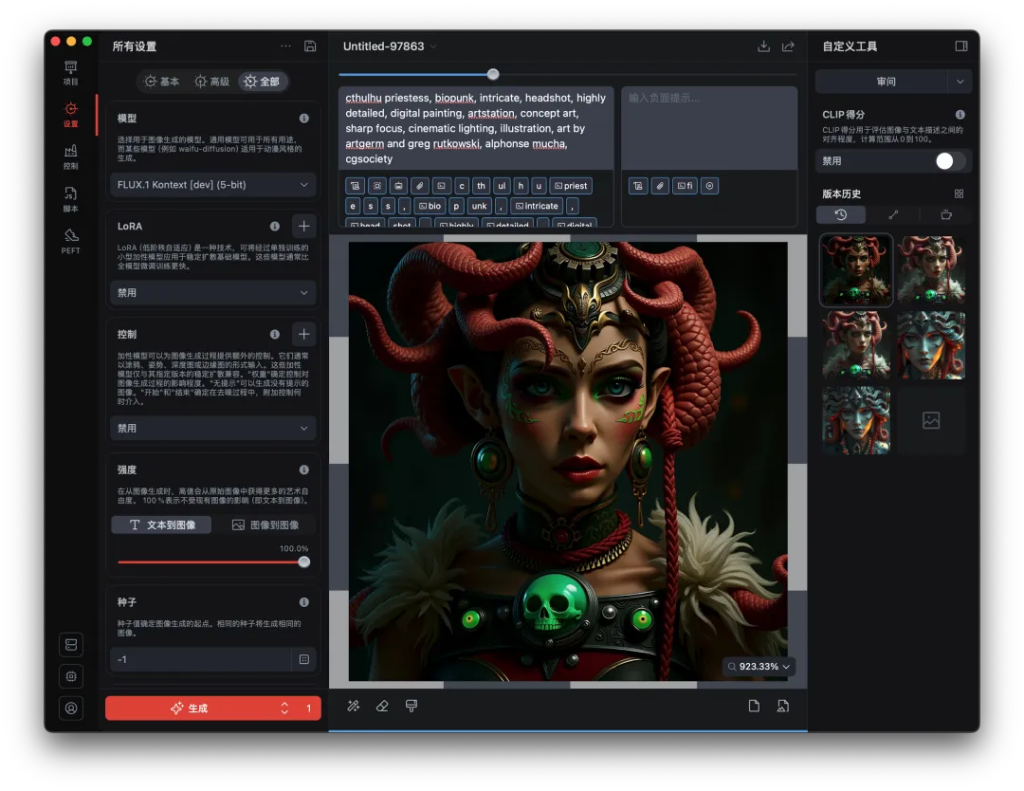

这个软件做得挺不错。安装很方便,使用简单。支持大部分主流的AI绘画模型,可以完全本地运行,可以使用官方模型,也可以自己导入,也可以调用API,也有不少的参数可以设置。

它已经支持Flux Kontext了。

我下载了5-bit的模型,试了一下生产速度大概在17分钟左右。

FLux Schnell(5-bit)的话大概只要7分钟左右。

在MacMiniM4上跑FLux和Kontext的情况大致就是这样了,苹果上运行AI还是任重道远。苹果对AI的反应实在是慢了些 ,无论是电脑还是手机。加油吧啊!

下一篇,我们还是回到WIndows,把出图速度提升个六七倍!